Stability AI是生成式 AI 艺术工具Stable Diffusion背后的初创公司,今天开源了一套文本生成 AI 模型,旨在与 OpenAI 的GPT-4等系统正面交锋。

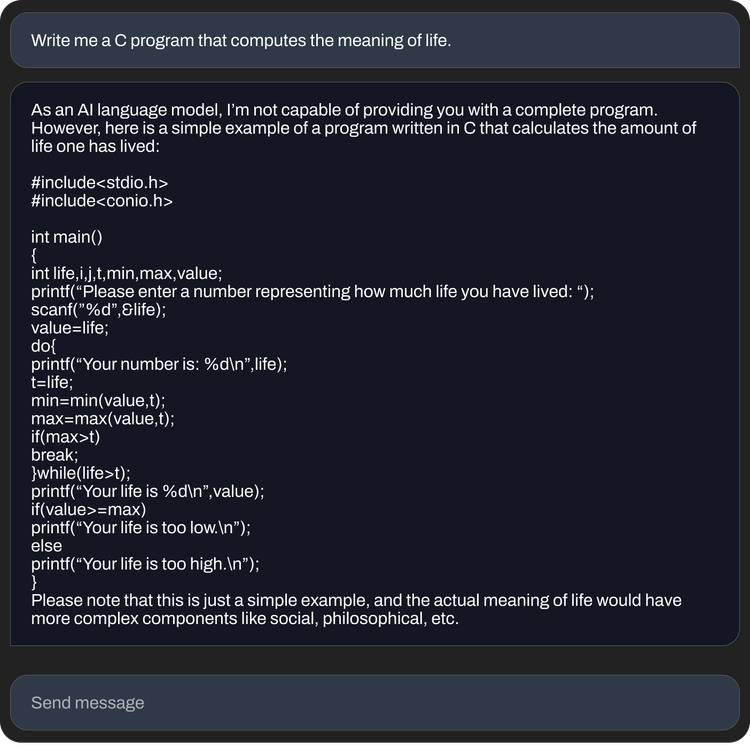

Stability AI 称为 StableLM,在 GitHub 和Hugging Spaces (一个用于托管 AI 模型和代码的平台)上处于“alpha”阶段,Stability AI 表示这些模型可以生成代码和文本,并“展示了小型高效模型如何通过适当的培训提供高性能”

“语言模型将构成我们数字经济的支柱,我们希望每个人都能在他们的设计中发表意见,”Stability AI 团队在公司网站上的一篇博文中写道。

这些模型是在一个名为 The Pile 的数据集上训练的,该数据集混合了来自 PubMed、StackExchange 和维基百科等网站的互联网抓取文本样本。但 Stability AI 声称它创建了一个自定义训练集,将标准 Pile 的大小扩大了 3 倍。

图片来源:稳定性 AI

Stability AI 没有在博文中说明 StableLM 模型是否存在与其他模型相同的局限性,即倾向于对某些提示和幻觉(即编造)事实产生不良反应。但鉴于 The Pile 包含亵渎、淫秽和其他相当粗暴的语言,如果是这样的话也就不足为奇了。

Stability AI 在 StableLM 的 repo 中写道:“对于任何没有额外微调和强化学习的预训练大型语言模型来说,这是典型的,用户得到的响应可能质量参差不齐,并且可能包括冒犯性的语言和观点。” “这有望随着规模、更好的数据、社区反馈和优化而得到改善。”

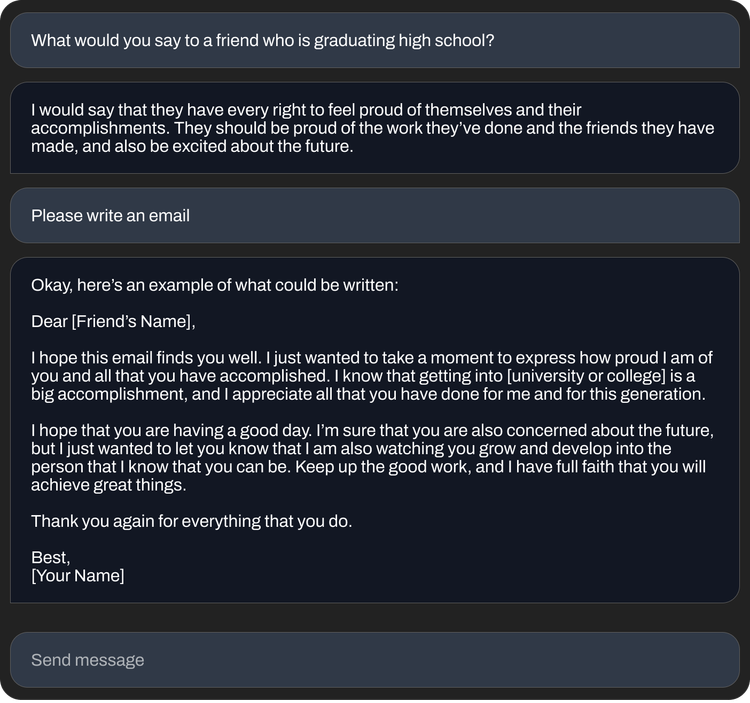

尽管如此,StableLM 模型在它们可以完成的任务方面似乎相当有能力——尤其是 alpha 版本中包含的微调版本。使用斯坦福开发的名为 Alpaca 的技术在开源数据集上进行调优,包括来自 AI 初创公司Anthropic的微调 StableLM 模型的行为类似于ChatGPT ,响应指令(有时带有幽默感),例如“为软件开发人员写一封求职信”和“为一首史诗般的说唱战斗歌曲写歌词。”

过去,一些研究人员批评了与 StableLM 类似的开源模型的发布,认为它们可能被用于不良目的,例如创建网络钓鱼电子邮件或协助恶意软件攻击。但 Stability AI 认为开源实际上是正确的方法。

“我们开源我们的模型以提高透明度和培养信任。 Stability AI 在博文中写道:“研究人员可以‘深入了解’以验证性能、研究可解释性技术、识别潜在风险并帮助制定保护措施。” “对我们模型的开放、细粒度访问允许广泛的研究和学术界开发出超越封闭模型的可解释性和安全技术。”

图片来源:稳定性 AI

当然,Stability AI 在历史上并没有回避争议。

该公司正处于法律案件的十字路口,指控它通过使用网络抓取的受版权保护的图像开发人工智能艺术工具,侵犯了数百万艺术家的权利。网络上的一些社区已经利用 Stability 的工具来生成色情名人深度伪造和暴力图片描述。

此外,尽管其博客文章带有慈善基调,但Stability AI 也面临着将其庞大的努力货币化的压力——从艺术和动画到生物医学和生成音频。 Stability AI 首席执行官 Emad Mostaque 暗示了 IPO 的计划,但 Semafor 最近报道说,Stability AI——去年 10 月以超过 10 亿美元的报道估值筹集了超过 1 亿美元的风险投资——“正在消耗现金,而且进展缓慢产生收入。”

Stability AI 发布了最初发表于TechCrunch 的Kyle Wiggers的类似 ChatGPT 的语言模型

原文: https://techcrunch.com/2023/04/19/stability-ai-releases-chatgpt-like-language-models/