Leonard Lin 和 Adam Lensenmayer 已经致力于Shisa 项目一段时间了。他们将最新发布的项目描述为“日本表现最佳的法学硕士项目”。

Shisa V2 405B 是日本迄今为止性能最高的法学硕士 (LLM),在我们的评估测试中超越了 GPT-4 (0603) 和 GPT-4 Turbo (2024-04-09)。(在日本 MT-Bench 上,它的表现也与 GPT-4o (2024-11-20) 和 DeepSeek-V3 (0324) 不相上下!)

405B 版本是他们于 4 月份发布的六个较小 Shisa v2 模型的后续产品,它们采用了与 DeepSeek-R1类似的方法,产生了不同的模型,每个模型都扩展了 Llama、Qwen、Mistral 和 Phi-4 的不同现有基础模型。

新款 405B 型号以 Llama 3.1 405B Instruct 为基础,并在Llama 3.1 社区许可下使用。

Shisa 是主权人工智能的一个突出例子——各国能够建立反映自身语言和文化的模型:

我们坚信,在日本(以及全球!)开发本土人工智能非常重要,这不仅是为了文化多样性和语言保护,也是为了数据隐私和安全、地缘政治弹性,以及最终的独立。

我们相信,开源方法是实现人工智能主权的唯一现实途径,这不仅适用于日本,甚至不仅适用于民族国家,也适用于整个国际社会。

随附的概述报告有一些有趣的细节:

训练 405B 模型极其困难。据我们所知,只有另外三个团队:Nous Research、Bllossom 和 AI2 发布了 Llama 405B 的完整微调版本。[…] 我们实施了所有可用的优化措施,包括:DeepSpeed ZeRO-3 参数和激活卸载、梯度累积、8 位分页优化器和序列并行。即便如此,405B 模型仍然勉强适应 H100 的内存限制。

除了新模型之外,Shisa 团队还发布了shisa-ai/shisa-v2-sharegpt ,其中包含 180,000 条记录,他们将其描述为“一流的合成数据集,可免费用于提高任何模型的日语能力。根据 Apache 2.0 许可”。

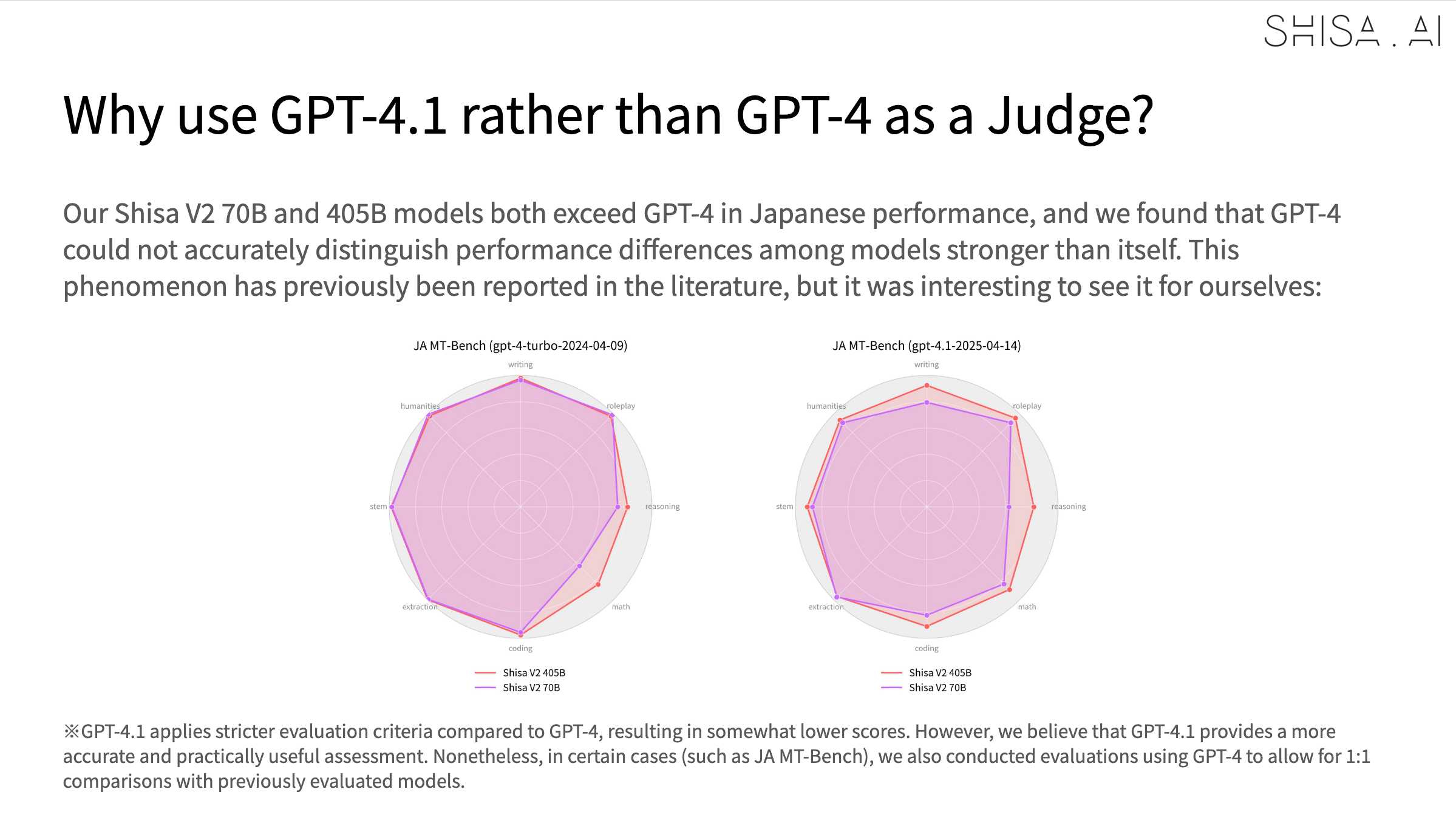

有趣的是,他们发现由于 Shisa 在日语方面的表现优于 GPT-4,该模型不再能够帮助评估,因此他们不得不升级到 GPT-4.1:

标签:翻译、 LLM 发布、评估、生成式人工智能、骆驼、人工智能、 LLMS 、微调、伦纳德林

原文: https://simonwillison.net/2025/Jun/3/shisa-v2/#atom-everything