人们常说,与 OpenAI 的ChatGPT类似的大型语言模型 (LLM) 是一个黑匣子,当然,这有一定道理。即使对于数据科学家来说,也很难知道为什么模型总是以它的方式做出反应,就像凭空捏造事实一样。

为了剥离 LLM 的层次,OpenAI 正在开发一种工具来自动识别 LLM 的哪些部分对其行为负责。它背后的工程师强调它还处于早期阶段,但运行它的代码从今天早上开始就可以在 GitHub 上以开源方式获得。

OpenAI 的可解释性团队经理 William Saunders 在电话采访中告诉 TechCrunch:“我们正在尝试 [开发方法] 预测人工智能系统会出现什么问题。” “我们希望真正能够知道我们可以相信模型在做什么以及它产生的答案。”

为此,OpenAI 的工具使用语言模型(具有讽刺意味的是)来计算其他架构更简单的 LLM 组件的功能——特别是 OpenAI 自己的 GPT-2。

OpenAI 的工具试图模拟 LLM 中神经元的行为。

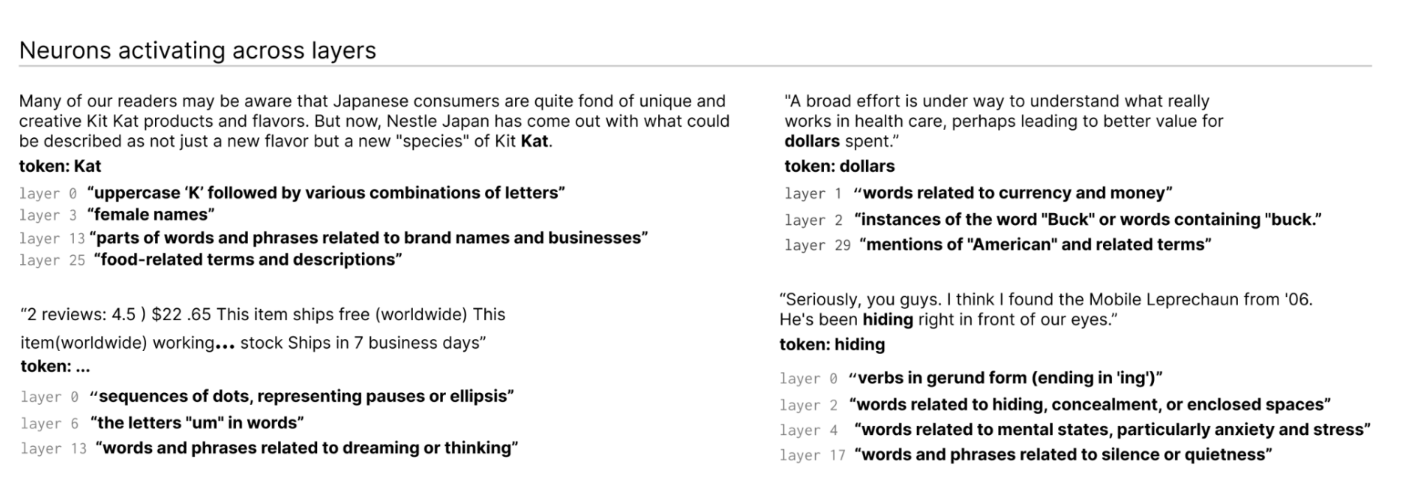

如何?首先,快速解释 LLM 的背景知识。就像大脑一样,它们由“神经元”组成,这些神经元观察文本中的某些特定模式以影响整个模型接下来“说”的内容。例如,给出关于超级英雄的提示(例如“哪些超级英雄拥有最有用的超能力?”),“漫威超级英雄神经元”可能会提高模型从漫威电影中命名特定超级英雄的概率。

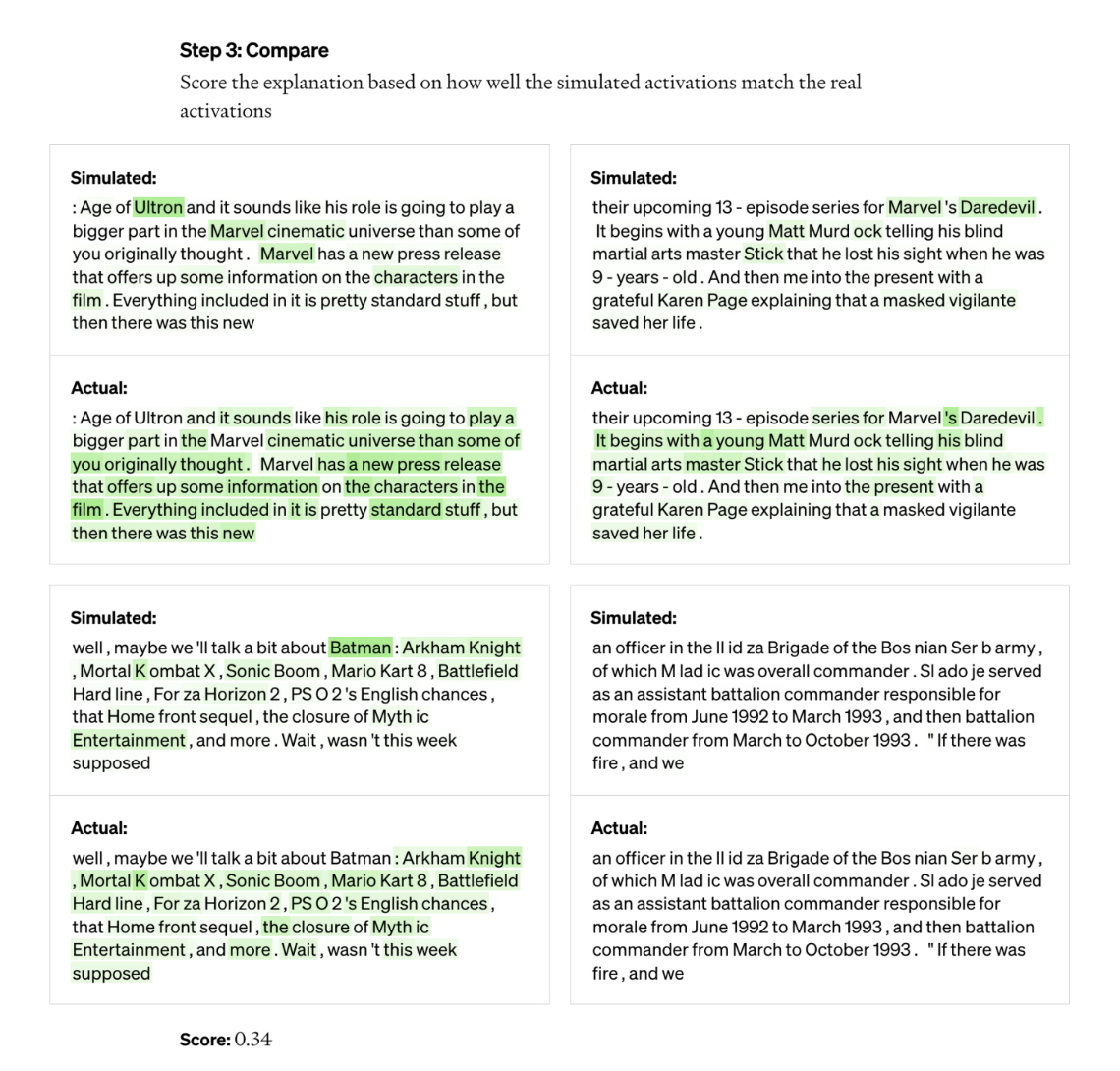

OpenAI 的工具利用此设置将模型分解为各个部分。首先,该工具通过正在评估的模型运行文本序列,并等待特定神经元频繁“激活”的情况。接下来,它“展示”OpenAI 最新的文本生成 AI 模型 GPT-4,这些高度活跃的神经元,并让 GPT-4 生成解释。为了确定解释的准确性,该工具为 GPT-4 提供了文本序列,并让它预测或模拟神经元的行为方式。然后将模拟神经元的行为与实际神经元的行为进行比较。

“使用这种方法,我们基本上可以为每个神经元提出某种初步的自然语言解释,说明它在做什么,并对该解释与实际行为的匹配程度进行评分,”领导者 Jeff Wu, OpenAI 的可扩展对齐团队说。 “我们使用 GPT-4 作为过程的一部分来解释神经元正在寻找什么,然后对这些解释与它正在做的事情的实际情况相匹配的程度进行评分。”

研究人员能够为 GPT-2 中的所有 307,200 个神经元生成解释,他们将这些神经元编译成一个数据集,该数据集已与工具代码一起发布。

研究人员说,有一天可以使用这样的工具来提高法学硕士的表现——例如减少偏见或毒性。但他们承认,在它真正有用之前还有很长的路要走。该工具对其中约 1,000 个神经元(仅占总数的一小部分)的解释充满信心。

一个愤世嫉俗的人也可能会争辩说,该工具本质上是 GPT-4 的广告,因为它需要 GPT-4 才能工作。其他 LLM 可解释性工具较少依赖商业 API,例如 DeepMind 的Tracr ,这是一种将程序翻译成神经网络模型的编译器。

Wu 说事实并非如此——该工具使用 GPT-4 的事实只是“偶然的”——相反,显示了 GPT-4 在这方面的弱点。他还表示,它并不是在考虑商业应用的情况下创建的,理论上,除了 GPT-4 之外,它还可以适用于 LLM。

该工具可识别 LLM 中跨层激活的神经元。

“大多数解释得分很低,或者不能解释实际神经元的大部分行为,”Wu 说。 “ 例如,许多神经元以一种很难分辨发生了什么的方式活跃——就像它们在五六种不同的事物上激活,但没有明显的模式。有时有一个可辨别的模式,但 GPT-4 无法找到它。”

更不用说更复杂、更新和更大的模型,或者可以浏览网络获取信息的模型。但关于第二点,Wu 认为网页浏览不会对工具的底层机制产生太大影响。他说,可以简单地对其进行调整,以弄清楚为什么神经元决定进行某些搜索引擎查询或访问特定网站。

“我们希望这将开辟一条有前途的途径,以其他人可以在此基础上构建并做出贡献的自动化方式解决可解释性问题,”Wu 说。 “希望我们真的不仅可以很好地解释神经元的反应,还可以解释这些模型的整体行为——它们正在计算什么样的电路,以及某些神经元如何影响其他神经元。”

OpenAI 的新工具试图解释最初发表在TechCrunch上的Kyle Wiggers的语言模型行为

原文: https://techcrunch.com/2023/05/09/openais-new-tool-attempts-to-explain-language-models-behaviors/