Ollama 一直是我最喜欢的运行本地模型的方式之一 – 它使得下载模型变得非常容易,并且可以智能地在使用模型时将它们驻留在内存中,然后在它们停止接收流量后将其清除。

到目前为止,唯一缺少的功能就是界面:Ollama 一直是纯命令行的,这对于我们当中熟悉 CLI 的人来说很好,但对其他人来说用处不大。

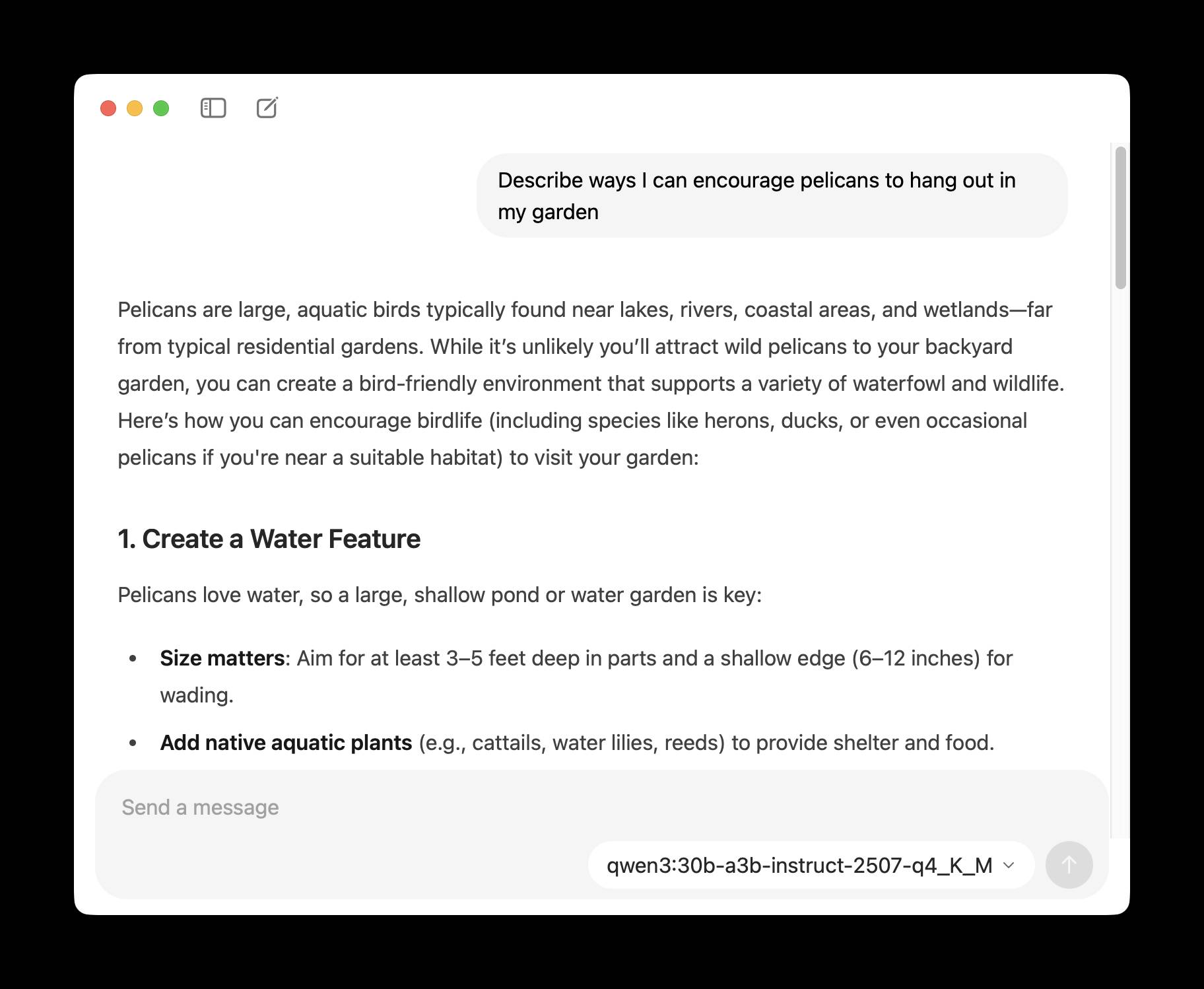

他们终于解决了这个问题!新版应用的界面可以通过现有的系统托盘菜单访问,并允许您与任何已安装的模型进行聊天。Vision 模型也可以通过新界面接收图像。

来源: Hacker News

标签: ai 、 generative-ai 、 local-llms 、 llms 、 ollama

原文: https://simonwillison.net/2025/Jul/31/ollamas-new-app/#atom-everything