Magistral——Mistral AI 的第一个推理模型

Mistral 的首个推理模型今日发布,有两种尺寸。一个是采用 24B Apache 2 许可的开放权重模型,名为 Magistral Small(实际为 Magistral-Small-2506),另一个是更大的纯 API 模型,名为 Magistral Medium。

Magistral Small 在 Hugging Face 上以mistralai/Magistral-Small-2506 的型号出售。型号卡片如下:

上下文窗口:上下文窗口大小为 128k,但超过 40k 后性能可能会下降。因此,我们建议将最大模型长度设置为 40k。

Mistral 还发布了官方 GGUF 版本Magistral-Small-2506_gguf ,我使用 Ollama 成功运行了该版本,如下所示:

ollama pull hf.co/mistralai/Magistral-Small-2506_gguf:Q8_0

这获取了一个 25GB 的文件。我使用llm-ollama的聊天会话运行了如下提示:

llm chat -m hf.co/mistralai/Magistral-Small-2506_gguf:Q8_0

以下是我针对“生成一只骑自行车的鹈鹕的 SVG”所得到的答案(此处为文字记录):

GGUF 尚不支持函数调用,这令人失望 – 希望社区变体可以添加此功能,这是我所知道的释放这些推理模型潜力的最佳方法之一。

我刚刚注意到 Ollama 也有自己的Magistral 模型,可以使用以下方式访问:

ollama pull magistral:latest

这样你就可以获得 14GB q4_K_M量化 – 其他选项可以在Ollama magistral 标签的完整列表中找到。

Magistral 公告中有一件事引起了我的注意:

法律、金融、医疗保健和政府专业人士将获得符合合规性要求的可追溯推理。每个结论均可通过其逻辑步骤进行追溯,从而为领域专用 AI 的高风险环境提供可审计性。

我猜这意味着推理痕迹是完全可见的,并且没有以任何方式被编辑——有趣的是,Mistral 试图将其转变为对他们最感兴趣的商业客户有吸引力的功能。

该公告中还提到:

我们早期的测试表明,Magistral 是一款出色的创意伴侣。我们强烈推荐用它来进行创意写作和故事讲述,它能够创作出条理清晰的文案,如果需要,还能创作出令人愉悦的、别出心裁的文案。

我以前从未见过以这种方式推广创意写作的推理模型。

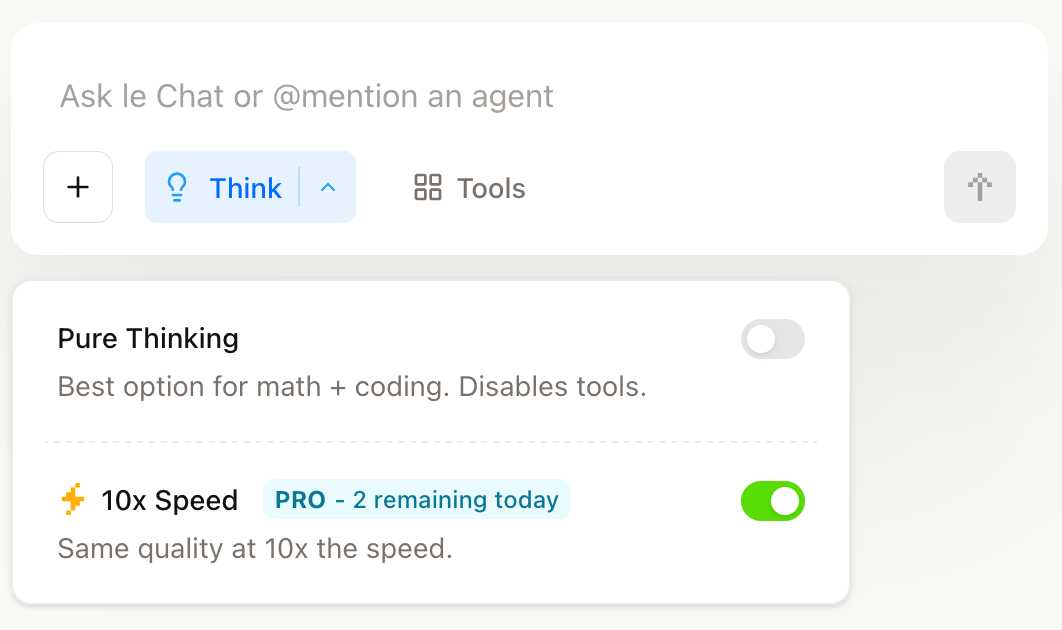

您可以通过选择 Mistral 的Le Chat中的新“思考”选项来尝试 Magistral Medium。

他们有“纯粹思考”选项和“10 倍速度”单独选项,可使用Cerebras以 10 倍速度运行 Magistral Medium。

新模型也可以通过Mistral API获取。您可以通过安装llm-mistral并运行llm mistral refresh来刷新可用模型列表,然后:

llm -m mistral/magistral-medium-latest \ 'Generate an SVG of a pelican riding a bicycle'

这是那份记录。输入 13 个 token,输出 1,236 个 token,花费了我0.62 美分——略高于半美分。

标签: LLM 发布、 Mistral 、 LLM 、 Generative-AI 、 LLM 推理、 AI 、 LLMS 、 Ollama 、 Pelican-Riding-A-BICYCLE 、 Cerebras 、 LLM 定价

原文: https://simonwillison.net/2025/Jun/10/magistral/#atom-everything