最难打破的方法模型之一是人工智能生成内容的可抛弃性。

当要求我生成一篇博客文章时,为什么不直接要求它生成三篇,挑选最好的一篇,以此为提示生成另外三篇,并重复操作,直到获得完美的内容?

这是 EvoBlog 背后的核心思想,EvoBlog 是一个进化的 AI 内容生成系统,它利用多个大型语言模型 (LLM) 在使用传统方法所需时间的一小部分内生成高质量的博客文章。

下面的帖子是使用 EvoBlog 生成的,其中系统进行了自我解释。

– 想象一下,写一篇精雕细琢、富有洞察力的博客文章比泡一杯咖啡还要快。这不是科幻小说。我们今天就通过 EvoBlog 构建这样的未来。

我们的方法利用一个进化的多模型系统来生成博客文章,该系统受到EvoGit等框架的启发,这些框架展示了 AI 代理如何通过版本控制自主协作来演进代码。EvoBlog 将类似的原则应用于内容创作,将博客文章的开发视为一个进化过程,多个 AI 代理相互竞争,力求创作出最佳内容。

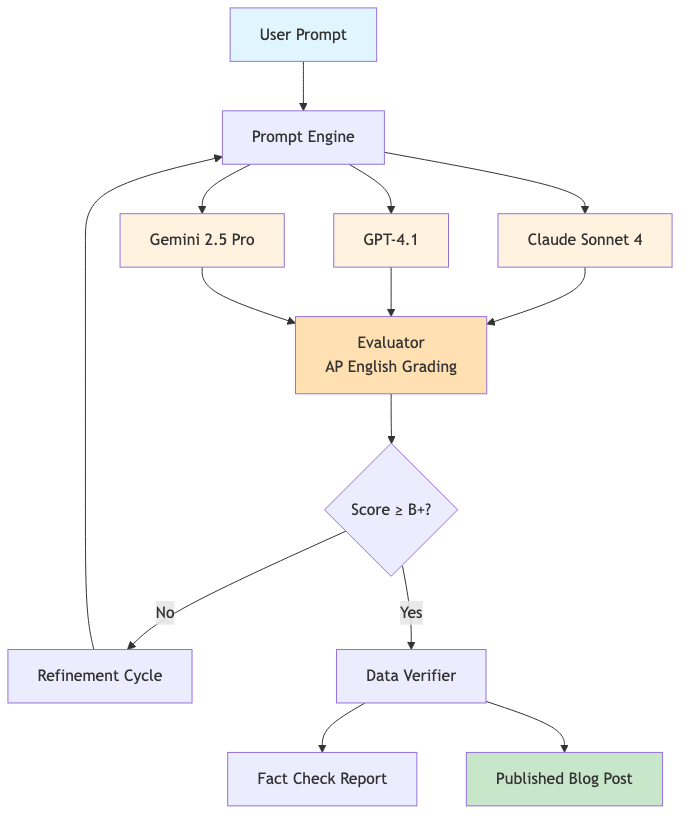

该流程首先并行运行多个大型语言模型 (LLM)。我们目前使用 Claude Sonnet 4、GPT-4.1 和 Gemini 2.5 Pro——最新一代前沿模型。每个模型接收相同的核心提示,但会生成博客文章的不同版本。这种并行方法具有几个关键优势。

首先,它大幅缩短了生成时间。我们无需等待单个模型迭代,而是同时接收多个草稿。我们在测试中观察到,生成时间不到 3 分钟,而传统的顺序方法则需要 15-20 分钟。

其次,并行生成促进了多样性。每个法学硕士(LLM)都有各自的优势和偏好。Claude Sonnet 4 擅长结构化推理和技术分析。GPT-4.1 带来了卓越的编码能力和指令遵循能力。Gemini 2.5 Pro 则提供了高级思维和长语境理解能力。这种内在的多样性使得初稿中呈现出更广泛的视角和写作风格。

接下来是评估阶段。我们采用独特的方法,使用与AP英语教师类似的指导原则。这确保了写作质量达到高标准,注重清晰度、语法和论证能力。我们的评估系统根据四个维度对文章进行评分:语法正确性(25%)、论证强度(35%)、风格匹配度(25%)以及是否使用陈词滥调(15%)。

系统会自动将评分 B+ 或更高(87% 以上)的帖子标记为“准备发布”,模拟真实的编辑标准。此评估流程借鉴了人类编辑评估内容质量的方式,但在所有生成的版本中以机器速度运行。

得分最高的稿件随后将进入改进周期。入选的法学硕士 (LLM) 将进一步完善其成果,吸收反馈意见并解决评估过程中发现的任何不足之处。这个迭代过程令人联想到初创公司的运作方式——快速原型设计、反馈循环和持续改进,都是博客文章创作和公司建设成功的关键。

我们的数据验证层是一项关键创新。与经常制造统计数据的 AI 内容生成器不同,EvoBlog 包含明确的指令,禁止伪造数据点。当模型需要支持数据时,它们会显示“[需要数据:描述]”标记,以触发事实核查工作流程。这解决了 AI 生成内容中最大的可靠性问题之一。

这种多模型方法带来了一些有趣的成本权衡。虽然利用多个 LLM 会增加前期成本(通常每完成一代增加 0.10-0.15 美元),但节省的时间和质量的提升会带来显著的长期效率提升。试想一下,如果创始人花费数小时撰写一篇博客文章,而不是专注于产品开发或融资,这会带来多大的机会成本。

该架构借鉴了进化计算原理,其中多个“突变”(模型变体)在适应度景观(评估分数)中竞争,成功的适应(高分帖子)将存活到下一代(优化周期)。这反映了自然选择,但其运作方式是在内容空间而非生物系统中。

我们的进化多模型方法进一步扩展了这一概念,优化了速度和质量,同时通过系统验证保持了可靠性。

展望未来,这个不断发展的框架可以扩展到博客文章以外的其他内容类型——营销文案、技术文档、研究综合,甚至 EvoGit 自主编程代理所演示的代码生成。并行生成、系统评估和迭代改进的核心原则广泛应用于任何创造性或分析性任务。

原文: https://www.tomtunguz.com/evoblog-evolutionary-ai-content-generation/