谷歌的全新开放权重(在略显粗糙的Gemma 许可下)308M 参数嵌入模型:

EmbeddingGemma 基于 Gemma 3 架构,经过 100 多种语言的训练,并且足够小,可以在不到 200MB 的 RAM 上运行并进行量化。

它可通过sentence-transformers 、 llama.cpp 、 MLX 、 Ollama 、 LMStudio等获得。

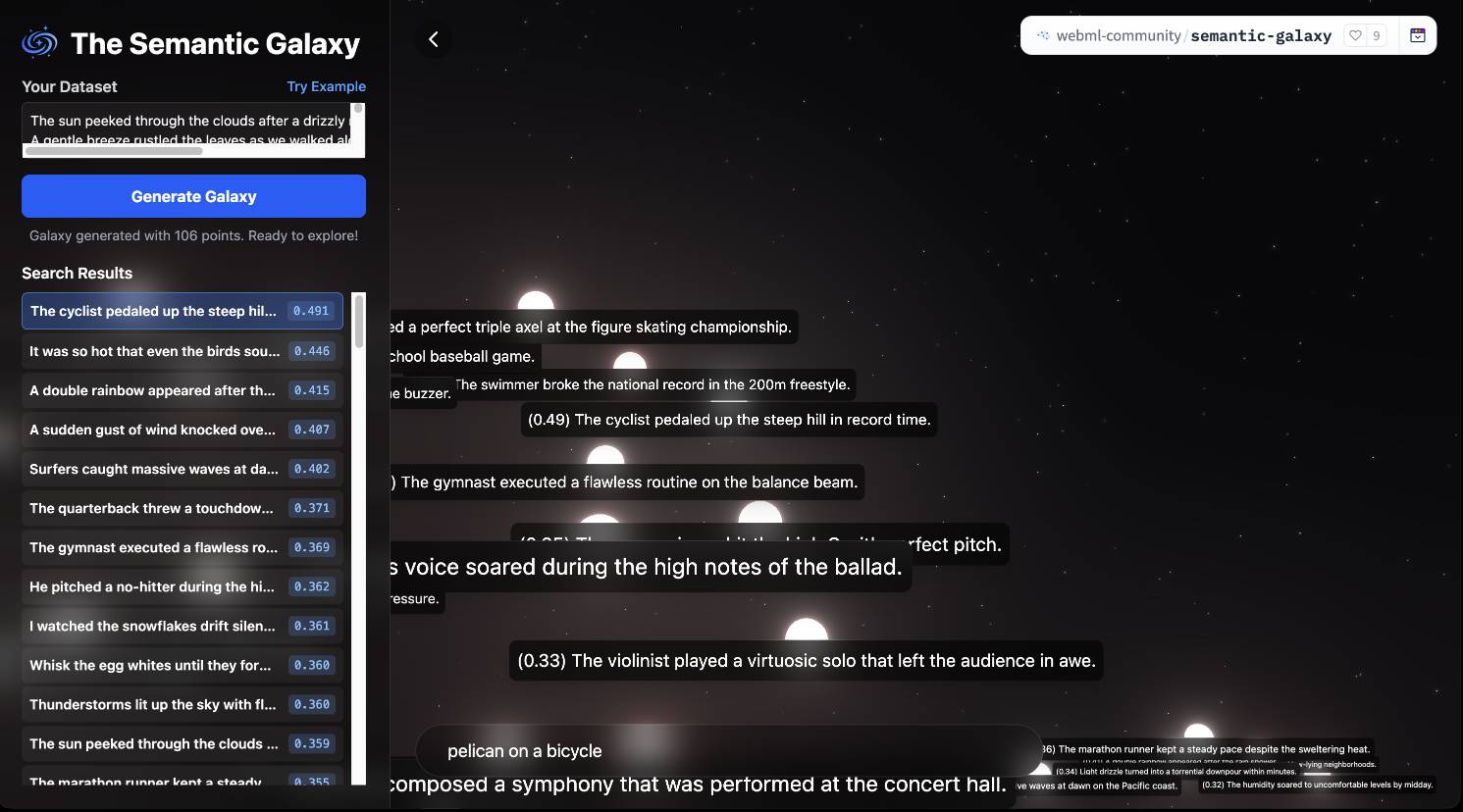

与这些较小的模型一样,有一个Transformers.js演示(通过)可直接在浏览器中运行(在 Chrome 变体中) – Semantic Galaxy加载一个~400MB 的模型,然后让您针对数百个文本句子运行嵌入,将它们映射到 2D 空间中并运行相似性搜索以放大到该空间内的点。

标签:谷歌、人工智能、嵌入、 Transformers-JS 、 Gemma

原文: https://simonwillison.net/2025/Sep/4/embedding-gemma/#atom-everything