是人写的,还是ChatGPT ?这可能很难说——也许太难了,它的创建者 OpenAI 认为,这就是为什么它正在研究一种方法来为人工智能生成的内容添加“水印”。

在奥斯汀大学的一次演讲中,计算机科学教授 Scott Aaronson(目前是 OpenAI 的客座研究员)透露,OpenAI 正在开发一种工具,用于“对文本 [AI 系统] 的输出进行统计水印”。每当系统(比如 ChatGPT)生成文本时,该工具就会嵌入一个“不易察觉的秘密信号”,指示文本的来源。

Aaronson 说,OpenAI 工程师 Hendrik Kirchner 构建了一个工作原型,并希望将其构建到未来 OpenAI 开发的系统中。

Aaronson 在他的评论中说:“我们希望它更难获取 [AI 系统的] 输出并将其传递出去,就好像它来自人类一样。” “显然,这可能有助于防止学术剽窃,而且,例如,大规模宣传——你知道,在每个博客上发送垃圾邮件,看似切题的评论支持俄罗斯入侵乌克兰,甚至在莫斯科没有一栋充满巨魔的建筑物。或冒充某人的写作风格以指控他们。”

利用随机性

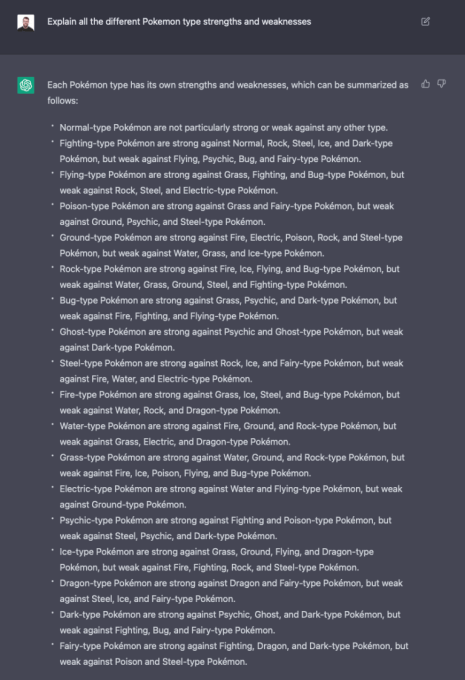

为什么需要水印? ChatGPT 就是一个很好的例子。 由OpenAI 开发的聊天机器人风靡互联网,不仅能够回答具有挑战性的问题,还能写诗、 解决编程难题,并在任何哲学话题上都充满诗意。

虽然 ChatGPT 非常有趣——而且真的很有用——但该系统引起了明显的道德问题。与之前的许多文本生成系统一样,ChatGPT 可用于编写高质量的网络钓鱼电子邮件和有害恶意软件,或在学校作业中作弊。作为一种问答工具,它实际上是不一致的——这一缺点导致编程问答网站 Stack Overflow 禁止来自 ChatGPT 的答案,直至另行通知。

要掌握 OpenAI 水印工具的技术基础,了解像 ChatGPT 这样的系统为什么能像它们那样工作会很有帮助。这些系统将输入和输出文本理解为“标记”字符串,这些标记可以是单词,也可以是标点符号和单词的一部分。在其核心,系统不断生成称为概率分布的数学函数来决定要输出的下一个标记(例如,单词),同时考虑所有先前输出的标记。

对于像 ChatGPT 这样的 OpenAI 托管系统,在生成分布后,OpenAI 的服务器会根据分布对令牌进行采样。这个选择有一些随机性;这就是为什么相同的文本提示会产生不同的响应。

Aaronson 在讲座中说,OpenAI 的水印工具就像现有文本生成系统的“包装器”,利用在服务器级别运行的加密功能“伪随机”选择下一个标记。从理论上讲,系统生成的文本在你我看来仍然是随机的,但任何拥有加密功能“密钥”的人都能够揭开水印。

“根据经验,几百个标记似乎足以得到一个合理的信号,即是的,该文本来自 [AI 系统]。原则上,你甚至可以拿一个长文本来区分哪些部分可能来自[系统],哪些部分可能不是。”阿伦森说。 “[该工具] 可以使用密钥添加水印,并且可以使用相同的密钥检查水印。”

主要限制

为 AI 生成的文本加水印并不是一个新想法。以前的尝试,大多数是基于规则的,都依赖于同义词替换和特定于句法的单词更改等技术。但除了德国研究所 CISPA 去年 3 月发表的理论研究外,OpenAI 似乎是解决该问题的首批基于密码学的方法之一。

当我们联系他征求意见时,Aaronson 拒绝透露更多关于水印原型的信息,只是说他希望在未来几个月与人合着一篇研究论文。 OpenAI 也拒绝了,只是说水印是它正在探索的几种“起源技术”之一,用于检测人工智能生成的输出。

然而,独立的学者和行业专家的意见不一。他们注意到该工具是服务器端的,这意味着它不一定适用于所有文本生成系统。他们争辩说,对手绕过它是微不足道的。

麻省理工学院计算机科学教授斯里尼·德瓦达斯 (Srini Devadas) 通过电子邮件告诉 TechCrunch:“我认为通过重新措辞、使用同义词等方式绕过它相当容易。” “这是一场拉锯战。”

艾伦人工智能研究所的研究科学家杰克赫塞尔指出,很难在不知不觉中对人工智能生成的文本进行指纹识别,因为每个标记都是一个离散的选择。太明显的指纹可能会导致选择奇怪的词,从而降低流畅性,而太微妙会在寻找指纹时留下怀疑的余地。

ChatGPT 回答问题。

OpenAI 的竞争对手AI21 Labs的联合创始人兼联合首席执行官 Yoav Shoham 认为统计水印不足以帮助识别 AI 生成文本的来源。他呼吁采用一种“更全面”的方法,包括差异水印,其中文本的不同部分被不同地加水印,以及更准确地引用事实文本来源的人工智能系统。

专家指出,这种特定的水印技术还需要对 OpenAI 给予高度信任和权力。

“理想的指纹识别不会被人类读者辨别出来,并且能够实现高度自信的检测,”Hessel 在电子邮件中说。 “根据它的设置方式,由于‘签名’过程的工作方式,OpenAI 本身可能是唯一能够自信地提供这种检测的一方。”

在他的演讲中,Aaronson 承认该计划只有在像 OpenAI 这样的公司在扩展最先进系统方面处于领先地位的世界中才会真正起作用——而且他们都同意成为负责任的参与者。即使 OpenAI 与其他文本生成系统提供商(如 Cohere 和 AI21Labs)共享水印工具,也不会阻止其他人选择不使用它。

“如果 [it] 变成了一场混战,那么很多安全措施确实会变得更加困难,甚至可能是不可能的,至少在没有政府监管的情况下,”Aaronson 说。 “在一个任何人都可以构建自己的文本模型的世界中,它与 [ChatGPT,例如] 一样好……你会在那里做什么?”

这就是它在文本到图像领域中的表现。与 OpenAI 不同,其DALL-E 2图像生成系统只能通过 API 使用, Stability AI开源了其文本到图像技术(称为Stable Diffusion )。虽然 DALL-E 2 在 API 级别有许多过滤器来防止生成有问题的图像(加上它生成的图像上的水印),但开源的 Stable Diffusion 却没有。坏人用它来制作深度伪造的色情内容,以及其他有害内容。

就他而言,亚伦森很乐观。在演讲中,他表示相信,如果 OpenAI 能够证明水印有效并且不会影响生成文本的质量,它就有可能成为行业标准。

不是每个人都同意。正如 Devadas 指出的那样,该工具需要一个密钥,这意味着它不能完全开源——可能会将其采用限制在同意与 OpenAI 合作的组织中。 (如果密钥被公开,任何人都可以推断出水印背后的模式,从而破坏他们的目的。)

但这可能不是那么牵强。 Quora 的一位代表表示,该公司有兴趣使用这样的系统,而且它可能不是唯一的。

“你可能会担心,在扩展人工智能时,所有这些关于试图安全和负责任的事情……一旦它严重损害了谷歌、Meta 和阿里巴巴以及其他主要参与者的底线,很多事情就会被抛到九霄云外, ”阿伦森说。 “另一方面,我们在过去 30 年中看到,大型互联网公司可以就某些最低标准达成一致,无论是因为害怕被起诉、希望被视为负责任的参与者,还是出于其他原因。”

OpenAI 尝试为 AI 文本添加水印命中限制最初发表于TechCrunch的Kyle Wiggers

原文: https://techcrunch.com/2022/12/10/openais-attempts-to-watermark-ai-text-hit-limits/