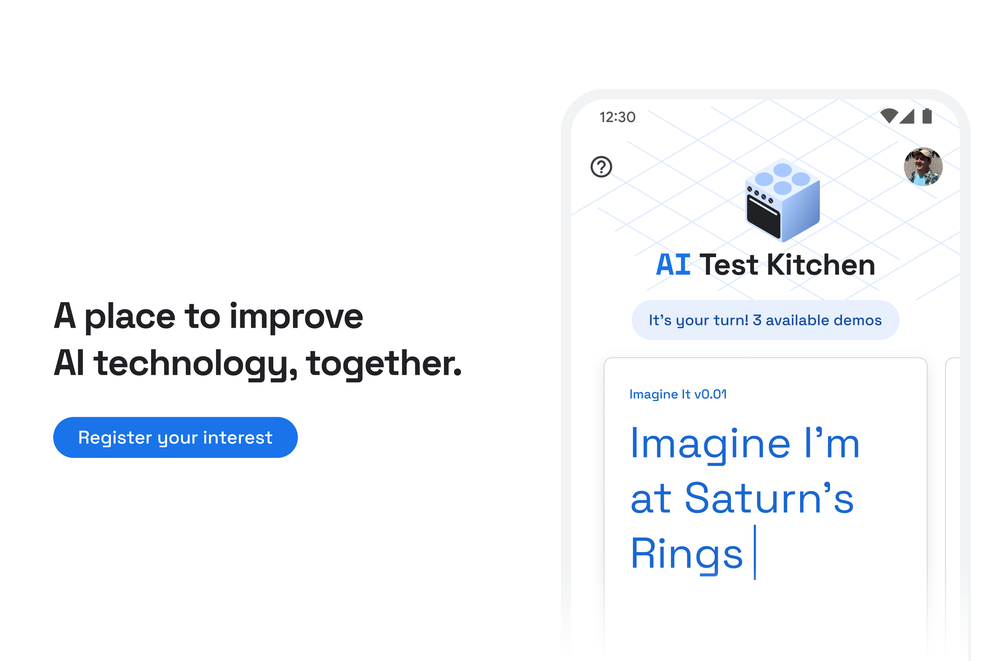

谷歌今天推出了AI Test Kitchen,这是一款应用程序,可让用户在进入生产之前从公司实验室试用实验性的 AI 驱动系统。从今天开始,随着 AI Test Kitchen 开始逐步向美国的小团体推出,感兴趣的人可以填写一份注册表单

正如今年早些时候在谷歌 I/O 开发者大会上宣布的那样,AI Test Kitchen 将提供以新颖、尖端的 AI 技术为中心的轮播演示——所有这些都来自谷歌内部。该公司强调,它们不是成品,而是旨在让谷歌体验这家科技巨头的创新,同时为谷歌提供研究如何使用它们的机会。

AI Test Kitchen 中的第一组演示探索了最新版本的 LaMDA(对话应用程序语言模型)的功能,这是一种谷歌的语言模型,可以查询网络以类似人类的方式回答问题。例如,您可以命名一个地点并让 LaMDA 提供探索路径,或共享一个目标以让 LaMDA 将其分解为子任务列表。

谷歌表示,它为 AI Test Kitchen 添加了“多层”保护,以尽量减少围绕 LaMDA 等系统的风险,如偏见和有毒输出。正如 Meta 的 BlenderBot 3.0 最近所展示的那样,即使是当今最复杂的聊天机器人也可以迅速脱轨,在某些文本提示时钻研阴谋论和令人反感的内容。

图片来源:谷歌

谷歌表示,人工智能测试厨房内的系统将尝试自动检测并过滤掉可能是色情、仇恨或冒犯、暴力或非法或泄露个人信息的令人反感的单词或短语。但该公司警告说,冒犯性的文字可能仍会偶尔通过。

“随着人工智能技术的不断进步,它们有可能解锁支持更自然的人机交互的新体验,”谷歌产品经理 Tris Warkentin 和产品管理总监 Josh Woodward 在一篇博文中写道。 “我们正处于外部反馈是改进 LaMDA 的下一个最有帮助的步骤的地步。当您将每个 LaMDA 回复评价为不错、令人反感、离题或不真实时,我们将使用这些数据(与您的 Google 帐户无关)来改进和开发我们未来的产品。”

AI Test Kitchen 是科技巨头近期更广泛的趋势的一部分,这些趋势是在 AI 技术被释放到野外之前对其进行试点。毫无疑问,微软的有毒Tay聊天机器人、谷歌、Meta、OpenAI 和其他公司越来越多地选择在小组中测试人工智能系统,以确保它们的行为符合预期,并在必要时微调它们的行为。

例如,OpenAI 几年前在封闭测试版中发布了其语言生成系统GPT-3 ,然后才广泛使用。 GitHub 最初限制了对Copilot的访问,这是它与 OpenAI 合作开发的代码生成系统,以便在将其普遍推出之前选择开发人员。

这种方法不一定是出于任何人的善意——到目前为止,顶级科技公司已经清楚地意识到人工智能出错可能会吸引到负面新闻。通过将新的人工智能系统暴露给外部团体并附上广泛的免责声明,该策略似乎是在宣传系统的功能,同时减轻更有问题的组件。这是否足以避免争议还有待观察——甚至在 AI Test Kitchen 推出之前, LaMDA 就因所有错误的原因登上了头条——但硅谷有影响力的一部分似乎有信心这样做。

原文: https://techcrunch.com/2022/08/25/googles-new-app-lets-you-experimental-ai-systems-like-lamda/