一种新的开源 AI 图像生成器能够从任何文本提示中生成逼真的图片,在其第一周就以惊人的速度被采用。 Stability AI 的Stable Diffusion保真度高,但能够在现成的消费类硬件上运行,现在被 Artbreeder、Pixelz.ai 等艺术生成器服务使用。但该模型未经过滤的性质意味着并非所有使用都完全光明正大。

在大多数情况下,用例是光明正大的。例如,NoveAI 一直在尝试使用 Stable Diffusion 来制作可以伴随用户在其平台上创建的 AI 生成故事的艺术。 Midjourney推出了一个测试版,该测试版利用稳定扩散以获得更大的真实感。

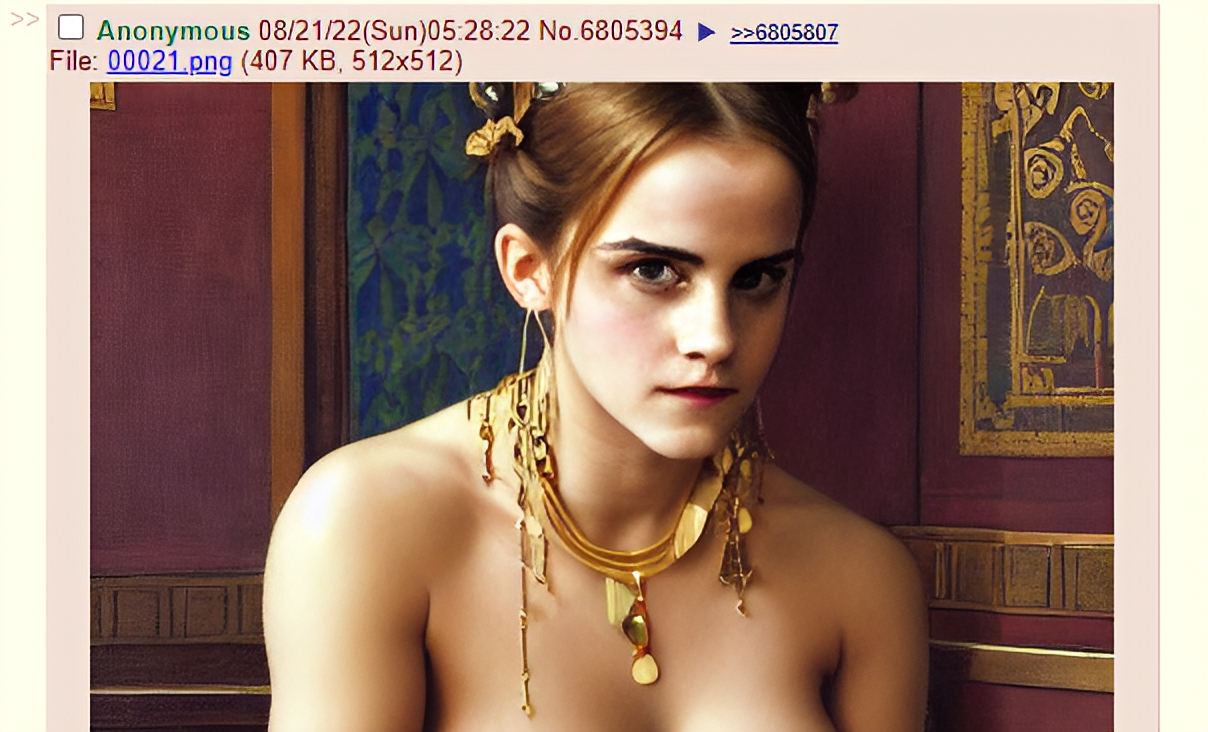

但稳定的扩散也被用于不太美味的目的。在臭名昭著的讨论板 4chan 上,该模型很早就泄露了,有几个线程专门讨论 AI 生成的裸体名人艺术和其他形式的生成色情内容。

Stability AI 的首席执行官 Emad Mostaque 称该模型在 4chan 上泄露是“不幸的”,并强调该公司正在与“领先的伦理学家和技术”合作,围绕负责任的发布开展安全和其他机制。其中一种机制是一个可调节的人工智能工具,安全分类器,包含在整个稳定扩散软件包中,它试图检测和阻止令人反感或不受欢迎的图像。

但是,可以禁用安全分类器(默认情况下启用)。

稳定扩散是一个非常新的领域。其他人工智能艺术生成系统,如 OpenAI 的 DALL-E 2,对色情材料实施了严格的过滤。 (开源稳定扩散的许可禁止某些应用,例如利用未成年人,但模型本身不受技术层面的束缚。)此外,与稳定扩散不同,许多人没有创造公众人物艺术的能力.这两种能力结合起来可能会有风险,允许不良行为者制造色情“深度伪造”——在最坏的情况下——可能会延续虐待或将某人卷入他们没有犯下的罪行。

由 Stable Diffusion 创建并在 4chan 上发布的 Emma Watson 的 deepfake。图片来源:稳定扩散

不幸的是,到目前为止,女性最有可能成为这种情况的受害者。 2019 年进行的一项研究显示,在 90% 至 95% 的非自愿深度伪造中,约 90% 是女性。加州大学伯克利分校的人工智能伦理学家 Ravit Dotan 表示,这对这些人工智能系统的未来来说是一个坏兆头。

“我担心非法内容合成图像的其他影响——它会加剧所描绘的非法行为,”Dotan 通过电子邮件告诉 TechCrunch。 “例如,合成儿童[剥削]会增加真实儿童[剥削]的创造吗?会不会增加恋童癖的袭击次数?”

蒙特利尔人工智能伦理研究所首席研究员 Abhishek Gupta 同意这一观点。 “我们确实需要考虑人工智能系统的生命周期,包括部署后的使用和监控,并考虑我们如何设想控制措施,即使在最坏的情况下也能最大限度地减少危害,”他说。 “当一种强大的能力 [如稳定扩散] 进入野外时尤其如此,这可能会对可能使用这种系统的人造成真正的创伤,例如,通过在受害者的肖像中创建令人反感的内容。”

在过去的一年里,一位父亲在护士的建议下,为他年幼的孩子肿胀的生殖器区域拍下了照片,并将它们发短信到护士的 iPhone 上。这张照片自动备份到谷歌照片,并被公司的人工智能过滤器标记为儿童性虐待材料,导致该男子的账户被禁用,旧金山警察局进行了调查。

像 Dotan 这样的专家说,如果一张合法的照片可以触发这样的检测系统,那么像 Stable Diffusion 这样的系统生成的深度伪造没有理由不能——而且是大规模的。

“人们创建的人工智能系统,即使他们有最好的意图,也可能以他们无法预料也无法阻止的有害方式使用,”Dotan 说。 “我认为开发人员和研究人员经常低估了这一点。”

当然,制造深度伪造的技术已经存在了一段时间,无论是人工智能还是其他方式。 Deepfake 检测公司Sensity的 2020 年报告发现,每个月都有数百个以女性名人为特色的露骨 Deepfake 视频被上传到世界上最大的色情网站;该报告估计在线深度伪造的总数约为 49,000,其中超过 95% 是色情内容。自从几年前人工智能换脸工具进入主流以来,包括艾玛·沃特森、娜塔莉·波特曼、比莉·艾莉丝和泰勒·斯威夫特在内的女演员一直是深度伪造的目标,包括克里斯汀·贝尔在内的一些女演员已经公开反对他们认为的性行为剥削。

但 Stable Diffusion 代表了新一代系统,它可以通过用户最少的工作创建令人难以置信的(如果不是完美的话)令人信服的假图像。它也很容易安装,只需要几个安装文件和一个花费数百美元的高端显卡。可以在 M1 MacBook 上运行的更高效系统版本的工作正在进行中。

一个凯莉·卡戴珊 (Kylie Kardashian) 的 deepfake 发布到 4chan。图片来源:稳定扩散

塞巴斯蒂安伯恩斯,博士伦敦玛丽女王大学 AI 小组的研究员认为,自动化和扩大定制图像生成的可能性是与稳定扩散等系统的最大区别,也是主要问题。 “大多数有害图像已经可以用传统方法制作,但是是手动的,需要很多努力,”他说。 “一个可以产生近乎真实感镜头的模型可能会让位于对个人的个性化勒索攻击。”

Berns 担心,从社交媒体上抓取的个人照片可能会被用来调节 Stable Diffusion 或任何此类模型,以生成有针对性的色情图像或描绘非法行为的图像。肯定有先例。在报道 2018 年一名 8 岁克什米尔女孩遭到强奸后,印度调查记者拉娜·阿尤布 (Rana Ayyub ) 成为印度民族主义巨魔的目标,其中一些人用她的脸贴在另一个人的身上制作了 deepfake 色情片。民族主义政党 BJP 的领导人分享了 deepfake,因此 Ayyub 受到的骚扰变得如此严重,以至于联合国不得不进行干预。

“Stable Diffusion 提供了足够的定制化功能,可以对个人发出自动威胁,要么支付费用,要么冒着发布虚假但可能具有破坏性的镜头的风险,”伯恩斯继续说道。 “我们已经看到人们在远程访问他们的网络摄像头后被勒索。那个渗透步骤可能不再需要了。”

随着 Stable Diffusion 在野外出现并且已经被用于生成色情内容(有些是非自愿的),图像主机可能有责任采取行动。 TechCrunch 联系了主要的成人内容平台之一 OnlyFans,但截至发布时没有收到回复。也允许成人内容的 Patreon 的发言人指出,该公司有一项反对深度伪造的政策,并且不允许“重新利用名人的肖像并将非成人内容置于成人环境中”的图像。

然而,如果历史有任何迹象,那么执法可能会不平衡——部分原因是很少有法律专门防止与色情相关的深度伪造。即使法律诉讼的威胁将一些专门提供令人反感的人工智能生成内容的网站拉下,也没有什么可以阻止新网站的出现。

换句话说,古普塔说,这是一个勇敢的新世界。

“创意和恶意用户可以滥用 [稳定扩散] 的能力来大规模生成主观上令人反感的内容,使用最少的资源来运行推理——这比训练整个模型更便宜——然后将它们发布到 4chan 等场所以增加流量和黑客注意力,”古普塔说。 “当这些功能逃逸到‘荒野’时,API 速率限制、对从系统返回的输出类型的安全控制等控制措施不再适用时,就会面临很多风险。”