Run.ai是一家资金雄厚的用于编排 AI 工作负载的服务,在过去 几年中,它通过帮助用户充分利用本地和云端的 GPU 资源来训练他们的模型而声名鹊起。但是,训练模型是一回事,而将它们投入生产是另一回事,这已经不是什么秘密了——这就是许多这些项目仍然失败的地方。毫无疑问,这家将自己视为端到端平台的公司现在正在超越培训,同时支持其客户尽可能高效地运行推理工作负载,无论是在私有云还是公共云中,或在边缘。有了这个,由于两家公司之间的密切合作,该公司的平台现在还提供与Nvidia 的 Triton 推理服务器软件的集成。

“我们在过去 6 到 12 个月确定的一件事是,组织开始从构建和培训机器学习模型转向实际将这些模型投入生产,”Run.ai 联合创始人兼首席执行官 Omri Geller告诉我。 “我们开始在内部投入大量资源,以应对这一挑战。我们相信我们已经破解了培训部分并在那里建立了正确的资源管理,因此我们现在专注于帮助组织管理他们的计算资源以进行推理。”

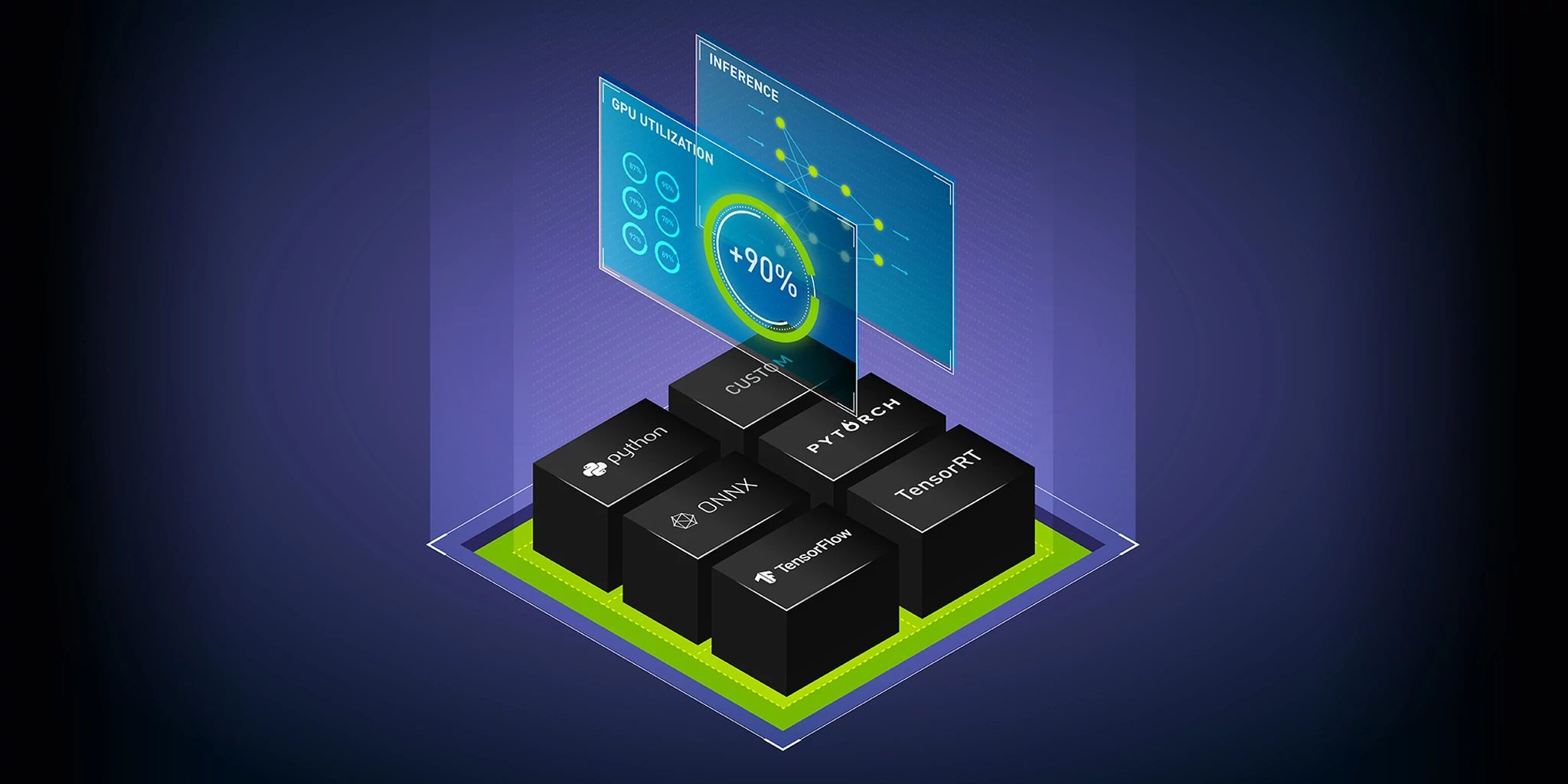

这里的想法是让企业尽可能轻松地部署他们的模型。 Run.ai 承诺不涉及编写 YAML 文件的两步部署过程。由于 Run.ai 早期押注于容器和 Kubernetes,它现在能够将这些推理工作负载转移到最高效的硬件上,并且通过将新的 Nvidia 集成到 Run.ai Atlas 平台,用户甚至可以部署多个模型或实例相同的模型——在 Triton 推理服务器上,带有 Run.ai,它也是Nvidia 的 LaunchPad 程序的一部分,处理每个模型的自动缩放和优先级。

虽然推理不需要训练模型所需的大量计算资源,但 Nvidia 的企业计算副总裁 Manuvir Das 指出,这些模型正变得越来越大,不可能将它们部署在 CPU 上. “我们构建了这个称为 Triton 推理服务器的东西,它不仅可以在 CPU 上进行推理,还可以在 GPU 上进行推理——因为 GPU 的功能已经开始对推理产生影响,”他解释说。 “过去你需要 GPU 来进行训练,一旦你有了模型,你就可以愉快地将它们部署在 CPU 上。但是越来越多,模型变得更大,更复杂。所以你需要在 GPU 上实际运行它们。”

正如盖勒所补充的,随着时间的推移,模型只会变得更加复杂。他指出,毕竟模型的计算复杂度与其准确性之间存在直接关联,因此企业可以使用这些模型解决问题。

尽管 Run.ai 早期的重点是培训,但该公司能够利用其为此构建的大量技术并将其应用于推理。例如,该公司为培训构建的资源共享系统也适用于推理,其中某些模型可能需要更多资源才能实时运行。

现在,您可能会认为 Nvidia 也可以将这些功能内置到其 Triton 推理服务器中,但 Das 指出,这不是该公司进入市场的方式。 “任何从事大规模数据科学的人都需要一个非常好的端到端 ML 操作平台来完成整个工作,”他说。 “这就是 Run.ai 做得好的地方。然后我们在下面所做的,我们提供低级结构来真正很好地单独利用 GPU,然后如果我们正确地集成它,你会得到两全其美的效果。这就是我们合作得很好的原因之一,因为我们俩从一开始就很清楚职责分离。”

值得注意的是,除了与 Nvidia 的合作伙伴关系外,Run.ai 今天还宣布了其平台的多项其他更新。其中包括新的以推理为中心的指标和仪表板,以及在部分 GPU 上部署模型并根据其各自的延迟服务水平协议自动扩展它们的能力。该平台现在还可以将部署扩展到零,从而降低成本。

原文: https://techcrunch.com/2022/07/21/run-ai-partners-with-nvidia-as-it-sets-its-sights-on-inferencing/