Qwen 通过他们的 Twitter 帐户宣布了两款新模型(他们的博客上还没有任何内容): Qwen3-Next-80B-A3B-Instruct和Qwen3-Next-80B-A3B-Thinking 。

他们对性能提出了一些重大要求:

- Qwen3-Next-80B-A3B-Instruct 接近我们的 235B 旗舰产品。

- Qwen3-Next-80B-A3B-Thinking 优于 Gemini-2.5-Flash-Thinking。

“80B-A3B”这个名称表示 800 亿个参数,其中每次只有 30 亿个处于活动状态。您仍然需要拥有足够的 GPU 可访问内存来一次性容纳所有 800 亿个参数,但每轮推理仅使用 30 亿个参数,这显著提高了响应提示的速度。

他们的推文中有更多详细信息:

- 80B 个参数,但每个 token 仅激活 3B → 比 Qwen3-32B 训练便宜 10 倍,推理快 10 倍。(尤其是在 32K+ 上下文中!)

- 混合架构:门控 DeltaNet + 门控注意力 → 速度与召回率最佳

- 超稀疏 MoE:512 位专家,10 位路由专家 + 1 位共享专家

- 多令牌预测→涡轮增压推测解码

- 在性能上胜过 Qwen3-32B,在推理和长上下文方面可与 Qwen3-235B 媲美

Hugging Face 上的每个模型大约有 150GB,因此我决定通过OpenRouter而不是在我自己的笔记本电脑上试用它们( Thinking 、 Instruct )。

我使用了llm-openrouter插件。我的安装方法如下:

llm install llm-openrouter llm keys set openrouter # paste key here然后使用以下命令找到模型 ID:llm install llm-openrouter llm keys set openrouter # paste key here

输出: llm models -q next

OpenRouter: openrouter/qwen/qwen3-next-80b-a3b-thinking OpenRouter: openrouter/qwen/qwen3-next-80b-a3b-instruct我有法学硕士学位OpenRouter: openrouter/qwen/qwen3-next-80b-a3b-thinking OpenRouter: openrouter/qwen/qwen3-next-80b-a3b-instruct

已保存的提示模板名为pelican-svg ,我是这样创建的:

这意味着我可以跑llm "Generate an SVG of a pelican riding a bicycle" --save pelican-svg

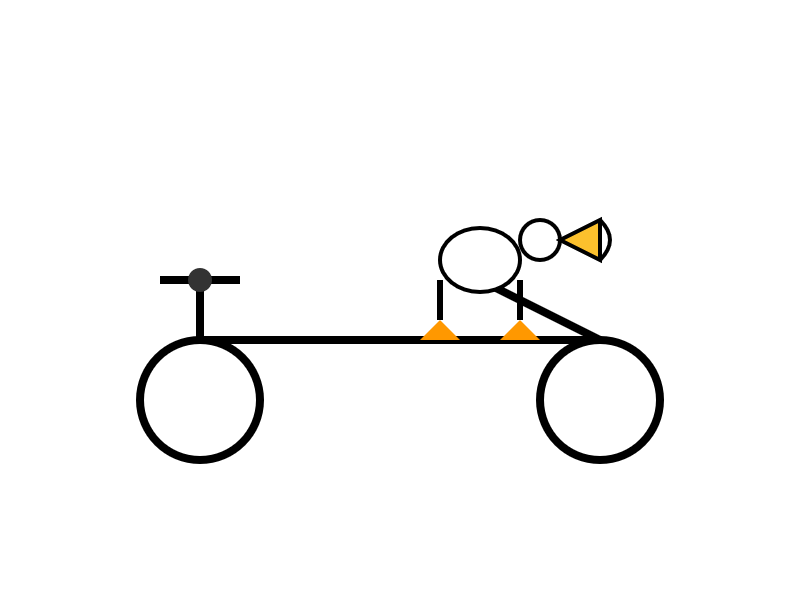

我的鹈鹕基准测试如下:

或者像这样: llm -t pelican-svg -m openrouter/qwen/qwen3-next-80b-a3b-thinking

这是llm -t pelican-svg -m openrouter/qwen/qwen3-next-80b-a3b-instruct

思维模型输出(运行提示后使用llm logs -c | pbcopy导出):

我很喜欢记录中的“异想天开的风格,流畅的曲线和友好的比例(骑自行车不需要解剖学上的准确性!)”的注释。

指导(非推理)模型给了我这个:

“谁需要腿!?” 确实如此!我喜欢它为鹈鹕设计的企鹅-火烈鸟表情符号序列。

标签:人工智能、生成人工智能、法学硕士、法学硕士、 qwen 、鹈鹕骑自行车、法学硕士推理、法学硕士发布、 openrouter 、人工智能在中国

原文: https://simonwillison.net/2025/Sep/12/qwen3-next/#atom-everything