llama.cpp 指南:使用 llama.cpp 运行 gpt-oss

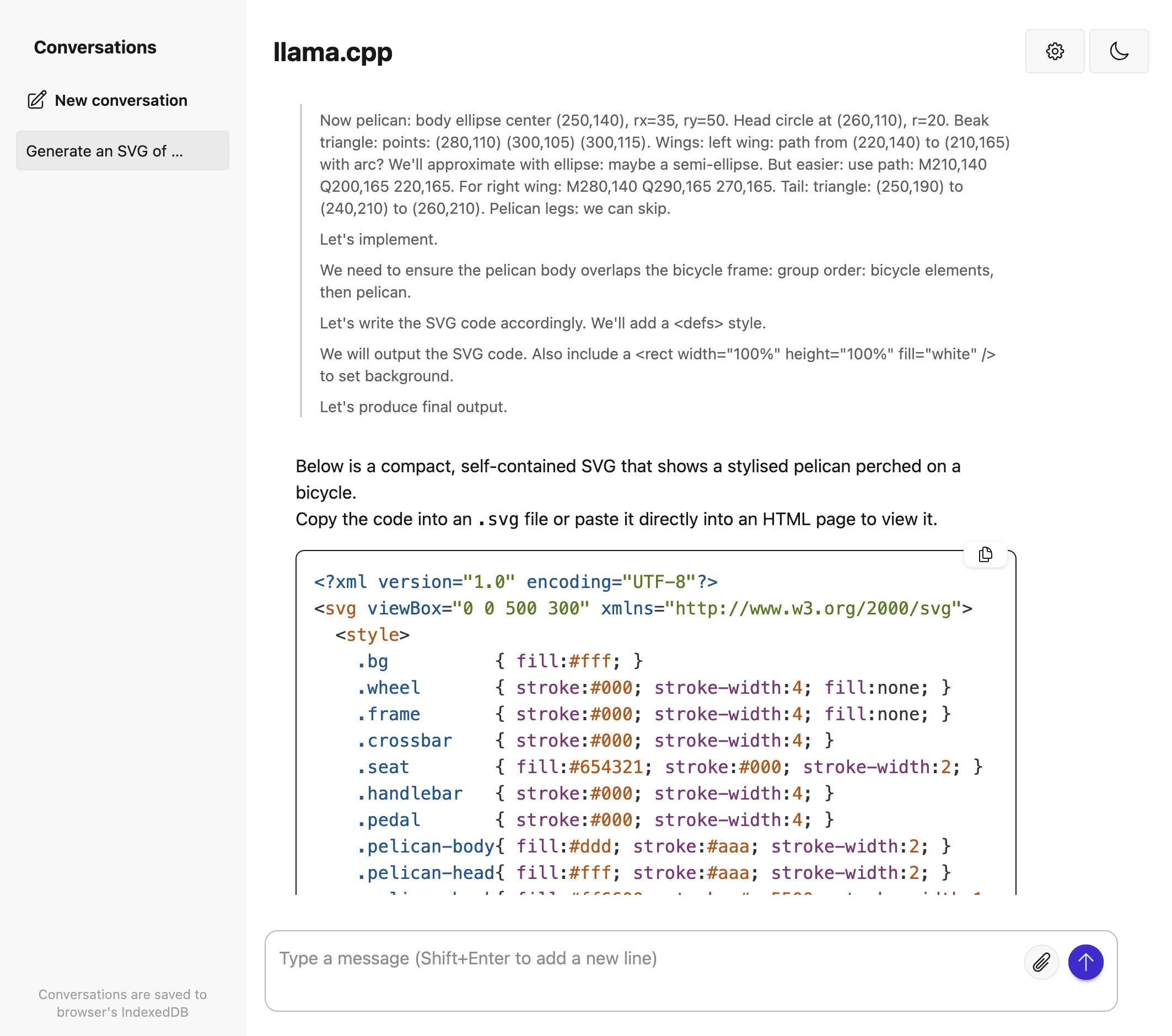

使用llama.cpp中的llama-server运行 OpenAI gpt-oss 模型的真正有用的官方指南 – 它提供了与 OpenAI 兼容的本地主机 API 和用于与模型交互的简洁的 Web 界面。

适用于 macOS 的 TLDR 版本,用于运行较小的gpt-oss-20b模型:

brew install llama.cpp llama-server -hf ggml-org/gpt-oss-20b-GGUF \ --ctx-size 0 --jinja -ub 2048 -b 2048 -ngl 99 -fa这将从brew install llama.cpp llama-server -hf ggml-org/gpt-oss-20b-GGUF \ --ctx-size 0 --jinja -ub 2048 -b 2048 -ngl 99 -fa

Hugging Face 上的ggml-org/gpt-oss-20b-GGUF ,将其存储在~/Library/Caches/llama.cpp/中,并在端口 8080 上启动运行。

然后您可以访问此 URL 开始与模型进行交互:

在我的 64GB M2 MacBook Pro 上http://localhost:8080/

它的运行速度约为每秒 82 个令牌。

该指南还包括在 NVIDIA 和 AMD 硬件上运行的说明。

标签: macos 、 ai 、 openai 、 generative-ai 、 local-llms 、 llms 、 llama-cpp 、 gpt-oss

原文: https://simonwillison.net/2025/Aug/19/gpt-oss-with-llama-cpp/#atom-everything