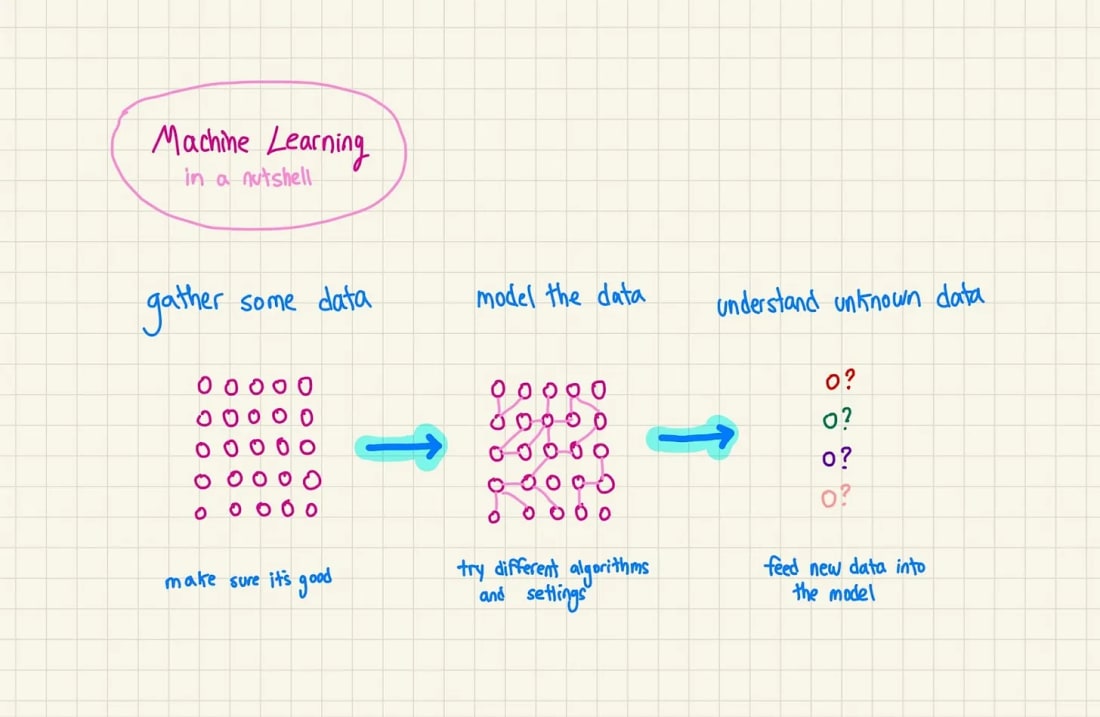

这是一篇仅供付费订阅者阅读的文章预览。如果感兴趣,请注册并阅读更多内容😉 如果你正在读这篇文章,你可能已经对机器学习的常规概念有了相当的了解。但是,如何从一个可以处理一些简单任务(例如预测股票价格或识别玉米地里的虫子)的模型,转变为一个能够从零开始创建单词的模型呢?或者换句话说……生成式人工智能模型究竟在做什么? 首先,我将大致介绍GenAI 的工作原理以及模型如何创建事物。然后,我将分别深入介绍两种最流行的 GenAI 类型——图像生成和文本生成。 生成式人工智能模型在做什么?老式的机器学习全是关于预测的。你会在数据集上训练一个模型,然后用它来预测新数据加入时会发生什么,比如股市新的一天,或者田里玉米的新图像。 生成式人工智能也与预测有关。但它并非预测某个范围非常具体的事物(例如数字或“是/否”答案),而是预测整个句子、段落、图像、视频甚至音频。它经过训练,可以根据你的提示生成大量新数据。 因此,尽管技术和风格在过去 5 年中发生了很大变化,但 GenAI 和传统 ML 之间的差距并不大;它们都在学习数据中的模式,然后使用这些模式来做一些事情。 GenAI 模型的类型GenAI 模型有很多不同的类型,其中一些已经存在一段时间了。例如,生成对抗网络 (GAN),其中一个模型创建一些东西,另一个姊妹模型对其进行评判。还有变分自编码器 (VAE),它使用概率分布。此外,还有循环神经网络 (RNN),这是一种特殊的神经网络,可以预测单词序列。此外,还有更多缩写更长的模型。 但过去几年的大部分进展都来自两种特定类型的 GenAI 模型:

就像任何软件系统一样,每个系统都有其擅长的和不擅长的方面。让我们来了解一下每种模型的类型、它们的起源以及工作原理。实际上,当今许多最先进的模型都结合使用了这两种方法……

© 2025贾斯汀 |

什么是生成式人工智能?

在我们深入探讨之前,先来复习一下 ChatGPT 和 Stable Diffusion 等模型的底层工作原理。

͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏ ͏