当今最复杂的人工智能系统能够完成令人印象深刻的壮举,从引导汽车穿过城市街道到编写类似人类的散文。但它们有一个共同的瓶颈:硬件。在最前沿开发系统通常需要大量的计算能力。例如,创建 DeepMind 的蛋白质结构预测AlphaFold需要数百个 GPU 的集群。进一步强调了这一挑战,一位消息人士估计,使用单个 GPU 开发 AI 初创公司 OpenAI 的语言生成 GPT-3 系统将需要 355 年。

旨在加速人工智能系统开发某些方面的新技术和芯片有望(并且实际上已经)降低硬件要求。但是,使用这些技术进行开发需要专业知识,而小型公司可能很难获得这些专业知识。至少,这是基础设施初创公司Exafunction的联合创始人 Varun Mohan 和 Douglas Chen 的断言。 Exafunction 从今天的隐身中脱颖而出,正在开发一个平台,以抽象出使用硬件训练 AI 系统的复杂性。

“[AI] 的改进通常以……计算复杂性的大幅增加为基础。因此,公司被迫在硬件上进行大量投资以实现深度学习的好处。这非常困难,因为技术进步如此之快,而且随着深度学习在公司内部证明价值,工作量规模迅速增加,”陈在电子邮件采访中告诉 TechCrunch。 “大规模运行深度学习计算所需的专用加速器芯片稀缺。有效地使用这些芯片还需要深度学习从业者不常见的深奥知识。”

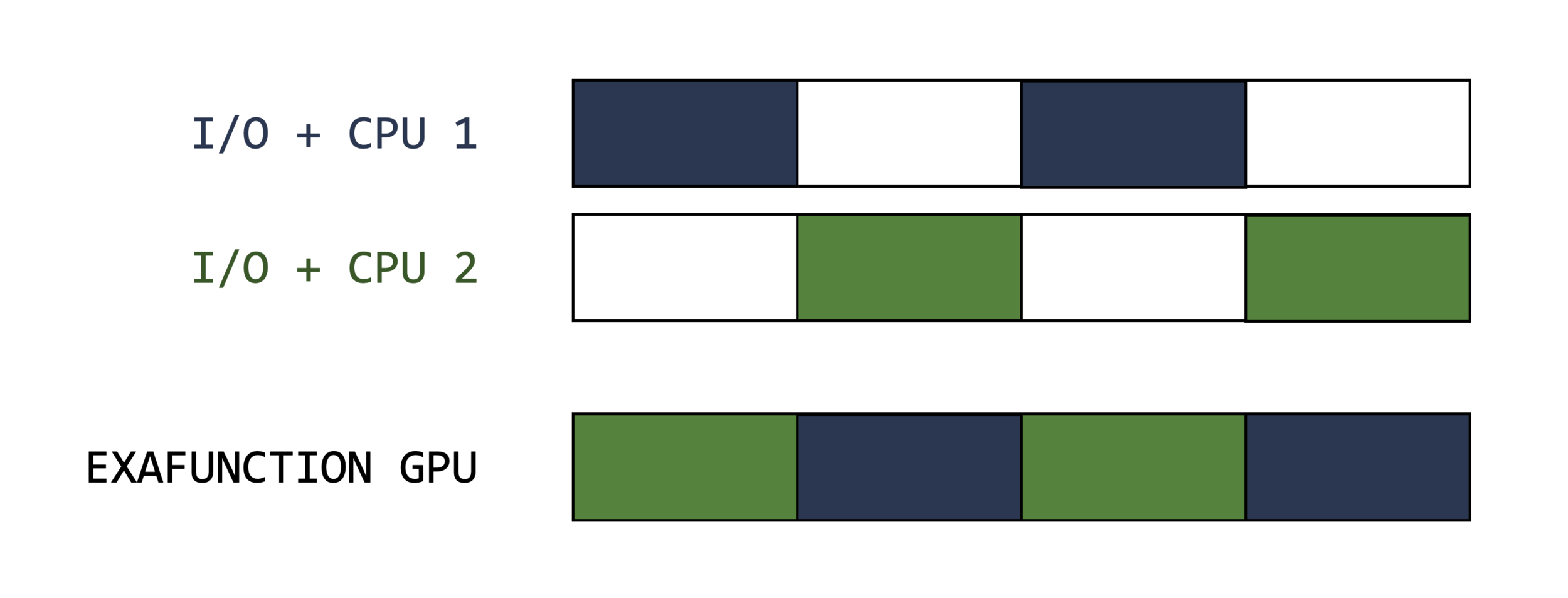

Exafunction 拥有 2800 万美元的风险投资,其中 2500 万美元来自 Greenoaks 牵头、Founders Fund 参与的 A 轮融资,Exafunction 旨在解决其认为的人工智能专业知识短缺的症状:闲置硬件。 GPU 和上述用于“训练”人工智能系统的专用芯片——即提供系统可用于进行预测的数据——经常未被充分利用。因为它们完成一些 AI 工作负载的速度如此之快,所以它们在等待硬件堆栈的其他组件(如处理器和内存)赶上时处于空闲状态。

AI 开发平台 Weights and Biases 的创始人 Lukas Beiwald 报告说,他公司近三分之一的客户平均 GPU 利用率不到 15%。与此同时,在与 Exafunction 竞争的 Run:AI 委托进行的 2021 年调查中,只有 17% 的公司表示他们能够实现人工智能资源的“高利用率”,而 22% 的公司表示他们的基础设施大多处于闲置状态。

成本加起来。 根据Run:AI 的数据,截至 2021 年 10 月,38% 的公司的 AI 基础设施年度预算(包括硬件、软件和云费用)超过 100 万美元。据估计,OpenAI 已花费 460 万美元训练 GPT-3。

“大多数从事深度学习的公司都开展业务,这样他们就可以专注于他们的核心技术,而不是把时间和带宽浪费在优化资源上,”莫汉通过电子邮件说。 “我们认为,没有任何有意义的竞争对手能够解决我们关注的问题,即在为客户提供卓越性能的同时,消除管理 GPU 等加速硬件的挑战。”

一个想法的种子

在共同创立 Exafunction 之前,Chen 是 Facebook 的一名软件工程师,在那里他帮助为 Oculus Quest 等设备构建了工具。 Mohan 是自主交付初创公司 Nuro 的技术主管,负责管理公司的自主基础设施团队。

“随着我们 [在 Nuro] 的深度学习工作负载的复杂性和要求越来越高,很明显没有明确的解决方案来相应地扩展我们的硬件,”Mohan 说。 “模拟是一个奇怪的问题。也许自相矛盾的是,随着软件的改进,您需要模拟更多的迭代才能找到极端情况。你的产品越好,你就越难寻找错误。我们了解到这是多么困难,并花费了数千个小时的工程时间来试图从我们拥有的资源中榨取更多的性能。”

图片来源: Exafunction

Exafunction 客户连接到公司的托管服务或在 Kubernetes 集群中部署 Exafunction 的软件。该技术 https://ift.tt/hPAFUfY 动态分配资源,将计算转移到“具有成本效益的硬件”上,例如可用的现场实例。

当被问及 Exafunction 平台的内部运作时,Mohan 和 Chen 表示反对,他们更愿意暂时保密这些细节。但他们解释说,在高层次上,Exafunction 利用虚拟化来运行 AI 工作负载,即使硬件可用性有限,表面上也能提高利用率,同时降低成本。

Exafunction 不愿透露有关其技术的信息——包括它是否支持像谷歌的张量处理单元 (TPU)这样的云托管加速器芯片——令人担忧。但为了打消疑虑,Mohan 没有透露姓名,他表示 Exafunction 已经在为“一些最先进的自动驾驶汽车公司和处于计算机视觉前沿的组织”管理 GPU。

“Exafunction 提供了一个平台,可将工作负载与 GPU 等加速硬件分离,确保最大限度地提高利用率——降低成本、加速性能,并让公司充分受益于硬件……[该]平台让团队可以在单个平台上整合他们的工作,而无需这

将一组不同的软件库拼接在一起的挑战,”他补充道。 “我们期望 [Exafunction 的产品] 将深刻地推动市场,为深度学习做 AWS 为云计算所做的事情。”

不断增长的市场

Mohan 可能对 Exafunction 有宏伟的计划,但这家初创公司并不是唯一一家将“智能”基础设施分配概念应用于 AI 工作负载的公司。 Beyond Run:AI——其产品还创建了一个抽象层来优化 AI 工作负载——Grid.ai 提供的软件允许数据科学家在硬件上并行训练 AI 模型。就其本身而言,Nvidia 销售AI Enterprise ,这是一套工具和框架,可让公司在 Nvidia 认证的服务器上虚拟化 AI 工作负载。

但是,尽管拥挤,莫汉和陈看到了一个巨大的潜在市场。在对话中,他们将 Exafunction 基于订阅的平台定位为不仅可以降低 AI 开发障碍的一种方式,还可以让面临供应链限制的公司从手头的硬件中“释放更多价值”。 (近年来,由于各种不同的原因,GPU 已成为热门商品。)云总是有的,但在 Mohan 和 Chen 看来,它会推高成本。一项估计发现,使用本地硬件训练 AI 模型比成本最低的基于云的替代方案便宜 6.5 倍。

“虽然深度学习几乎有无穷无尽的应用,但我们最兴奋的两个应用是自动驾驶汽车模拟和大规模视频推理,”Mohan 说。 “仿真是自动驾驶汽车行业所有软件开发和验证的核心……深度学习还导致了自动化视频处理方面的非凡进步,其应用遍及各个行业。 [但是]尽管 GPU 对自动驾驶汽车公司来说是必不可少的,但它们的硬件经常未被充分利用,尽管它们的价格和稀缺性。 [计算机视觉应用程序] 对计算的要求也很高,[因为] 每个新的视频流都有效地代表了一个数据流——每个摄像头每天输出数百万帧。”

Mohan 和 Chen 表示,A 系列的资金将用于扩大 Exafunction 的团队和“深化”产品。该公司还将投资优化“针对延迟最敏感的应用程序”(例如,自动驾驶和计算机视觉)的人工智能系统运行时间。

“虽然目前我们是一个强大而灵活的团队,主要专注于工程,但我们预计将在 2022 年迅速建立我们组织的规模和能力,”莫汉说。 “几乎在每个行业中,很明显,随着工作负载变得越来越复杂(并且越来越多的公司希望利用深度学习洞察力),对计算的需求远远超过 [供应]。尽管大流行凸显了这些担忧,但这种现象及其相关瓶颈在未来几年内将变得更加严重,尤其是随着尖端模型的要求呈指数级增长。”