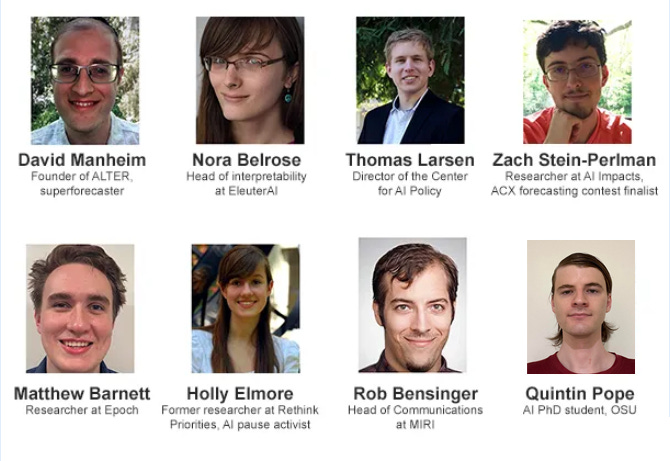

我。 上个月,有效利他主义中心的本·韦斯特 (Ben West)主持了一场由长期主义者、预测者和 x 风险活动人士参加的关于暂停人工智能的辩论。  每个参与其中的人都认为人工智能是危险的,甚至可能毁灭世界,所以你可能会认为暂停——甚至完全停止——是理所当然的。事实并非如此。参与者无法就“暂停”的基本含义、是否可能、或者是否会让事情变得更好或更糟达成一致。 至少对于成功暂停需要什么条件达成了一些共识。参与政府将禁止“前沿人工智能模型”,例如使用比 GPT-4 更多训练计算的模型。较小的模型或新模型的新颖用途都可以,否则将面临 FDA 之类的监管机构。各国将通过监控高性能微芯片对国内公司实施禁令;他们将通过禁止出口此类芯片以及执行条约的通常外交手段(例如核不扩散)来对非参与国政府强制执行。 主要的分歧是:

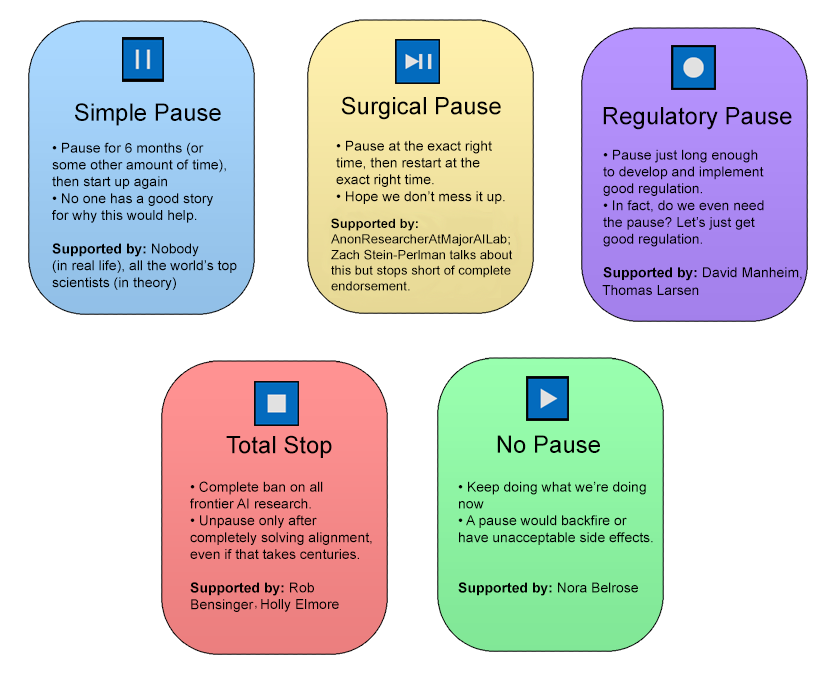

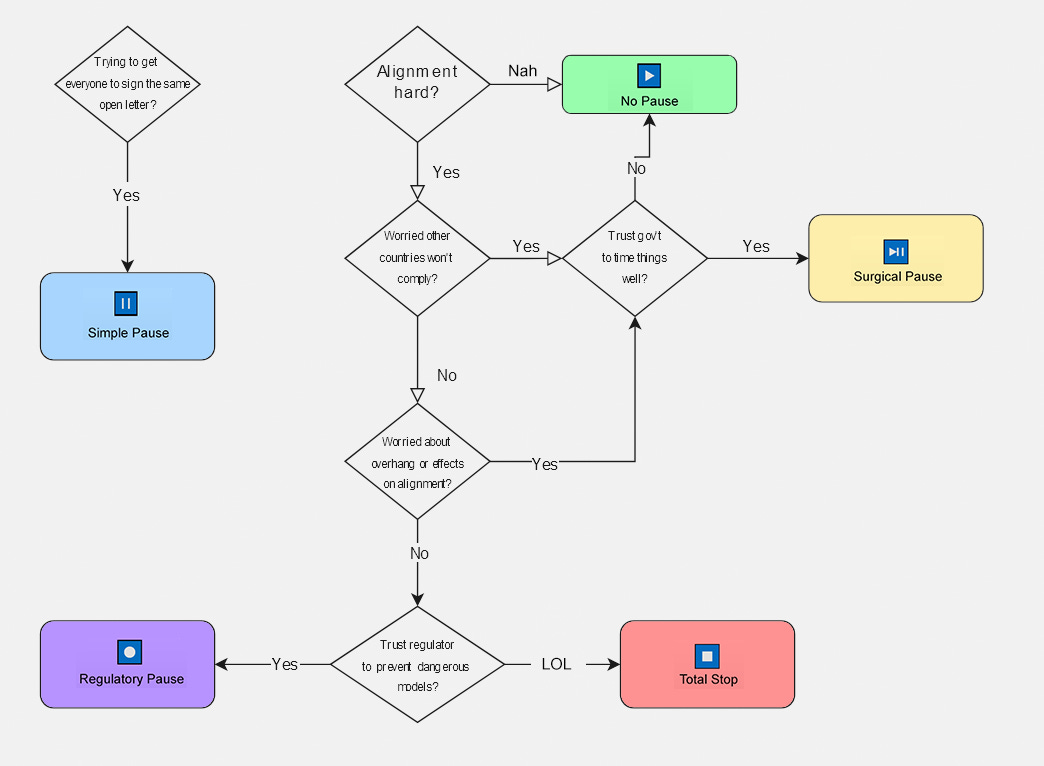

我将意见分为五类:  简单的暂停:如果我们只是要求人工智能公司暂停六个月怎么办?或者可能需要更长的时间? 这是FLI 暂停巨型人工智能实验公开信中的要求,该公开信由数千名人工智能科学家、商人和思想领袖签署,其中包括这场辩论的许多参与者。所以你可能会认为辩论组织者可以找一个人来争论这一点。他们不能。这封信是一种淡化的妥协,以至于没有人真正支持它,尽管每个人都签署了它以表达对它所妥协的一个或另一个立场的支持。 为什么人们不想要这个?首先,大多数人认为人工智能公司无论如何都需要花费六个月以上的准备工作才能开始训练下一个大模型,所以这是没有用的。其次,即使我们这样做,六个月后暂停也会结束,然后我们或多或少就处于现在的状态。除了更糟糕之外,还有两个原因:

这些都被一项好处所抵消:

这种好处是真实的,但这种暂停并不能优化它。技术一致性研究受益于先进的模型进行实验;手术暂停策略更加重视这一点。社会/政治准备取决于某种计划:这就是监管暂停策略所增加的内容。 手术暂停:手术暂停对简单暂停进行了调整,添加了两个额外的注意事项:

显然,外科手术暂停的问题在于,我们可能不知道何时处于危险人工智能的边缘,而且我们可能不知道“好人”有多少领先优势。手术暂停的支持者建议对这两个自由变量都非常保守。这并不是一个经过深思熟虑的计划,而是更多地说“来吧,伙计们,让我们至少尝试在这里采取战略行动”。在极限情况下,这表明我们可能不应该从现在开始六个月内暂停。 由于这涉及领先实验室为了安全而浪费时间,理论上它可以由单个领先实验室单方面完成,无需国际、政府甚至实验室间的协调。但如果你也得到了这些东西,你就可以赢得更多时间。一些领先的实验室已经承诺在时机成熟时这样做——例如OpenAI和DeepMind (之前的迭代) ——可信度各有不同。 AnonResearcherAtMajorAILab 在Aim For Conditional AI Pauses中讨论了一些策略, 这篇 Less Wrong 帖子也非常好。 监管暂停:如果简单暂停的好处之一是利用时间在社会和政治上为人工智能做好准备,也许我们应该暂停,直到完成社会和政治准备。 大卫·曼海姆(David Manheim)建议设立一个像 FDA 这样的监控机构。它将“快速跟踪”小型人工智能和现有人工智能的简单重新应用,但会仔细监控新的“前沿模型”是否存在危险迹象。监管机构可能会通过要求人工智能入侵计算机或传播自身副本来寻找危险功能,或者测试它们是否已针对偏见/错误信息等进行了编程。我们只能暂停,直到我们建立了监管机构,并且只对那些不与我们的监管机构合作或不建立自己的国内监管机构的其他国家采取敌对行动(例如限制芯片出口)。 科技界的许多人都是对监管持怀疑态度的自由主义者,但支持者指出,监管在可预见的方向上失败了:它通常确实成功地阻止了坏事,但它也只是阻止了好事。自1975年核管理委员会成立以来,美国从未发生过重大核事故。当然,这是因为从 1975 年到 2023 年,NRC 根本禁止美国建造任何核电站(一座核电站最终于7 月建成)。尽管如此,他们在技术上还是完成了任务。同样,美国的大多数药物都是安全且相对有效的,但代价是 FDA 批准程序的成本非常昂贵,以至于我们每年只能获得一小部分新药物,数十万人因不必要的延误而死亡。但药物是安全有效的。或者:旧金山住房监管机构几乎从不批准新住房,因此住房成本高达数百万美元,成千上万的旧金山人无家可归——但肯定不会出现坏房子获得批准然后毁掉某人的观点或其他事情的情况。如果我们将这一记录推断到人工智能,人工智能监管机构将过于谨慎,进展将放缓几个数量级或完全停止——但人工智能将是安全的。 如果你认为先进人工智能的问题仅限于更多垃圾邮件或其他东西,那么这是一个令人沮丧的前景。但如果你担心人工智能会毁灭世界,也许你应该接受旧金山住房级别的障碍和挫败感。 如果你认为监管暂停会更稳定(许多行业永远受到严格监管,只有少数自由主义者抱怨),或者如果你认为监管机构偶尔会允许少量安全的监管,那么监管暂停可能比完全停止更好。人工智能正在取得进步。 但如果你预计无论监管如何,持续的进步最终都会产生不安全的人工智能,那么这可能比完全停止更糟糕。如果您担心欺骗性的一致性,例如超级智能人工智能会故意欺骗监管机构,让他们认为自己是安全的,那么您可能会想到这一点。或者你可能认为人工智能最终会变得如此强大,甚至在官方批准之前,它们就可以在封闭的测试环境中危及人类。经典的博斯特罗姆/尤德科夫斯基对齐模型意味着这两件事。 大卫·曼海姆 (David Manheim) 和托马斯·拉森 (Thomas Larsen) 在《暂停中发生了什么?》中阐述了他们首选的这一策略版本。以及减轻人工智能风险的政策想法。 彻底停止:如果你期望人工智能表现出欺骗性的一致性,能够愚弄监管机构,或者非常危险,甚至在监管机构的计算机上测试它们也可能带来世界末日,那么也许唯一的选择就是全面停止。 很难想象完全停止能持续几年以上。你至少面临三个问题:

监管机构可以控制超级计算机的流量,至少在国内是这样。但最终技术将发展到可以在任何事情上训练人工智能的程度。那么你要么必须禁止所有计算,将其限制在逐渐更加极端的水平(1990 MS-DOS 机器!不,打孔卡!),要么接受人工智能即将发生。 不过,你可以想象这会给我们带来几十年的时间。罗布·本辛格 (Rob Bensinger) 在对曼海姆的《暂停中的内容是什么?》的评论中为这一观点辩护。 ,这也是 Holly Elmore 向公众倡导人工智能案例²的背景。 没有暂停:或者我们不能做任何事情。 如果我们认为对齐研究进展顺利,而暂停会搞砸,或者导致计算溢出导致无法研究的快速起飞,或者将领先优势让给中国,也许我们应该坚持当前的进展速度。 诺拉·贝尔罗斯 (Nora Belrose) 在《人工智能暂停可能会适得其反》中提出了这一论点。具体来说:

对于像“信任”或“担心”这样的每个词,假设我的意思是“……足以胜过其他考虑”

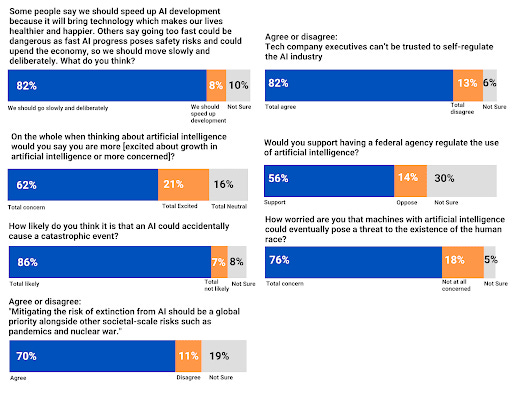

除了这个总体弧线之外,辩论还包括其他一些要点: 霍莉·埃尔莫尔 (Holly Elmore)在《向公众宣传人工智能的案例》中指出,支持暂停的积极分子应该更愿意向公众公开他们的案例。 EA 长期以来一直试图与公司和监管机构合作,但对其执行抗议、广告和活动的能力不太有信心。但在大多数西方国家,公众讨厌人工智能并希望阻止它。如果你也想阻止的话,民主制度提供了肥沃的土壤。 Holly 言出必行,并在旧金山 Meta 办公室领导反人工智能抗议活动;第一个是上个月的,但以后可能会有更多。

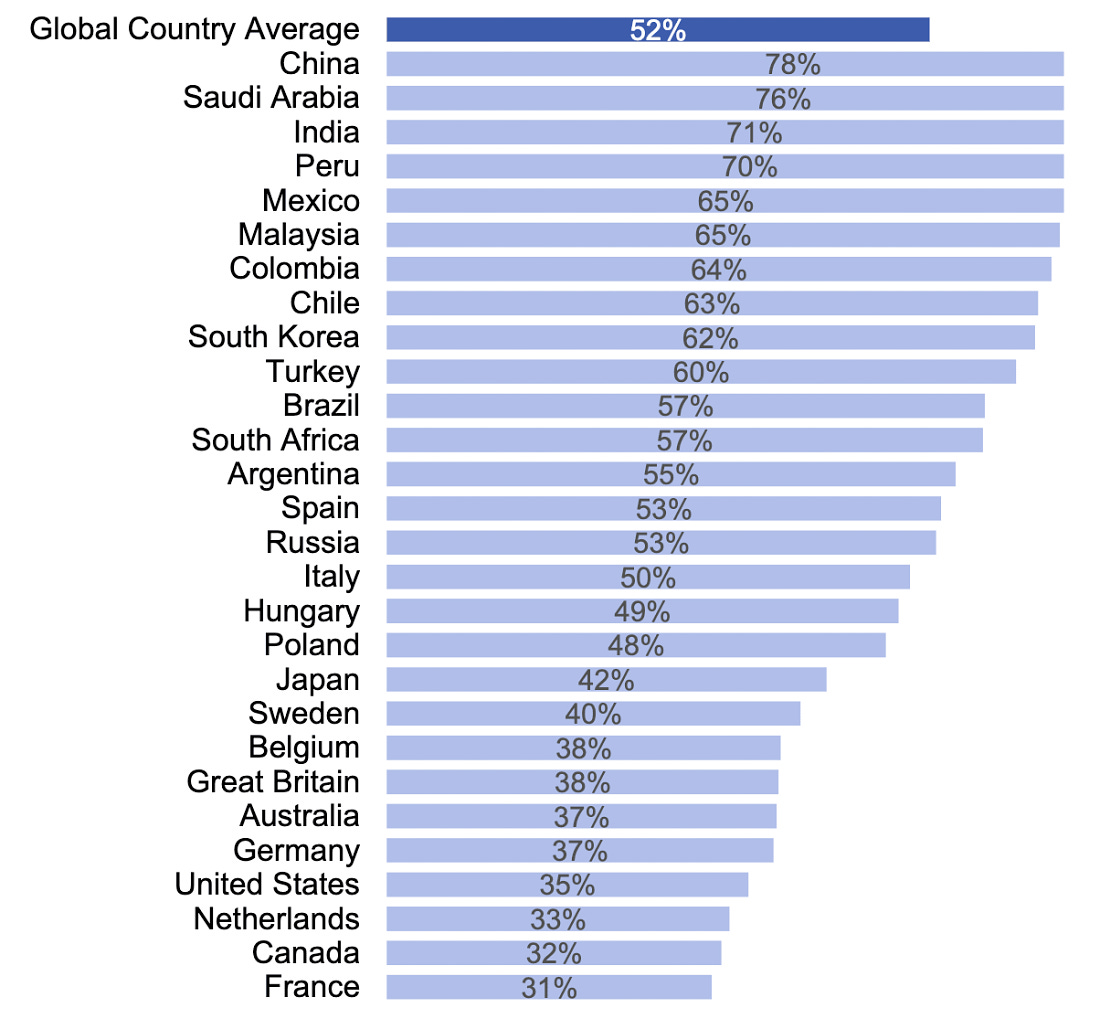

资料来源:人工智能政策研究所和 YouGov,h/t Holly

马修·巴尼特 (Matthew Barnett)在《人工智能无限期暂停的可能性》中表示,一旦开始暂停,就很难控制暂停的长度,并且可能会比那些预期精心计划的外科手术暂停的人更长的时间。他指出,所谓的临时暂停后来变成了永久性的(例如地上核试验禁令、各种基因工程禁令),以及监管机构变得如此严格,导致其监管主题基本上不再发生(例如几十年来核电站建设) )。这种无限期的暂停要么会因计算过剩的灾难性现实而崩溃,要么需要越来越严厉的国际压力来维持。他认为这是反对大多数形式的暂停的有力论据,尽管他愿意考虑看起来有点像监管的“许可”制度。 昆汀·波普 (Quintin Pope)在《人工智能默认是中心化,别让事情变得更糟》一书中表示,人工智能的最大威胁是权力中心化,无论是对独裁者还是企业。人工智能可能是比人类更忠诚的走狗,并且可以让人们比通常的方法更有效地将权力(包括政治权力和金钱)转化为情报。他的兴趣主要在于限制损害,这使他在这场辩论中倾向于其他大多数人。他会支持让小型实验室更容易赶上大型实验室的监管,或者限制人工智能权力集中使用的监管,但反对将人工智能权力集中到一些据称更安全的大公司的监管。

每个国家都有多少人认为人工智能利大于弊。 Pope 使用这张表来表明人工智能监管将是去中心化的,因为最领先的国家最渴望监管。资料来源:益普索; h/t 昆廷

二. 对于“辩论”来说,参与者之间缺乏太多的参与。大多数人贴出宣言后就回家了。 诺拉(Nora)帖子“人工智能暂停可能会适得其反”的评论部分是个例外。和往常一样,很多讨论只是为了澄清大家在争论什么,但也有一些真正的争论:

在《暂停怎么会失败?》大卫·曼海姆讨论了他自己从这场辩论中得到的收获:

三. 补充一些我自己的想法: 首先,我认为在这里担心世界独裁是愚蠢的。全球条约的失败模式是条约没有签署或不起作用。考虑各种全球变暖条约(例如京都议定书)或联合国。尽管许多普通人(即非 x 风险信徒)不喜欢人工智能并同意禁令,但当它开始干扰他们的笔记本电脑或游戏设备时,他们不会支持它,更不用说如果它需要放弃国家主权联合国什么的。 其次,如果我们永远得不到人工智能,我预计未来将是短暂而严峻的。我们很可能用合成生物学自杀。如果不是, 技术和经济停滞、 极权主义崛起+ 反自由主义的某种组合 + 暴政、 生育率崩溃和基因缺陷将使世界陷入贫困,并加速其制度质量的衰退。我不会花太多时间担心这些问题,因为我认为它们需要几代人的时间才能达到危机水平,而且我预计技术会在那之前扭转游戏规则。但如果我们禁止所有游戏板翻转技术(我所知道的唯一另一种技术是基因增强,这甚至更应该禁止),那么我们最终会导致生物武器灾难或社会崩溃。我之前说过,我认为人工智能毁灭世界的可能性约为 20% 。但如果我们没有人工智能,我认为未来 100 年我们有 50% 以上的机会最终死亡或走向委内瑞拉。这并不意味着我必须支持人工智能加速主义,因为 20% 小于 50%。短暂的、精心设计的暂停可以大大提高人工智能顺利进行的机会,同时又不会增加太多社会崩溃的风险。但这是我心里的事。 第三,大多数参与者都同意暂停必然是暂时的。一旦技术变得如此先进,你可以在笔记本电脑上训练人工智能,那么就没有简单的方法来强制执行它,并且(如果没有更广泛地采用x风险论点)政府不会容忍采取强硬的方法。奇点预测小部件当前预测 2040 年。如果我做出重大改变,让每个人都缺乏计算资源,我最多可以将其推迟到 2070 年。这在一定程度上消除了我对上述担忧的担忧,但并非完全如此。马修·巴尼特谈到暂时的停顿是否会变成永久性的,并得出结论,如果没有全球警察国家,可能就不会这样。但我认为 100 年前的人们会对加利福尼亚州有效禁止建造房屋感到惊讶。我认为,如果 100 年前某个反众议院激进分子提出了这一点,人们会告诉她,如果没有一个超级能干的警察国家,这是不可能的。 第四,有很多观点认为暂停是不可能的,但他们大多不反对尝试。我们可以开始谈判一项国际人工智能暂停条约,只有在足够多的其他国家同意我们不希望单方面妨碍自己的情况下才签署该条约。所以“中国绝对不会同意!”这本身并不是反对开始外交的理由,除非你期望仅仅开始谈判就会产生不可抗拒的签署政治势头,即使最终条约是针对我们的。 第五,很大程度上取决于更好的模型是否会使对齐研究变得更容易。我只与少数对齐研究人员讨论过这个问题,但他们说他们仍然忙于 GPT-4。我希望看到关于此的更广泛的调查(可能有人做过这些,我只是不知道在哪里)。 我发现自己愿意考虑尝试监管或手术式的暂停——如果支持者能够确保多边合作,那么这是一个强有力的暂停,否则就是一个较弱的暂停,旨在不让我们落后于敌对国家(这可能不像听起来那么难;到目前为止,中国已经只是复制了美国的进步;是否能进行前沿研究还有待观察)。我并不完全相信政府能够正确处理这个问题,但我愿意在拒绝之前看看他们会提出什么建议。 感谢本和所有参与的人。您可以在此处找到所有帖子,包括我没有涵盖的一些非官方的最新帖子。

1

扎克在一封电子邮件中写道:“我对中国的大部分/大部分担忧并不是中国的价值观比美国差,甚至中国实验室的安全性也比西方实验室差,而是领先的实验室彼此友好更好(主要是为了更好地协调并避免接近终点时的竞争),因此(a)领先实验室的数量最好少一些,(b)考虑到会有西方领先实验室,所有领先实验室最好都在西方,最好是在美国[…] 2

霍莉在一封电子邮件中写道:“我还认为,[你]对对手的单纯暂停和监管暂停之间的区别太过分了。那些出去要求暂停的人(比如我和 PauseAI)大多希望有一个长时间的暂停,这样联盟研究可以发挥作用,可以制定有效的法规,或者在此期间,如果联盟不进行,我们也不会死我想我在我的条目中没有涉及这一点,但我希望看到[你]参与到对齐不会发生的可能性中,特别是因为[你]似乎认为文明会因为一个原因而衰落或未来没有人工智能的另一个。我认为[这篇]文章的假设是过多的人工智能开发作为默认。 “ 3

马修在一封电子邮件中回复道:“我想指出,限制住房的现代做法可以追溯到 1926 年,当时最高法院裁定,执行土地使用监管和分区政策是州警察权力的有效行使。 。我们可以有效地禁止住房的想法对于100年前的人们来说并不是不可想象的,而且确实有很多人(包括本案的原告)都担心这种结果。我认为当时的人们不会说这种分区需要一个能力超强的警察国家。他们更有可能会说分区需要政府权力的侵入性扩张。我认为他们的评估是正确的,我们得到了他们担心的扩张。与禁止住房不同,禁止人工智能要求我们不能有任何例外。如果人工智能可以在瑞士进行训练,那么在美国禁止人工智能还不够。这使得无限期暂停的提议与之前的监管扩张有所不同,在我看来更加激进。如果你认为这种疯狂的提议根本不可行,那么你可能会同意我的观点,即我们不应该推动无限期的停顿。尽管如此,您还预测,如果当前趋势继续下去,“极权主义+非自由主义+暴民统治的崛起、生育率崩溃和基因缺陷将使世界陷入贫困,并加速其制度质量的衰退”。对我来说,这一预测似乎并不比世界各国政府将试图在全球范围内禁止人工智能(草率地,并带来严重负面后果)的预测更疯狂。我认为认真对待其中一种可能性而忽略另一种可能性没有多大意义。” 我的回答:我认为现有的监管框架与预期的监管框架之间存在差异。美国将中产阶级税率提高到99%是符合宪法和法律的,但如果真的发生,大多数人仍然会感到惊讶。我很惊讶政府可以如此轻松地有效禁止某些事物,甚至不需要仅仅通过让它们变得烦人来尝试。这是否会导致人工智能暂停数十年?我的《内部观点》的答案是否定的; my Outside View answer has to be “maybe”. Maybe they could make hardware progress and algorithmic progress so slow that AI never quite reaches the laptop level before civilization loses its ability to do technological advance entirely? Even though this would be a surprising world, I have more probability on something like this than on a global police state. Possible exception if AI does something crazy (eg launches nukes) that makes all world governments over-react and shift towards the police state side, but at that point we’re not discussing policies in the main timeline anymore. You’re currently a free subscriber to Astral Codex Ten . For the full experience, upgrade your subscription.

© 2023 Scott Alexander |

暂停思考:人工智能暂停辩论

……