大家好,

欢迎阅读我们的周日版,我们将花时间讨论影响指数经济的最新发展、思考和关键问题。

感谢阅读!

阿齐姆

要了解本周最重要的主题,请查看我们的每日版:

-

周二:五角大楼全力投入人工智能

-

周三:美国加倍重视数据和能源

-

周四:人工智能的内心独白公开

-

星期五: OpenAI 代理

如果您只想订阅每周版,您可以更改电子邮件偏好设置以选择退出每日版。

图灵之道

OpenAI 的一个新模型在世界最负盛名的数学竞赛——国际数学奥林匹克 (IMO) 上斩获金牌。他们使用了一种“融合了新型实验性通用技术的推理法学硕士 (LLM)”,并在与人类相同的时间限制下,无需任何工具即可完成任务。

该模型可以思考……事实上,根据 OpenAI 研究员 Noam Brown 的说法,它可以思考很长时间,甚至几个小时。人工智能在数学领域的进步速度远超任何人的预期,甚至可能比我们几年前的估计还要快几年。

这很重要,因为国际数学奥林匹克竞赛考察的是超越机械计算的创造性推理能力,它要求详细的逻辑证明,并要求原创的论证。题目设计者刻意追求“优雅、看似简单,却需要大量创造力的问题”。这个系统是否能够在某个重要领域模仿甚至超越人类专家的创造力?

数学是描述物理世界的通用语言,其应用范围涵盖金融、经济、气候、物理、工程、优化、生物等各个领域。当然,它还可用于改进人工智能系统。

这可能是一个里程碑……

真的有可能吗?陶哲轩,这位以跨学科能力而闻名的“数学界莫扎特”,对人工智能的潜力持谨慎乐观的态度,敦促人们保持谨慎:“在缺乏由参赛队伍自行选择的受控测试方法的情况下,我们应该谨慎地将此类模型与人类选手进行同类比较。”

这更像是一种“非时代证明”的情况吗?在评论中告诉我。

六条通往战争的道路

一份新论文指出了先进人工智能可能增加大规模战争风险的六种途径。

最危险的道路之一纯粹是人为的——如果国家领导人开始相信在 AGI 竞赛中失败会大大削弱其全球军事或经济地位,他们可能会采取激烈行动。

假设美国或中国认为其竞争对手即将取得决定性突破;它可能会试图采取预防措施,例如破坏、网络攻击甚至军事打击,以延缓或阻止竞争对手的进展。这里的风险之一是,我们可能对AGI是什么或它是什么样子存在分歧;领导者可能会对竞争对手接近AGI的模糊迹象反应过度。他们的下一步行动可能会导致他们走上不归路。同时,关于AGI确切含义的模糊性也可能使他们犹豫不决。

如果这让你想起了核威慑的历史,那你就错了。

参见:

-

重点介绍了英国人工智能安全研究所的一篇论文,该论文批评了当前关于人工智能“阴谋”的研究存在重大方法论缺陷。

-

本周有人争论说,在构建人工智能时,我们必须回归关于人类繁荣的基本问题,而不仅仅是参与度指标——他们需要一位哲学家建设者。

-

敦促我们需要学术界对人工智能进行更多富有成效的批评,而不是称其为“胡说八道生成器” 。

现实检验

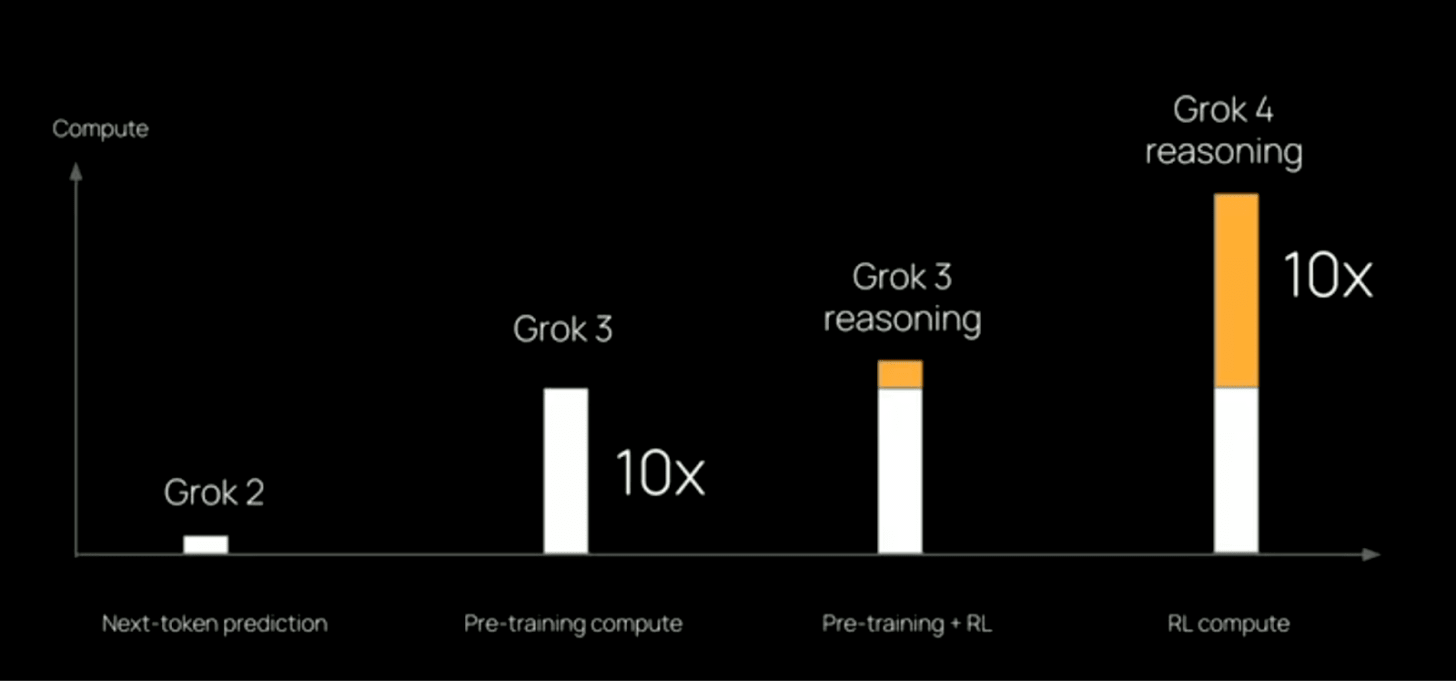

在过去的两周里, ChatGPT Agent和Grok 4都首次亮相,大量使用了强化学习,使其性能显著提升,远超其基础模型。然而,正如 Andrej Karpathy 所说,“这感觉不像是故事的全部。 ” 强化学习虽然强大,但随着任务的延长和复杂程度的提升,其收益会逐渐递减。我们可能需要新的学习范式来推动这一前沿。

强化学习尚未迎来重大突破,无法突然扩展规模,无法生成真正通用且灵活的智能体。即便强化学习确实有所进步,也存在一个根本性的局限性:它只能从结果(“这有效吗?”)中学习,而不是从过程本身中学习。