液冷对于PC爱好者来说是一个耳熟能详的概念,在企业计算领域也拥有悠久的历史。近年来,随着最新芯片功耗的不断提升以及相应的高发热量,液冷在数据中心中扮演着越来越重要的角色。机器学习对功耗和冷却的需求尤其巨大。谷歌指出,水的导热系数约为空气的4000倍,这使得它成为应对当前人工智能热潮带来的冷却需求的极具吸引力的解决方案。他们在Hot Chips 2025大会上的演讲重点介绍了其TPU(机器学习加速器)的数据中心级冷却方案。

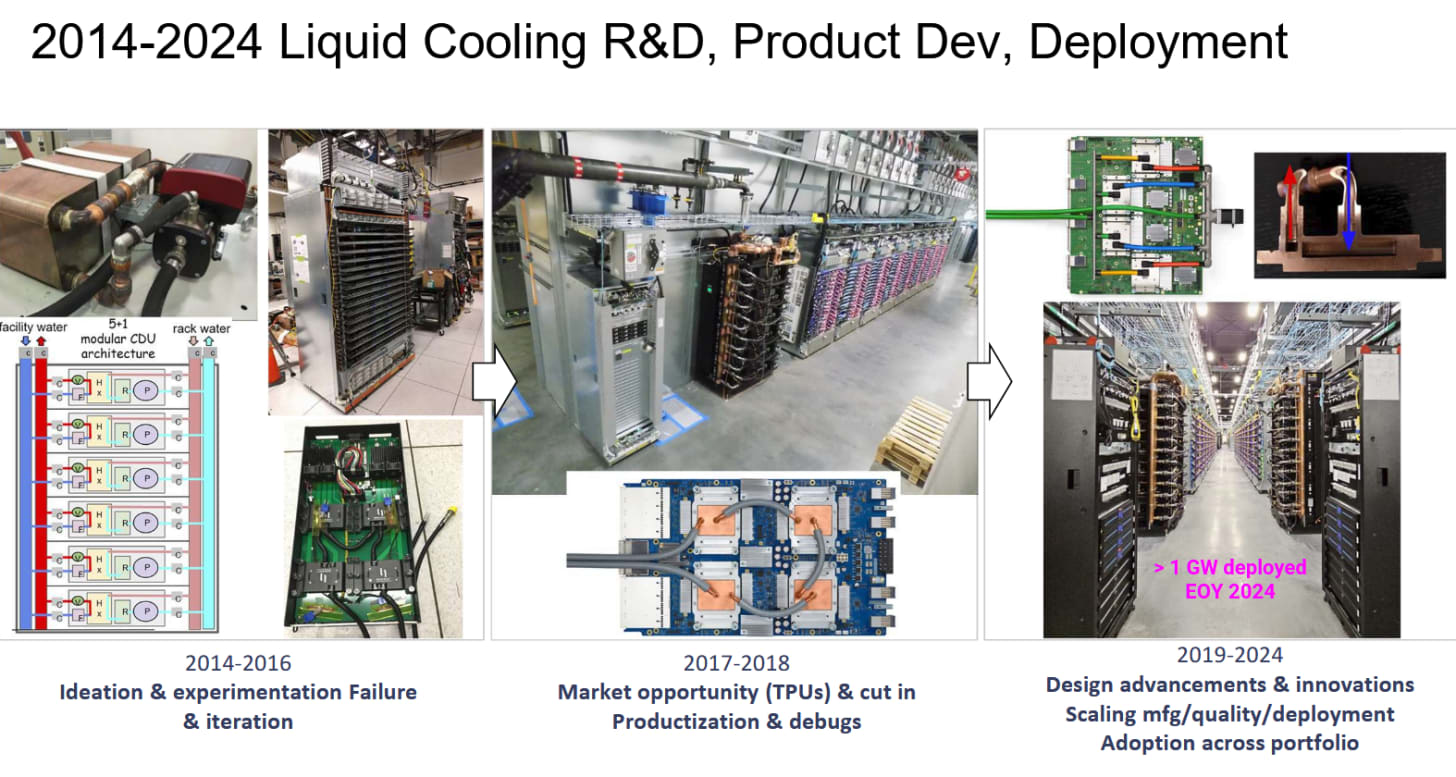

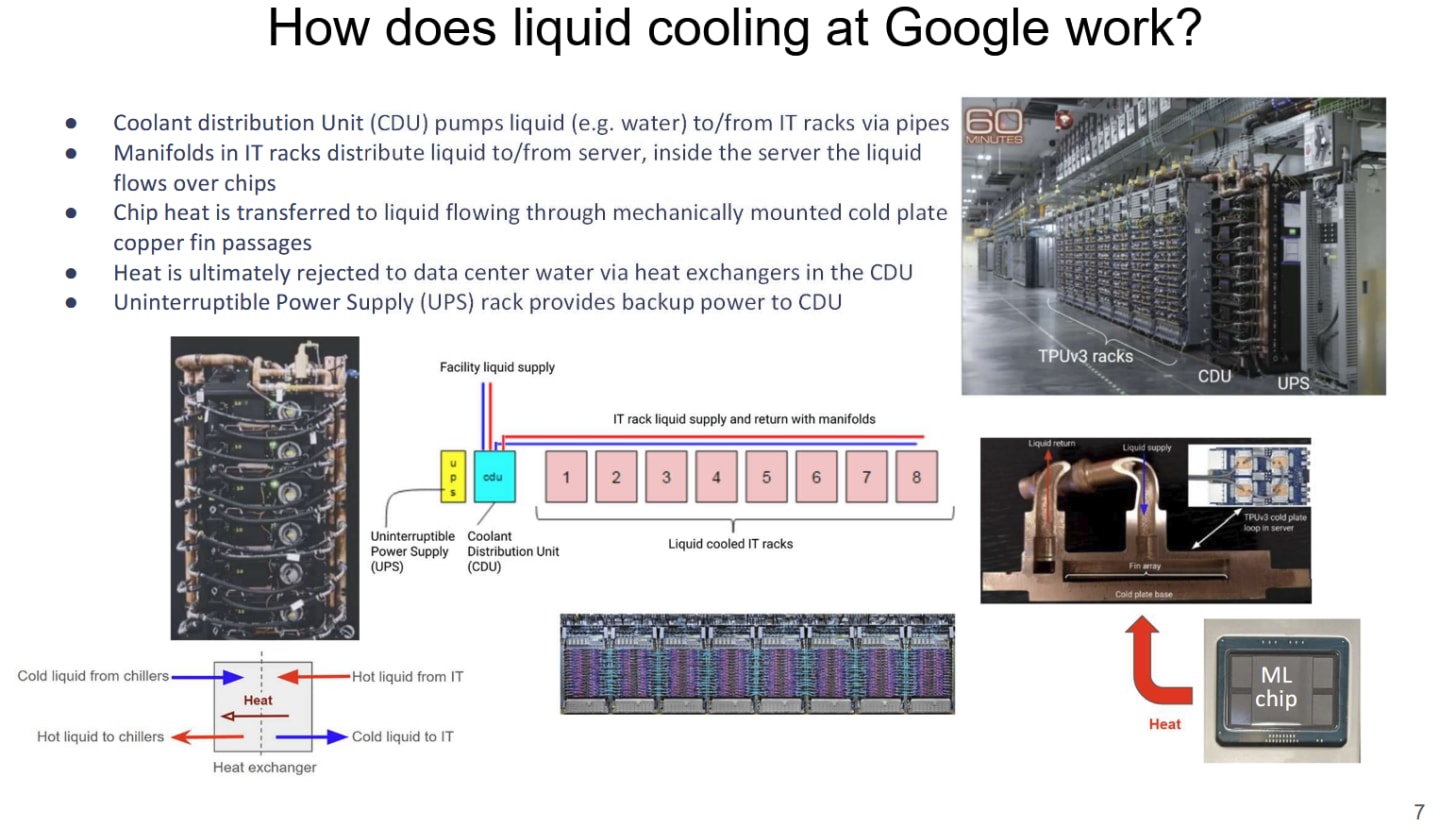

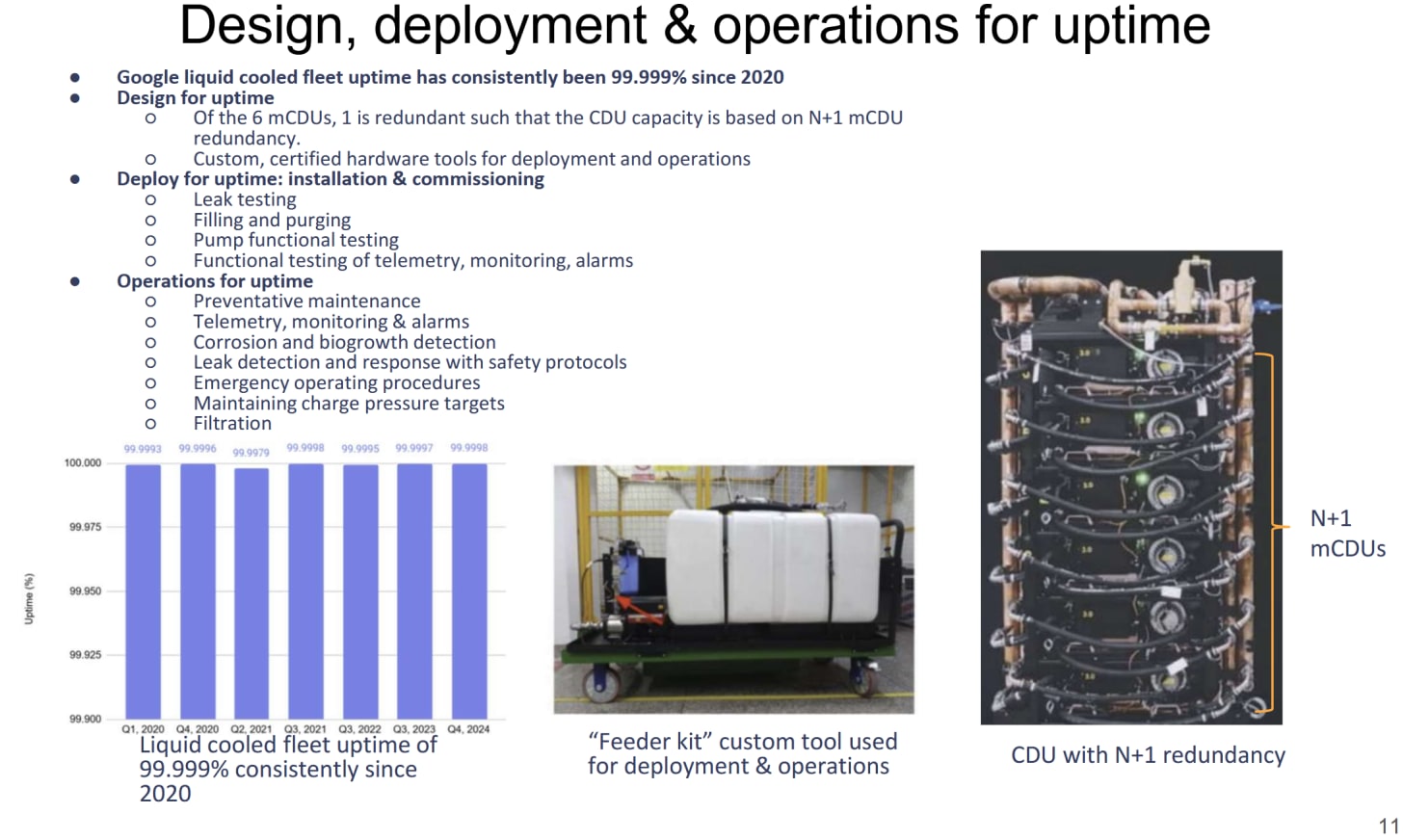

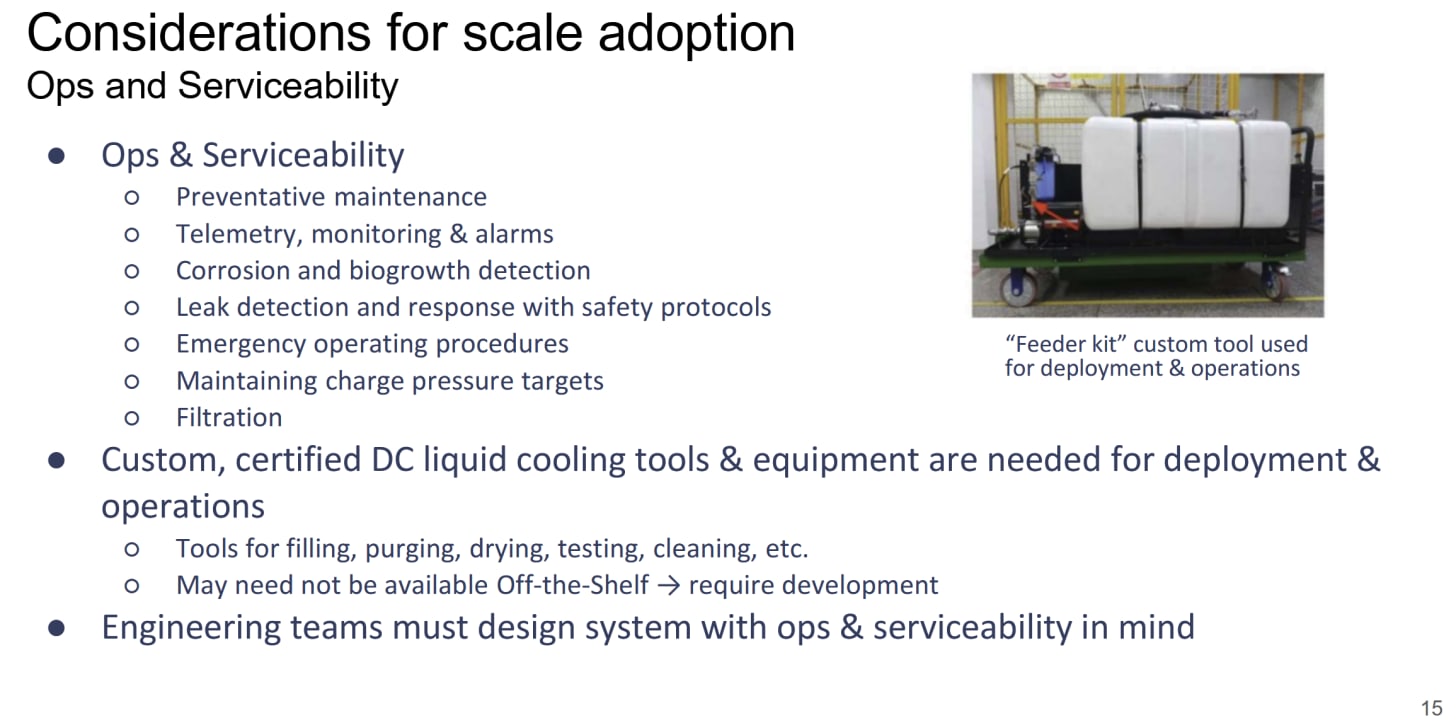

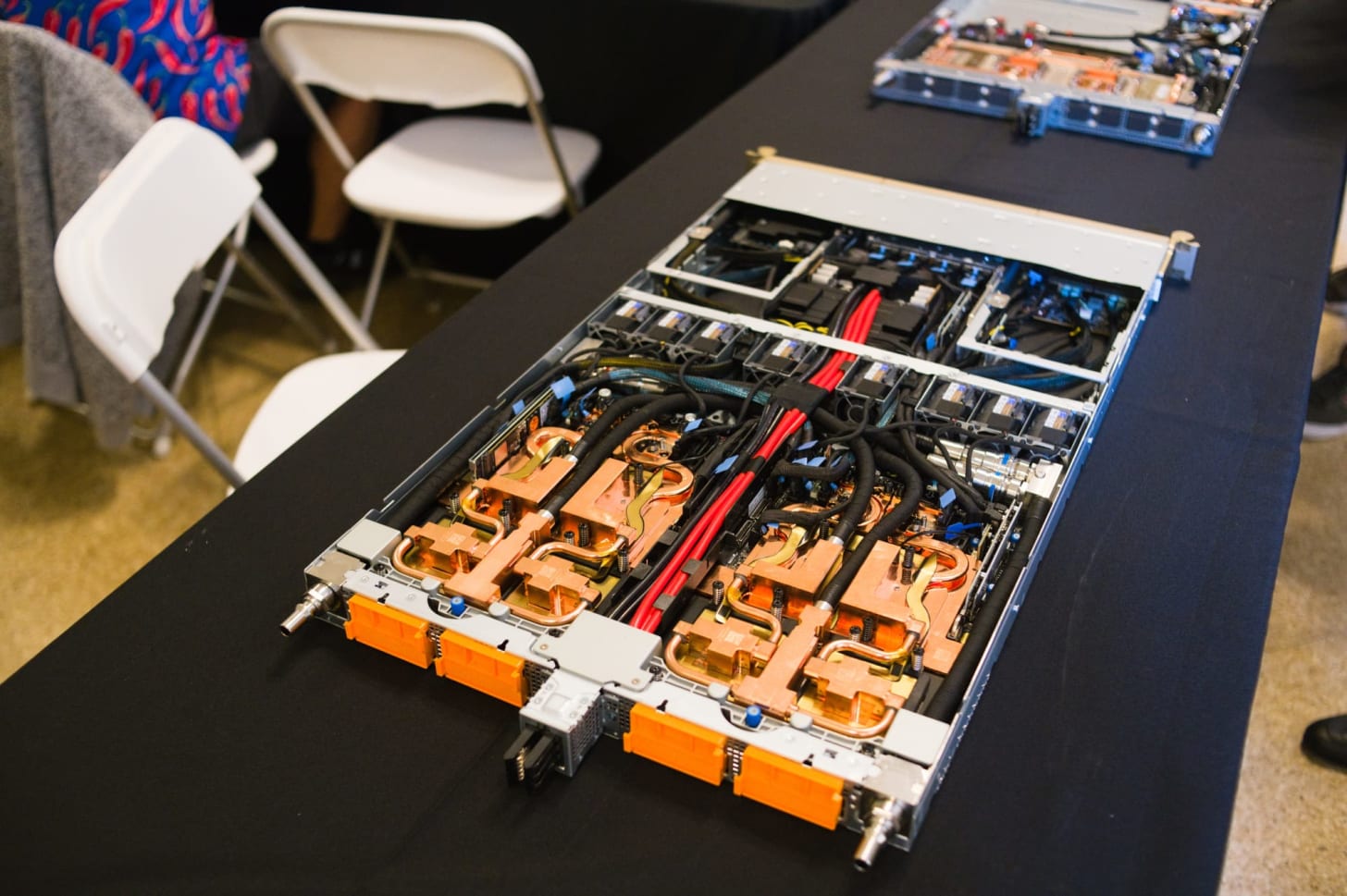

经过多次实验和迭代,谷歌于 2018 年正式进军液冷 TPU 领域。此后,该公司持续开发和改进其冷却设计。他们目前的液冷解决方案专为数据中心规模设计,液冷回路跨越机架,而非局限于服务器内部。由六个 CDU(冷却液分配单元)组成的机架,其作用类似于发烧级水冷回路中的散热器+水泵组合。CDU 使用柔性软管和快速接头,以简化维护并降低公差要求。一个 CDU 机架在五个 CDU 处于活动状态时即可提供充足的冷却能力,因此无需停机即可对一个单元进行维护。

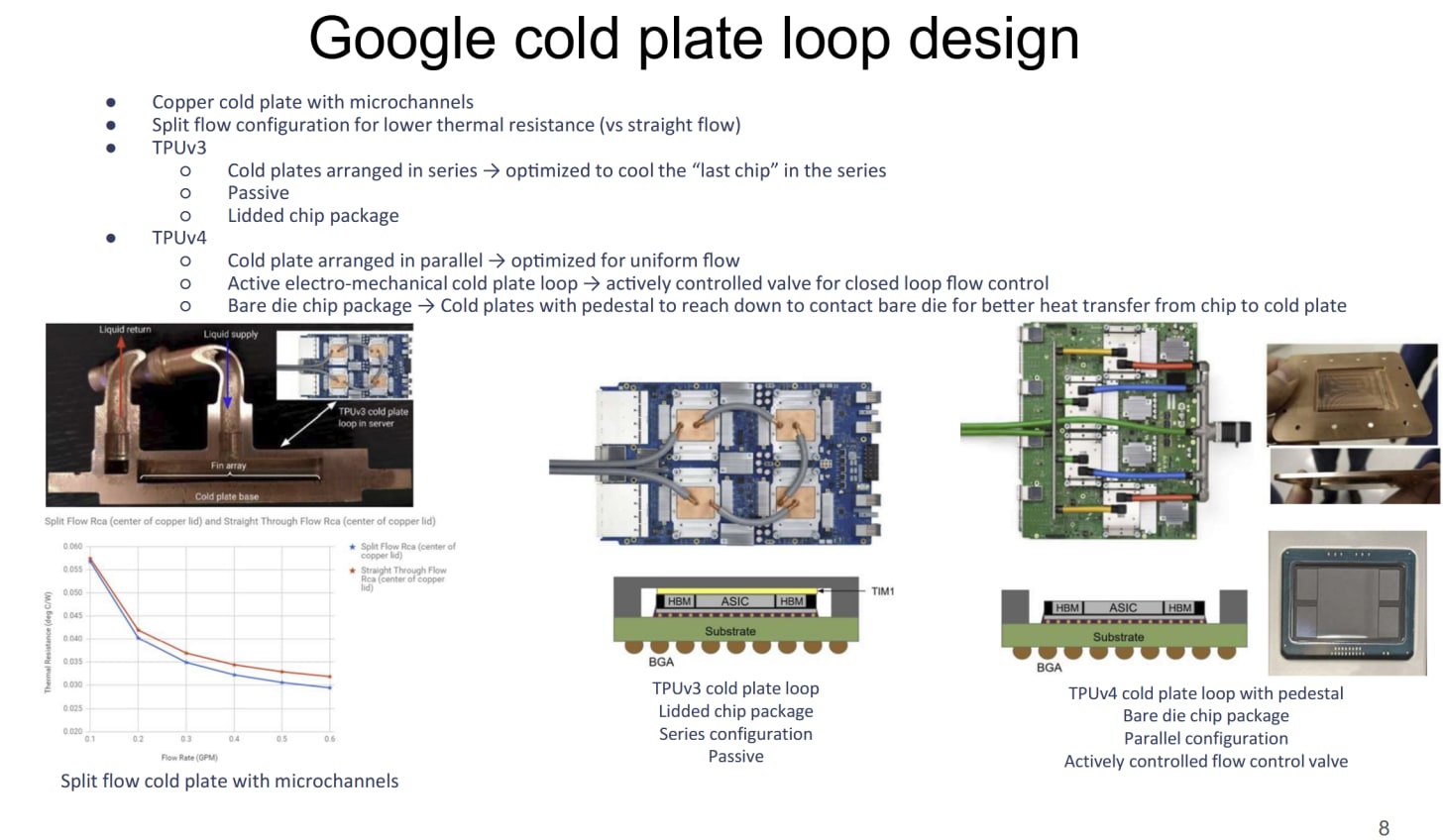

CDU 在冷却液和设施级供水之间交换热量。两种液体供应互不混合,CDU 仅在两个液体池之间传递热量。来自 CDU 的冷却液通过歧管,将冷却液分配到 TPU 服务器。TPU 芯片在回路中串联连接,这自然意味着某些芯片会获得比回路中其他芯片更热的液体。冷却能力的预算基于每个回路中最后一个芯片的需求。

谷歌采用了分流式散热板,并发现其性能优于传统的直通式配置。为了进一步优化散热,谷歌采用了另一种与发烧友领域类似的技术。TPUv4 切换到裸片设置,而 TPUv3 则采用带盖设计。这反映了发烧友领域的去盖化趋势,那些胆子特别大的 PC 组装商会移除散热器(盖子),以获得裸片冷却所能提供的更高传热效率。就谷歌而言,TPUv4 需要这种方法,因为它的功耗是 TPUv3 的 1.6 倍。

除了将芯片热量带走之外,液体冷却还有助于降低与冷却相关的功率要求。Google 发现,液体冷却泵的功耗不到与空气冷却解决方案相关的风扇功耗的 5%。由于 Google 使用水对水的热传递来带走冷却剂的热量,因此大部分冷却功率来自泵。发烧友设置没有意识到这一潜在优势,因为他们使用液体将芯片的热量转移到更适合空气冷却的位置。通常,那是安装在机箱进气口的带有风扇的散热器。理论上,PC 组装者可以尝试将热量交换到马桶水箱,从而在每次冲水时实现高效冷却。但水冷 PC 中的风扇和泵的功率绝对值相当低,尤其是与服务器中常见的高转速风扇相比。因此,发烧友没有理由去解决与冷却相关的功率问题。

最后,维护也是一个问题。PC 爱好者对水冷挑战并不陌生,例如微生物滋生和泄漏风险。数据中心规模的水冷解决方案也面临同样的问题。这两种方案都有一些共同的缓解措施,例如快速断开接头。但数据中心必须在不大幅降低计算能力的情况下应对这些挑战。使用开环系统的 PC 制造商必须先关闭设备,然后再排空环路并更换组件。前面提到的 Google 的额外 CDU 可以实现零停机维护。但 Google 采取的措施远不止于此,因为一台机器的小问题可能会演变成大规模维护的噩梦。

Google 通过泄漏测试对组件进行全面验证,使用警报系统发现泄漏等问题,并采取定期维护和过滤等预防措施。他们还制定了一套清晰的警报和问题响应方案,使庞大的团队能够以一致的方式应对问题。这与那些水冷爱好者维护水冷系统时采取的临时措施截然不同。

总而言之,近期数据中心液冷技术的兴起代表着它与高端发烧级PC的一次精彩交叉。液冷技术以其惊人的散热效率驱动着这两个领域。两者都面临着类似的问题。但数据中心的方案有所不同,其驱动力源于规模和可靠性要求。在Hot Chips 2025的第一天,大量的水冷硬件已经亮相。Nvidia展出了一台GB300服务器,外部水冷连接清晰可见。它还使用了柔性管道,并且还巧妙地配备了风扇。

韩国公司 Rebellions AI 正在演示一款新的机器学习加速器,该公司也配备了水冷装置。他们的新款“REBEL Quad”芯片最终将在 PCIe 卡中使用风冷。但他们的演示使用了冷却器和看起来很酷的水冷头,效果相当惊艳。回顾过去,所有迹象都表明,只要数据中心的冷却需求持续增长,水冷技术就将继续存在。人工智能的蓬勃发展几乎可以肯定这种情况会持续下去。

如果你喜欢这些内容,可以考虑去Patreon或PayPal给 Chips and Cheese 打个广告。也可以考虑加入Discord 。

原文: https://chipsandcheese.com/p/googles-liquid-cooling-at-hot-chips