随着对大型 AI 模型——尤其是像 OpenAI 的 GPT-3 这样的大型语言模型 (LLM) 的兴趣日益浓厚,Nvidia 正在寻求通过面向企业软件开发人员的新的完全托管的、基于云的服务来获利。今天在公司的 2022 年秋季 GTC 会议上,Nvidia 宣布了 NeMo LLM 服务和 BioNeMo LLM 服务,这从表面上看可以更容易地适应 LLM 并为一系列用例部署 AI 驱动的应用程序,包括文本生成和摘要、蛋白质结构预测和更多的。

新产品是 Nvidia 的 NeMo 的一部分,NeMo 是一个用于对话式 AI 的开源工具包,旨在最大限度地减少甚至消除开发人员从头开始构建 LLM 的需求。 LLM 的开发和培训成本通常很高,最近的一个模型——谷歌的 PaLM——利用公开可用的云计算资源估计要花费 900 万到 2300 万美元。

Nvidia 声称,使用 NeMo LLM 服务,开发人员可以在几分钟到几小时内创建大小从 30 亿到 5300 亿个参数的模型,其中包含自定义数据。 (参数是从历史训练数据中学习到的模型的一部分——换句话说,是通知模型预测的变量,比如它生成的文本。)模型可以使用一种称为提示学习的技术进行定制,Nvidia 表示这种技术允许开发人员使用数百个示例为特定的行业特定应用程序(例如客户服务聊天机器人)定制经过数十亿数据点训练的模型。

开发人员可以在无代码“游乐场”环境中为多个用例定制模型,该环境还提供实验功能。一旦准备好部署,调整后的模型就可以在云实例、本地系统或通过 API 上运行。

BioNeMo LLM 服务类似于 LLM 服务,但针对生命科学客户进行了调整。 Nvidia 表示,它是 Nvidia 的 Clara Discovery 平台的一部分,很快就会在 Nvidia GPU Cloud 上提供早期访问权限,它包括用于化学和生物学应用的两种语言模型,以及对蛋白质、DNA 和化学数据的支持。

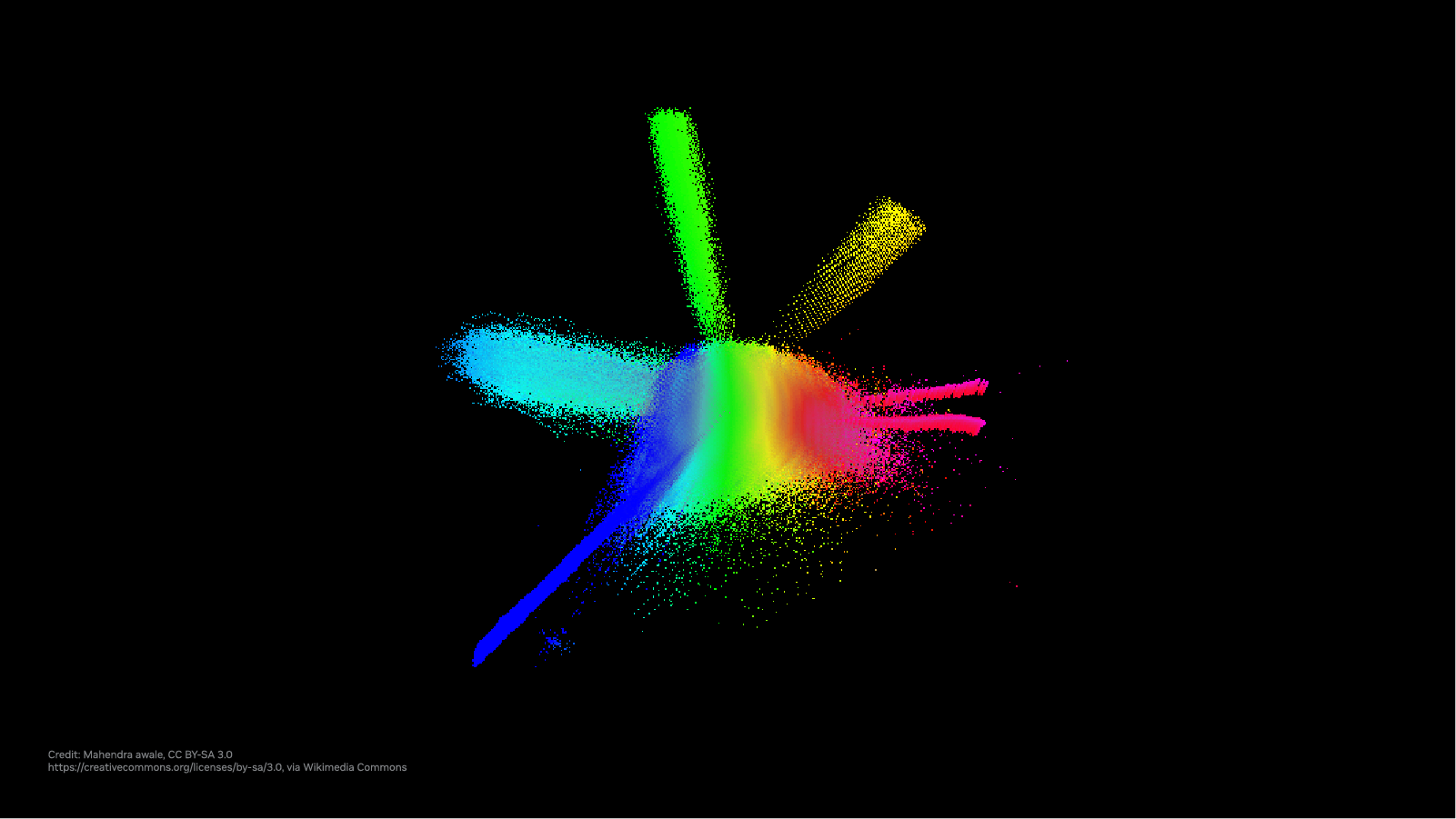

人工智能模型预测的生物过程的可视化。

BioNeMo LLM 将包括四个预训练的语言模型,包括 Meta 的 AI 研发部门 Meta AI Labs 的模型,该模型处理氨基酸序列以生成可用于预测蛋白质特性和功能的表示。 Nvidia 表示,在未来,使用 BioNeMo LLM 服务的研究人员将能够定制 LLM 以获得更高的准确性

最近的研究表明,法学硕士非常擅长预测某些生物过程。这是因为像蛋白质这样的结构可以被建模为一种语言——一种将字典(氨基酸)串在一起形成一个句子(蛋白质)的语言。例如,Salesforce 的研发部门几年前创建了一个名为ProGen的 LLM 模型,该模型可以生成结构上、功能上可行的蛋白质序列。

BioNeMo LLM 服务和 LLM 服务都包括通过云 API 使用现成和定制模型的选项。使用这些服务还允许客户访问 NeMo Megatron 框架,该框架现在处于公开测试阶段,允许开发人员构建一系列多语言 LLM 模型,包括 GPT-3 类型的语言模型。

英伟达表示,汽车、计算、教育、医疗保健和电信品牌目前正在使用 NeMo Megatron 推出中文、英文、韩文和瑞典文的人工智能服务。

NeMo LLM 和 BioNeMo 服务和云 API 预计将于下个月开始提供早期访问。至于 NeMo Megatron 框架,开发者可以通过 Nvidia 的 LaunchPad 试点平台免费试用。

Nvidia 推出了用于训练大型语言模型的新服务Kyle Wiggers最初发表在TechCrunch上

原文: https://techcrunch.com/2022/09/20/nvidia-launches-new-services-for-training-large-language-models/