目前,几乎每个软件领域都已推出或探索了人工智能功能。尽管用例广泛,但大多数实现都大同小异(“让我们在应用中添加一个聊天面板”)。因此,问题也大同小异。

能力意识

AI 模型的开放式界面与之前所有“隐形”界面都面临同样的问题。如果没有清晰的可供性,人们就不知道自己能做什么。这些隐形 UI 的愿景一直是“语音界面只有在你能问它任何问题时才能正常工作”。而如今,愿景是“AI 聊天界面只有在你能告诉它做任何事情时才能正常工作”。听起来很棒,但是……

事实上,即使是极其强大的系统(就像极其强大的人一样)也有局限性。它们在某些方面做得很好,在某些方面还可以,而在另一些方面则做得很差。你要求它们做事的方式也很重要,因为不同的措辞会产生不同的结果。但如果没有可供性,这些指导方针就像用户界面一样隐形。

我确信这是当今人工智能产品界面中最大的问题:因为大规模人工智能模型可以做很多事情(但不是所有的事情或所有的事情都做得同样好),所以大多数人不知道它们能做什么,也不知道如何最好地指导/提示它们。

- 通过产品设计管理能力意识的一些方法:

- 让人工智能模型进行提示:让人工智能模型重写和优化人们的初始提示以获得更好的结果。

- 对话式 UI 中的建议问题:让人们了解 AI 聊天界面具有哪些功能。

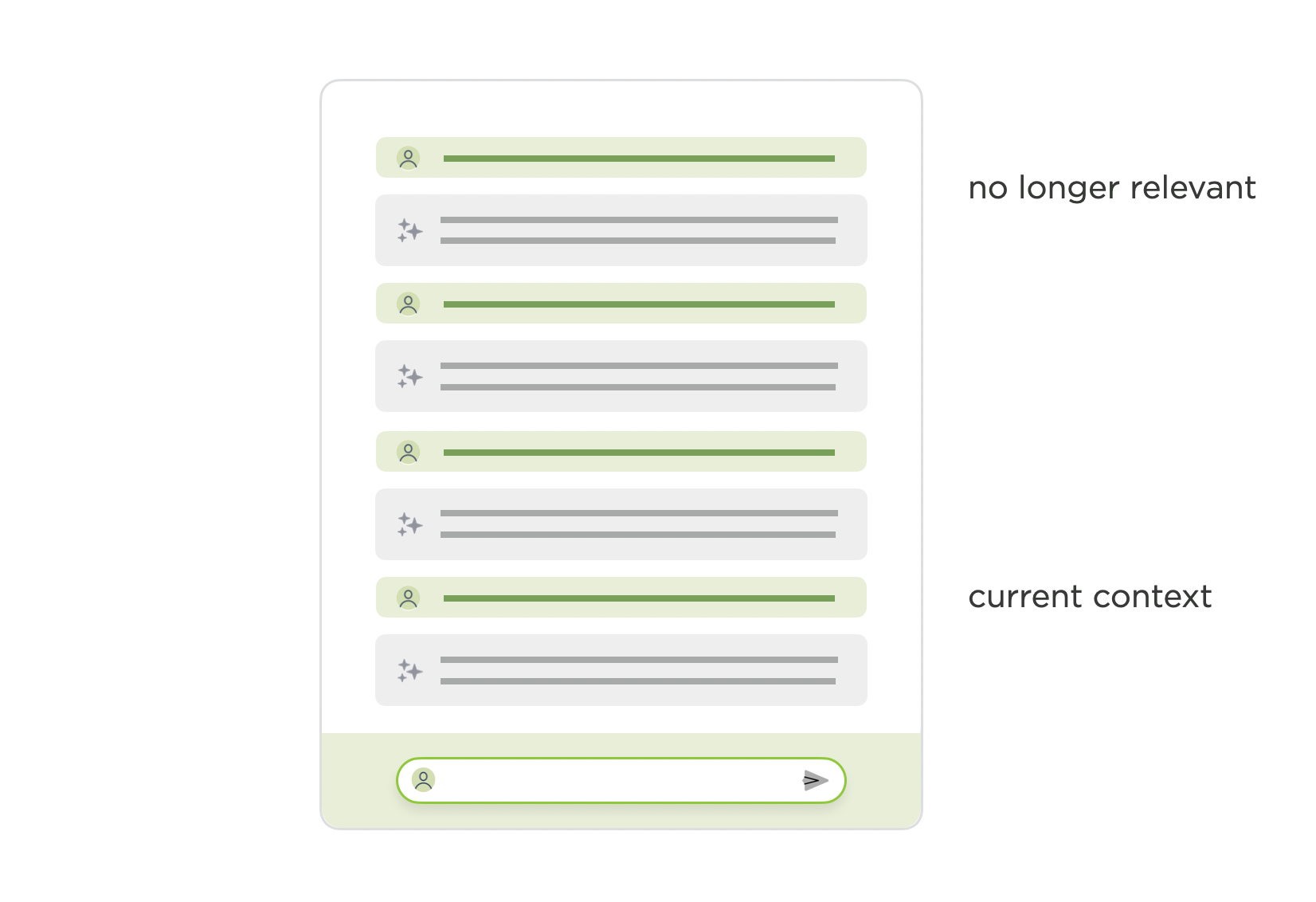

情境感知

如果说能力感知是指了解 AI 产品能做什么,那么情境感知则是指了解它是如何做到的。这里的核心问题是“AI 产品使用了哪些信息来提供答案?” 但潜在的答案有很多,尤其是在代理可以使用越来越多、越来越多样化的工具的情况下。以下是一些在情境中可能出现的情况(在 AI 模型的响应中考虑):

- 这是它自己的训练数据吗?如果是的话,截止时间是什么时候?

- 你和模特的会面历史记录?如果有,可以追溯到多久以前?

- 所有会话的历史记录或用户个人资料?如果是,是哪些部分?

- 像搜索或浏览这样的特定工具?如果是,它们会显示哪些结果?

- 是否与其他服务或账户有关联?如果是……

你明白我的意思了。很多东西可能在特定时刻符合上下文,但并非所有东西都会始终符合上下文,因为模型有上下文限制。所以当收到回复时,人们不确定是否应该信任它们,或者在多大程度上应该信任它们。他们使用的信息是否正确(幻觉)?

- 通过产品设计管理情境感知的一些方法:

- 后台代理减少上下文窗口问题:后台代理鼓励人们对每个离散任务使用不同的上下文窗口。

- 通过上下文检索增强提示:将人们的指令转换为通过自动添加有用的上下文编写的优化提示。

- 流式引用:添加相关文章、视频、PDF 等的引用,用于实时回答问题。

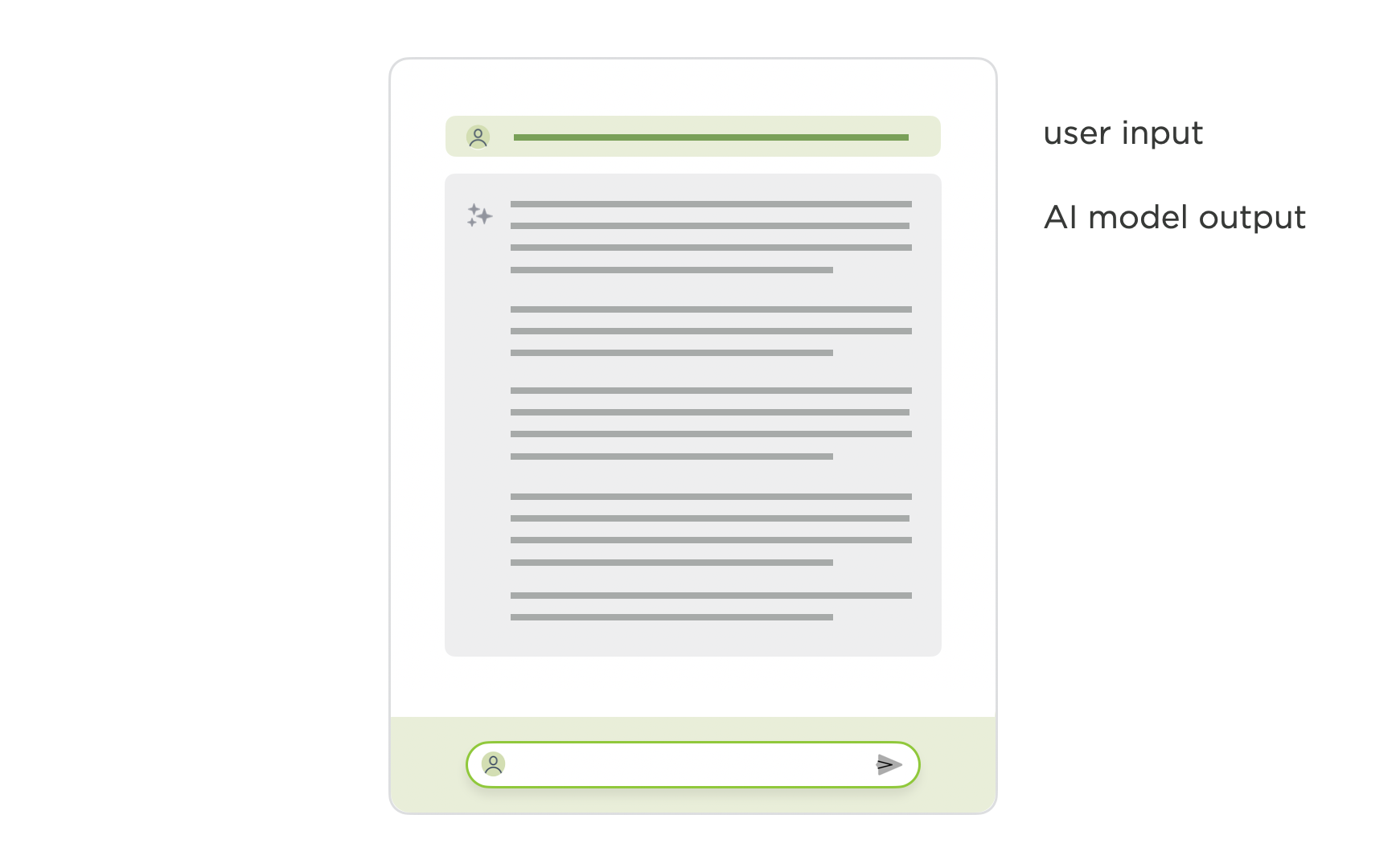

文字墙

虽然书写在促进沟通方面发挥了巨大作用,但它并非传递信息的唯一媒介,而且通常并非最佳选择。尽管如此,大多数人工智能产品仍将人工智能模型生成的文本流作为主要输出,并以线性的“类似聊天”的界面呈现。毫不奇怪,人们很难通过滚动浏览长篇文本来提取和回忆信息。

随着人工智能模型能够编写文本的新鲜感逐渐消失,人们越来越多地要求以视觉效果、表格和其他格式(如幻灯片、电子表格)作为输出,而不仅仅是大段的文字。

- 使用产品设计来管理文本墙的一些方法:

- 可用于 AI 模型的聊天界面:设计用于管理冗长的 AI 模型响应的解决方案。

- 人工智能聊天的作用逐渐减弱:减少与人工智能模型来回聊天以获取信息的需要。

- 流式内嵌图像:不仅返回流式文本和引文,还返回内嵌图像。

还有更多……

是的,AI 产品还存在其他问题。我并不是说这是一份完整的清单,但它反映了我在用户测试和跨多个领域反复看到的问题。不过,AI 产品现在还处于发展初期,所以……未来还会有更多解决方案和问题出现。