与其照看产品,不如打造产品。(赞助内容)

Coinbase、MSCI 和 Zscaler 的工程团队至少有一点共同之处:他们使用 Resolve AI 的 AI SRE 将 MTTR 速度提高 5 倍,并将开发效率提高 75%。

就生产问题而言,数字令人触目惊心:54%的重大停机事故造成的损失超过10万美元。停机每年给全球2000强企业造成约4000亿美元的损失。

这就是为什么工程团队利用我们的 AI SRE 来关联代码、基础设施和遥测数据,并提供实时根本原因分析、指导性补救措施和持续学习。

是时候尝试一下人工智能SRE了?本指南涵盖以下内容:

-

AI SRE 的投资回报率

-

无论你应该自建还是购买

-

如何评估 AI SRE 解决方案

最近,一位名叫马特·迪特克(Matt Deitke)的24岁研究员收到了来自Meta超级智能实验室的2.5亿美元邀约。虽然邀约的具体细节尚未公开,但许多人认为他在多模态模型方面的工作,尤其是那篇名为Molmo的论文,起到了关键作用。Molmo的突出之处在于,它展示了如何在不依赖任何封闭专有系统的情况下,从零开始构建一个强大的视觉语言模型。在大多数开放模型都间接依赖私有API获取训练数据的当下,这一点尤为难得。

本文解释了 Molmo 是什么,它为何如此重要,以及它如何解决视觉语言建模领域长期存在的问题。文章还详细介绍了使 Molmo 独具特色的数据集、训练方法和架构设计。

Molmo解决的核心问题

视觉语言模型(VLM)是指像 GPT-4o 或 Google Gemini 这样的系统,它们能够同时理解图像和文本。我们可以让它们描述图片、识别物体、回答关于场景的问题,或者进行需要视觉和文本理解能力的推理。

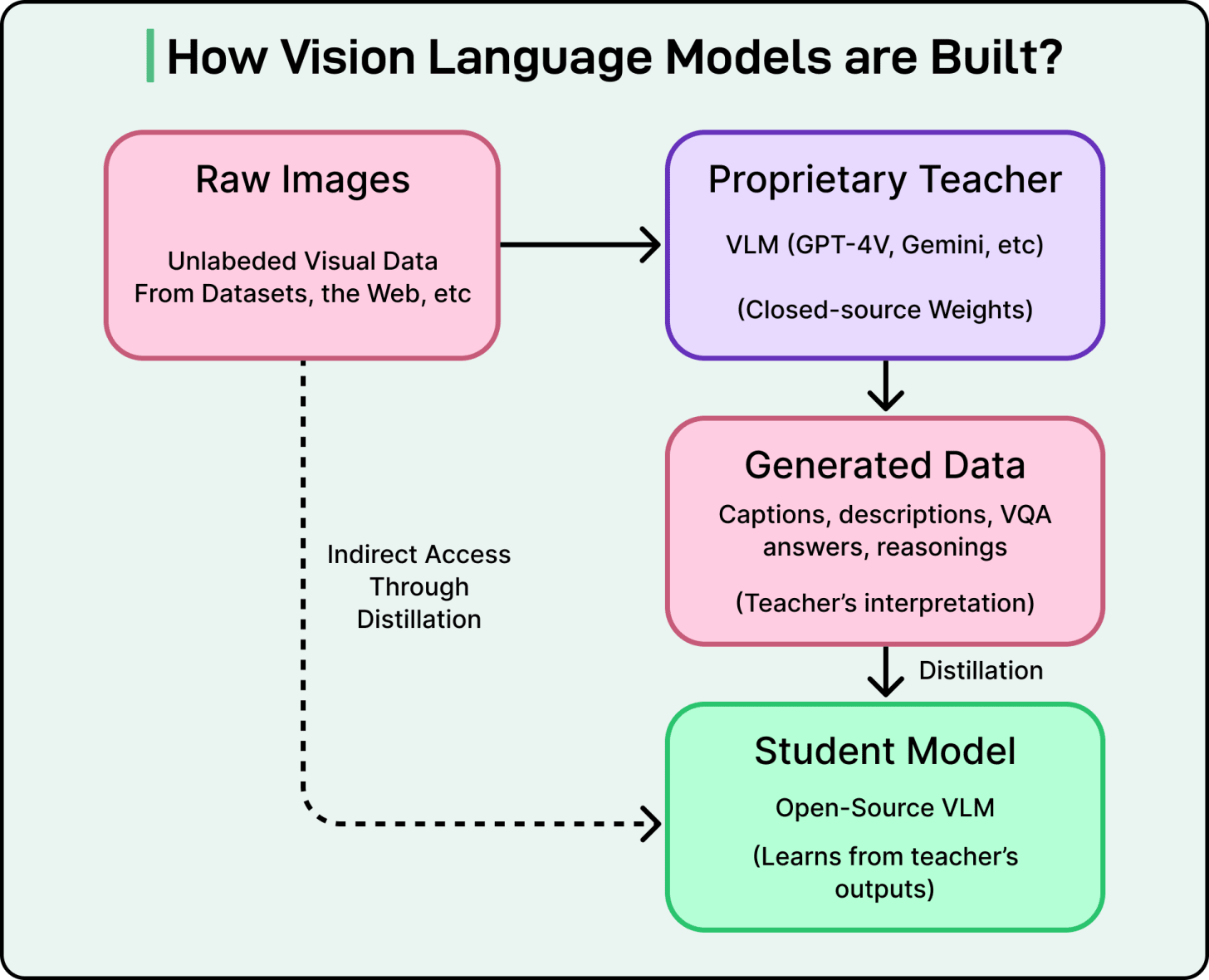

请看下图:

目前存在许多开放权重的可变长度模型(VLM),但它们大多依赖于一种称为蒸馏的训练方法。在蒸馏中,较小的学生模型通过模仿较大的教师模型的输出来学习。

总体流程如下:

-

老师看到了一张图片。

-

它会输出“一只黑猫坐在红色沙发上”。

-

研究人员收集这些结果。

-

学生接受训练,以复述老师的答案。

开发者可以使用诸如 GPT-4 Vision 之类的专有模型生成数百万条图像描述,然后将这些描述用作“开放”模型的训练数据。这种方法速度快、成本低,因为它避免了大规模的人工标注。然而,它也带来了一些严重的问题。

-

第一个问题是结果并非真正开放。如果学生模型是基于私有 API 中的标签进行训练的,那么没有该 API 就无法重新创建模型。这会造成永久性的依赖关系。

-

第二个问题是,社区没有学会如何构建更强大的模型,而是学会了如何复制封闭模型的行为。基础知识仍然被锁在柜子里。

-

第三个问题是性能会受到限制。学生模型很少能超越其教师,因此模型会继承教师的优点和缺点。

这就像抄袭同学的作业一样。也许暂时能蒙混过关,但我们无法掌握其中的根本技能,而且如果同学不再帮忙,我们就束手无策了。

Molmo旨在打破这种循环。它完全基于不依赖现有虚拟语言模型(VLM)的数据集进行训练。为了实现这一点,作者还创建了PixMo,这是一套人工构建的数据集,构成了Molmo训练的基础。

PixMo 数据集

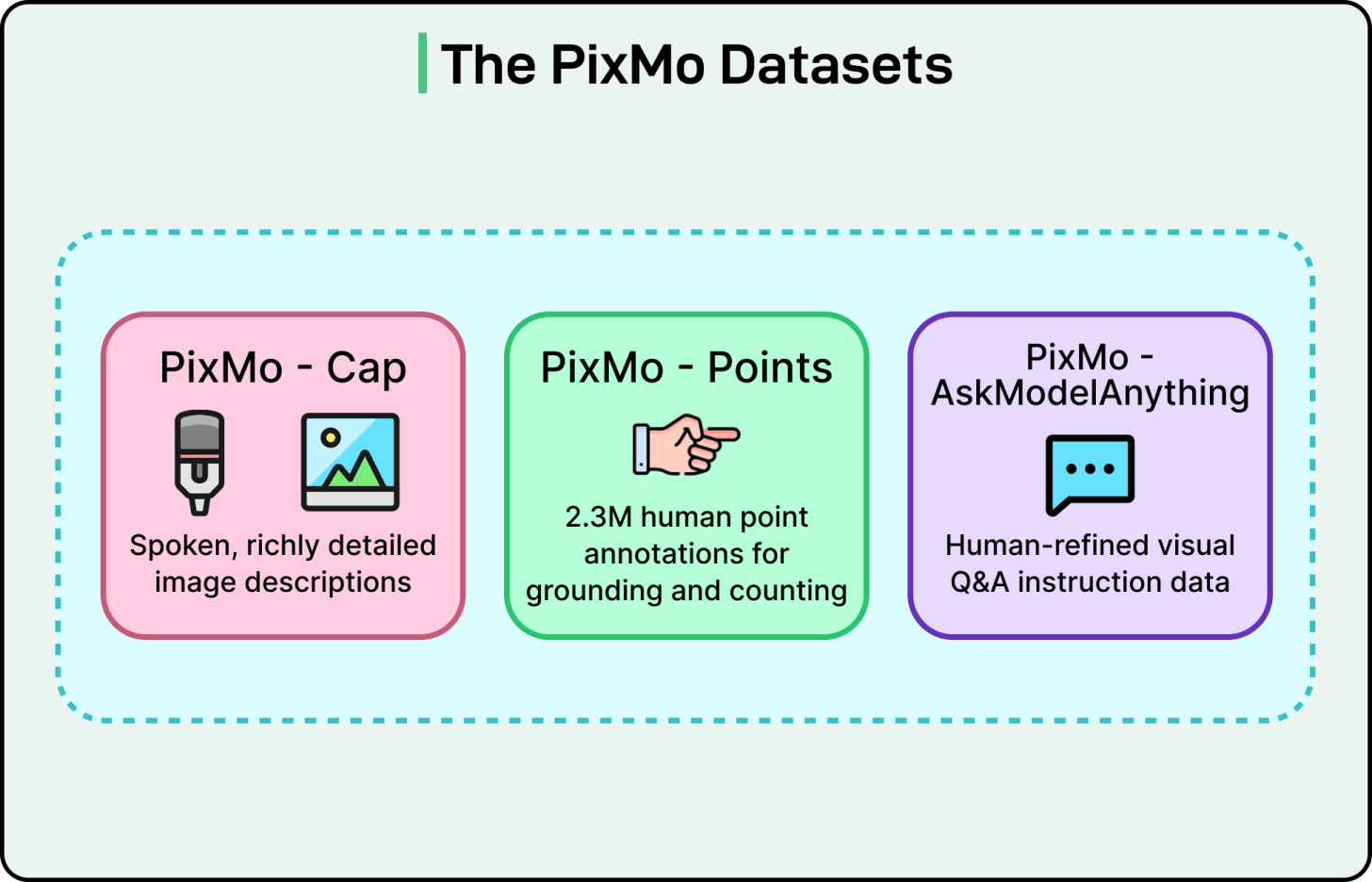

PixMo 是七个数据集的集合,所有数据集均未使用任何其他视觉语言模型创建。PixMo 的目标是提供高质量、不依赖视觉语言模型的数据,以便从零开始训练 Molmo。

PixMo 数据集主要由三个部分组成:

PixMo Cap:密集字幕

为了进行预训练,Molmo 需要丰富的图像描述。输入冗长的图像说明既慢又累,因此研究人员采用了一种简单而有效的方法:他们要求标注者用 60 到 90 秒的时间口头描述每张图像,而不是打字。

人们在说话时自然会描述得更详细。最终生成的字幕平均包含196个单词。这比COCO等典型数据集的字幕详细得多,COCO的字幕平均只有11个单词左右。随后,音频被转录,生成了一个包含大量高质量文本的数据集。这些录音也证明了这些描述是由真人生成的。

这些长篇说明文字包含了对光线、背景虚化、物体关系、微妙的视觉线索,甚至艺术风格的观察。这使得莫尔莫对图像的理解比简短的说明文字更加深刻。

PixMo 点:指向和接地

PixMo Points 可能是该项目中最具创新性的数据集。团队收集了超过 230 万个点标注。

每次标注都只需点击图像中的特定像素。由于点击比绘制边界框或分割掩码更快,因此数据集可以快速扩展。

这些要点注释教会了莫尔莫三项重要能力:

-

指向物体。

-

通过指认来计数物体。

-

通过展示证据所在位置,提供直观的解释。

该数据集有助于模型将语言与精确的空间区域联系起来,使其能够更好地理解图像。

PixMo AskModelAnything:操作说明

该数据集提供了关于图像的问题和答案对。它是通过人工监督过程创建的。

步骤如下:

-

人工标注员针对图像提出问题。

-

仅语言 LLM 根据 OCR 文本和密集标题生成草稿答案。

-

注释者审核答案。

-

标注者可以接受、拒绝或要求修改版本。

由于LLM只识别文本而不识别图像本身,因此数据集不包含VLM。所有答案均经过人工审核。

莫尔莫建筑与培训

Molmo 使用了大多数视觉语言模型中常见的结构。

视觉转换器充当视觉编码器。大型语言模型负责推理和文本生成。连接器模块将视觉和语言特征对齐,使两者能够协同工作。

虽然这种架构是标准的,但 Molmo 的训练流程包含几个巧妙的工程决策。

一个重要的理念是重叠多区域裁剪策略。高分辨率图像尺寸过大,无法一次性处理,因此会被分割成较小的正方形区域。但这可能会意外地将重要的物体切成两半。Molmo 通过让裁剪区域相互重叠来解决这个问题,这样位于一个裁剪区域边界上的物体就能完整地出现在另一个裁剪区域内。这有助于模型更一致地识别完整的物体。

另一个改进之处在于 PixMo Cap 数据集的质量。许多 VLM 需要使用噪声较大的网络数据进行长时间的连接器训练。而 Molmo 则无需此步骤,因为 PixMo Cap 数据集本身就足够强大,可以直接用于训练。这简化了训练过程并降低了噪声。

作者还设计了一种处理包含多个问题的图像的高效方法。他们不再反复将同一图像输入模型,而是对图像进行一次编码,然后处理单个掩码序列中的所有问题。这使得训练时间缩短了一半以上。

Molmo 在预训练阶段也使用了纯文本 dropout。有时模型无法看到文本标记,因此必须更加依赖视觉信息。这可以防止模型仅仅通过语言模式预测下一个标记,从而增强其对真实视觉的理解。

这些选择彼此相互支持,并增加了从数据集中获得的价值。

莫尔莫的优势

Molmo的主要优势如下:

对高级数据有深刻的理解

PixMo Cap 中的语音字幕为 Molmo 提供了更丰富的视觉知识基础。

莫尔莫看到的不是像“一只棕色的狗在接飞盘”这样的简短描述,而是包含光照条件、拍摄角度、背景虚化、物体纹理、情感暗示和隐含运动等信息的长篇描述。这有助于他形成更深入、更细致的视觉表征。

通过指点培养新的推理能力

PixMo Points 数据集开启了新的推理方式。

例如,当被问及“这张图片里有多少辆车?”时,许多车辆定位系统(VLM)只是简单地猜测一个数字。而Molmo则执行一个循序渐进的过程。它逐一指向每辆车,然后给出最终计数。这使得推理过程清晰可见,易于验证。此外,它也使得错误更容易修复,并为未来需要像素级指令的系统(例如机器人)铺平了道路。

更好地发挥数据和训练之间的协同作用

Molmo 的成功源于高质量数据和为最大化利用这些数据而构建的训练流程的结合。

重叠裁剪有助于保留细节。高效的批处理可以在更短的时间内使用更多的指令数据。仅文本的dropout迫使模型从图像中学习。高质量的图像描述减少了对噪声训练阶段的需求。

这些要素相互促进,从而创造出一种更清晰、更有效的多模式训练方法。

结论

Molmo 和 PixMo 项目表明,无需复制专有系统,即可构建强大的视觉语言模型。

这表明,高质量的人类数据可以优于封闭模型生成的合成数据。它还突显了精心设计的数据集如何能够简化训练过程并同时提升结果。

这种基于第一性原理的方法可能是这项工作吸引大型人工智能实验室浓厚兴趣的原因之一。它为研究界提供了一种构建强大、可复现且真正开放的多模态模型的方法。

赞助我们

让您的产品触达超过 100 万名科技专业人士。

我们的新闻简报会将您的产品和服务直接推送给重要的受众——数十万名工程领导者和高级工程师——他们对重大的技术决策和大宗采购具有影响力。

名额有限,立即预订!

广告位通常提前约 4 周售罄。为确保您的广告触达这一极具影响力的受众群体,请立即发送电子邮件至[email protected] 预订您的广告位。