单击右下角下载或在 Apple Podcasts、Spotify、Stitcher 等上查找。

如果由于先进的人工智能,这最终成为最重要的世纪,那么事情进展顺利或进展不顺利的关键因素是什么?

(点击展开)关于为什么人工智能可以使这个世纪成为最重要的世纪的更多细节

在最重要的世纪,我认为 21 世纪可能是人类有史以来最重要的世纪,通过先进的人工智能系统的发展,可以大大加快科学和技术的进步,让我们比大多数人想象的更快地进入一个深刻的世界。陌生的未来。

此页面有约 10 页的系列摘要,以及指向音频版本、播客和完整系列的链接。

我在该系列中主张的要点是:

- 长期的未来是完全陌生的。技术的足够进步可能会导致一个持久的、银河系范围内的文明,它可能是一个激进的乌托邦、反乌托邦,或者介于两者之间的任何东西。

- 由于 AI 驱动的生产力爆炸式增长,从长远来看,未来的到来可能比我们想象的要快得多。

- 相关类型的AI 看起来将在本世纪开发– 使本世纪成为将启动并有机会塑造未来银河系文明的世纪。

- 这些说法似乎过于“狂野”,无法认真对待。但是有很多理由认为我们生活在一个狂野的时代,应该为任何事情做好准备。

- 我们,生活在这个世纪的人,有机会对未来的大量人产生巨大影响——如果我们能够充分理解这种情况并找到有益的行动。但是现在,我们还没有为此做好准备。

我之前的很多文章都特别关注“错位人工智能”的威胁:人工智能可能有其自身的危险目标并击败全人类。在这篇文章中,我将缩小范围,更广泛地概述变革性人工智能可能为社会带来的多个问题——重点是我们现在可能想要考虑的问题,而不是等到它们发生时才去解决。

我的讨论将非常不令人满意。 “决定变革性人工智能进展顺利或不顺利的关键因素是什么?”是一个庞大的话题,有很多角度几乎没有引起注意,而且(当然)有很多我根本没有想到的角度。我对整个情况的一句话总结是:我们还没有准备好。

但希望这能让我们明白应该明确关注哪些问题。希望它能说明为什么——在我们需要应对的所有问题中——我像我一样专注于错位人工智能的威胁。

大纲:

- 首先,我将简要说明我要列出的问题类型。我正在寻找未来可能持久和显着不同的方式,这取决于我们如何驾驭变革性人工智能的发展——这样提前做正确的事情可能会产生重大而持久的变化。

- 然后,我将列出候选问题:

- 错位的人工智能。我只是简单地谈到这一点,因为我在之前的文章中已经详细讨论过它。简而言之,我们应该尽量避免 AI 以其自身的危险目标结束并击败人类。 (如果发生这种情况,下面的其余问题似乎无关紧要!)

- 权力不平衡。随着 AI 加速科学技术发展,它可能会导致一些国家 / 国家 / 联盟变得非常强大 – 因此,哪个(哪些)在变革性 AI 方面处于领先地位非常重要。 (我担心与未对齐的 AI 相比,这种担忧通常被高估了,但它仍然非常重要。)过度广泛(而不是集中)的 AI 部署也可能存在危险。

- 人工智能的早期应用。早期人工智能的用途可能会长期影响事情的长期发展——例如,早期人工智能系统是否用于教育和寻求真相,而不是操纵性说服和/或巩固我们已经相信的东西。我们或许能够在早期影响哪些用途占主导地位。

- 新的生命形式。先进的人工智能可能会带来新的智能生活形式,例如人工智能系统本身和/或数字人。我们习惯的许多框架,关于道德和法律,最终可能需要对新型实体进行相当多的重新思考(例如,我们是否应该允许人们根据需要制作任意数量的实体副本?以某种方式投票?)对这类问题的早期决定可能会产生长期影响。

- 持久的政策和规范。也许我们应该确定特别重要的政策、规范等,即使通过快速的技术进步,这些政策、规范似乎也可能持久,并在开发出变革性人工智能之前尽可能地改进这些政策、规范。 (这些可能包括适合高失业率、持续高失业率的更好的社会安全网;旨在避免偏见的更好的监管等。)

- 发展速度。也许人类社会不太可能很好地适应科学技术快速、激进的进步,找到一种方法来限制进步的步伐会很好。

- 最后,我将讨论我是如何考虑目前优先考虑这些问题中的哪些问题,以及为什么错位的 AI 是我关注的焦点。

- 附录将就生活质量而言,假设我们以非惊人但非灾难性的方式解决上述问题,从长远来看,未来是否会比今天更好或更糟。

我要列出的问题类型

您可以从一个基本角度看待 AI:

“人工智能的主要作用将是大大加快科学技术的发展。这意味着人类将能够做他们以前做过的所有事情——好的和坏的——但更多/更快。所以基本上,我们最终会拥有与没有 AI 时相同的未来——只是更快。

“因此,除了我们通常会为更美好的未来(在没有人工智能的世界中)而努力之外,没有必要提前为任何特别的事情做准备。当然,随着科学技术的进步,可能会发生很多奇怪的事情——但这已经是事实,而且许多风险现在很难预测,但在发生时更容易应对。”

我不同意上述观点,但我确实认为这是一个很好的起点。我认为我们不应该把未来可能发生的一切都罗列出来,因为人工智能会导致科技进步,并试图为此做好准备。相反,我们应该问: “如果变革性人工智能在未来几十年出现,这将如何改变我们应该关注的画面,而不仅仅是加速即将发生的事情? ”

我将尝试专注于风险极高的问题——我可以想象未来的方式会持久且截然不同,具体取决于我们如何驾驭变革性 AI 的发展。

下面,我将列出一些符合这些标准的候选问题。

潜在问题

错位的人工智能

我不会详细说明这种可能性,因为最近几篇文章都集中讨论了它;这只是一个快速提醒。

在一个没有人工智能的世界里,关于长远未来的主要问题将是人类最终将如何对待彼此。但是,如果在未来几十年内开发出强大的人工智能系统,我们需要应对这样一种可能性,即这些人工智能系统最终将拥有自己的目标——并取代人类成为决定事物如何发展的物种。

(点击展开)为什么人工智能会“旨在”打败人类?

之前的一篇文章认为,如果今天的 AI 开发方法直接导致足够强大的 AI 系统,那么默认情况下很可能会发生灾难(在没有具体对策的情况下)。

简单来说:

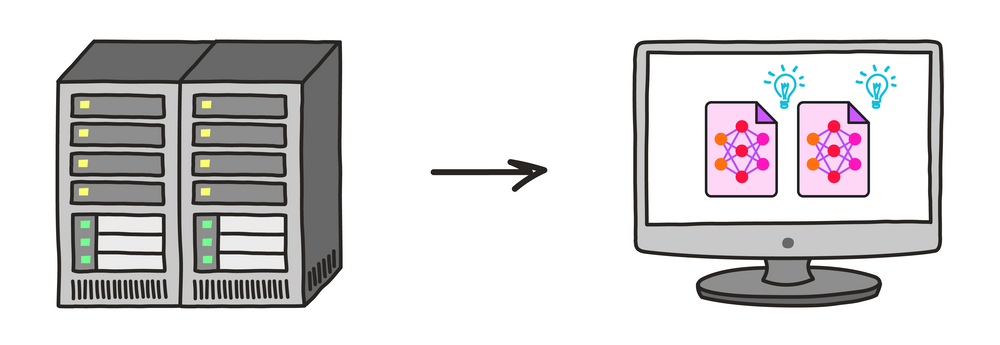

- 现代人工智能的发展本质上是基于通过反复试验进行的“训练”。

- 如果我们通过这种训练不谨慎而雄心勃勃地前进,并且如果它让我们一路发展到非常强大的人工智能系统,那么这些系统可能最终会针对世界的某些状态(类似于下棋人工智能的目标)将军) 。

- 这些状态将不是我们想要的,因为我们的试错训练方法不会准确。例如,当我们对某些问题感到困惑或被误导时,我们会奖励给出错误答案的 AI 系统——无意中训练欺骗行为。

- 如果我们的 AI 系统 (a)强大到足以打败人类,并且 (b) 瞄准我们不想要的世界状态,我们应该预料到灾难。 (“击败”意味着控制世界并采取必要措施使我们远离障碍;我不清楚我们是真的被杀死还是被强行阻止1以与 AI 系统的目标相矛盾的方式改变世界.)

(点击展开)人工智能如何打败人类?

在之前的一篇文章中,我认为人工智能系统可以击败全人类,如果(无论出于何种原因)他们旨在实现这一目标。

通过打败人类,我的意思是获得对世界的控制权,以便人工智能而不是人类来决定其中发生的事情;这可能涉及杀死人类或以某种方式简单地“收容”我们,这样我们就无法干扰 AI 的目标。

发生这种情况的一种方式是,如果人工智能变得极其先进,以至于它拥有超越人类所能做到的“认知超能力”。在这种情况下,可以想象单个 AI 系统(或一组协同工作的系统):

- 对如何构建更好的 AI 系统进行自己的研究,最终形成具有令人难以置信的其他能力的东西。

- 侵入世界各地的人工软件。

- 操纵人的心理。

- 在自身或任何人类盟友的控制下迅速产生巨大的财富。

- 提出比人类想象的更好的计划,并确保它不会尝试任何人类可能能够检测和阻止的接管尝试。

- 开发可以快速廉价制造的先进武器,但其威力足以压倒人类军队。

然而,我的文章还探讨了如果每个 AI 系统基本上都具有与人类相似的能力,事情会是什么样子。在这种情况下:

- 人类可能会在整个经济中部署人工智能系统,这样他们就拥有大量的资源并可以访问许多资源——以及复制自己的能力。

- 从这个起点开始,具有类似人类(或更强大)能力的人工智能系统将有许多可能的方法来达到其总人口可能超过和/或资源超过人类的程度。

- 我解决了一些可能的反对意见,例如“没有身体的 AI 怎么可能是危险的?”

权力失衡

我认为人工智能可能会导致科学和技术进步的步伐急剧加快。

(点击展开)人工智能如何带来爆炸性进步

(这部分主要是从我对“最重要的世纪”系列的总结中复制的;它链接到底部有更多细节的部分。)

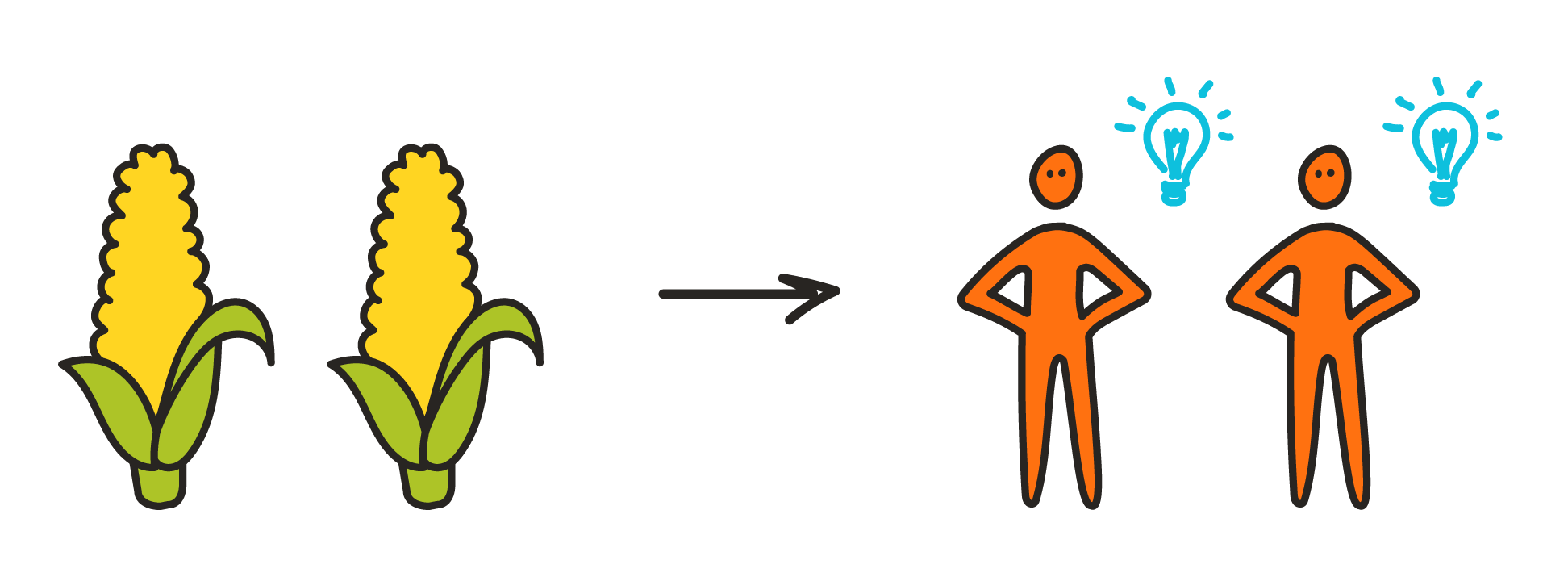

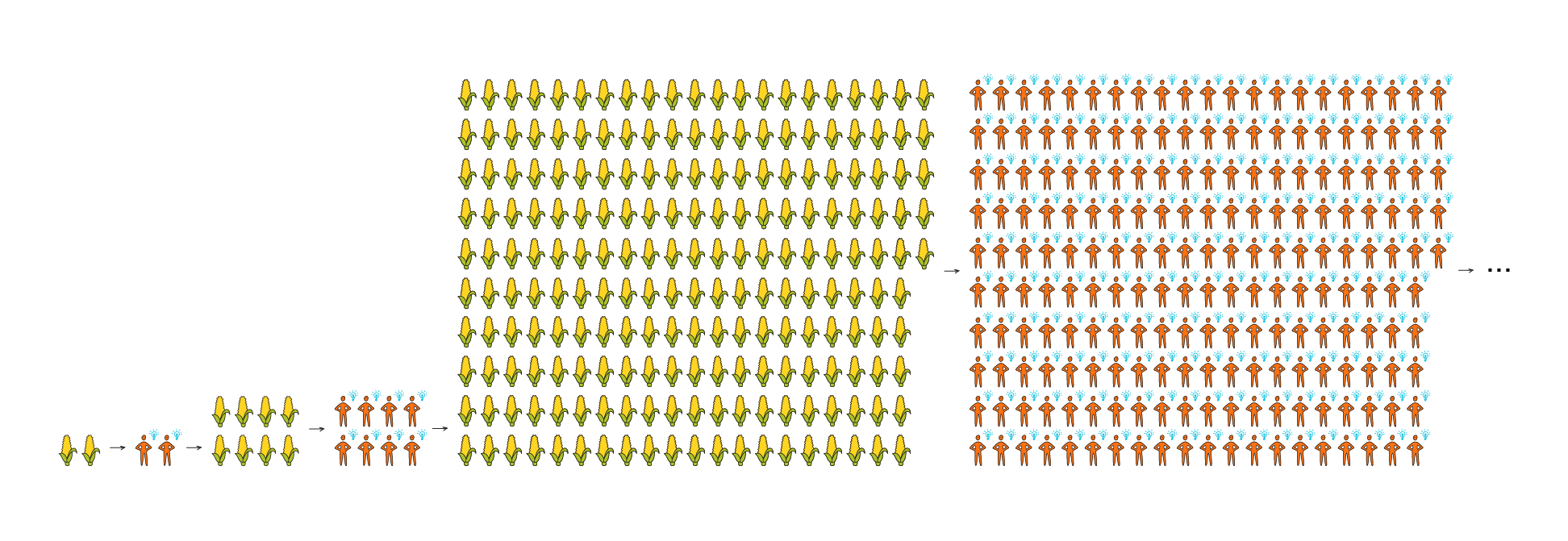

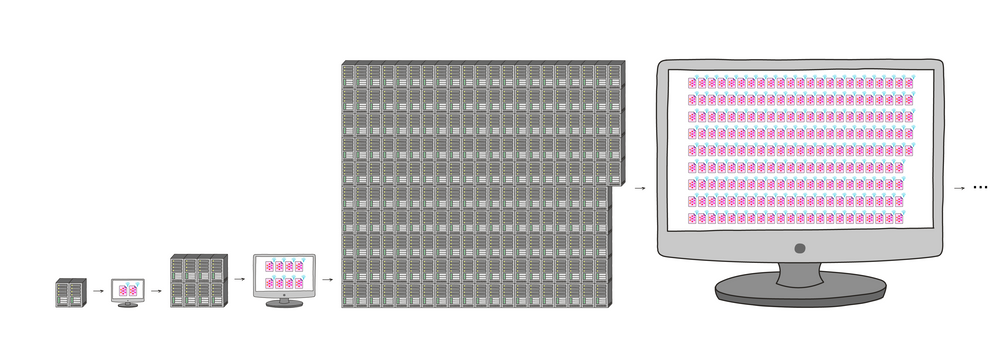

标准的经济增长模型暗示,任何可以完全自动化创新的技术都会导致“经济奇点”:本世纪生产力将达到无穷大。这是因为它会创建一个强大的反馈循环:更多资源 -> 更多想法和创新 -> 更多资源 -> 更多想法和创新……

这种循环并非前所未有。我认为从某种意义上说,这是经济运行的“默认”方式——直到几百年前的大部分经济历史。

经济史:更多的资源->更多的人->更多的想法->更多的资源…

经济史:更多的资源->更多的人->更多的想法->更多的资源…

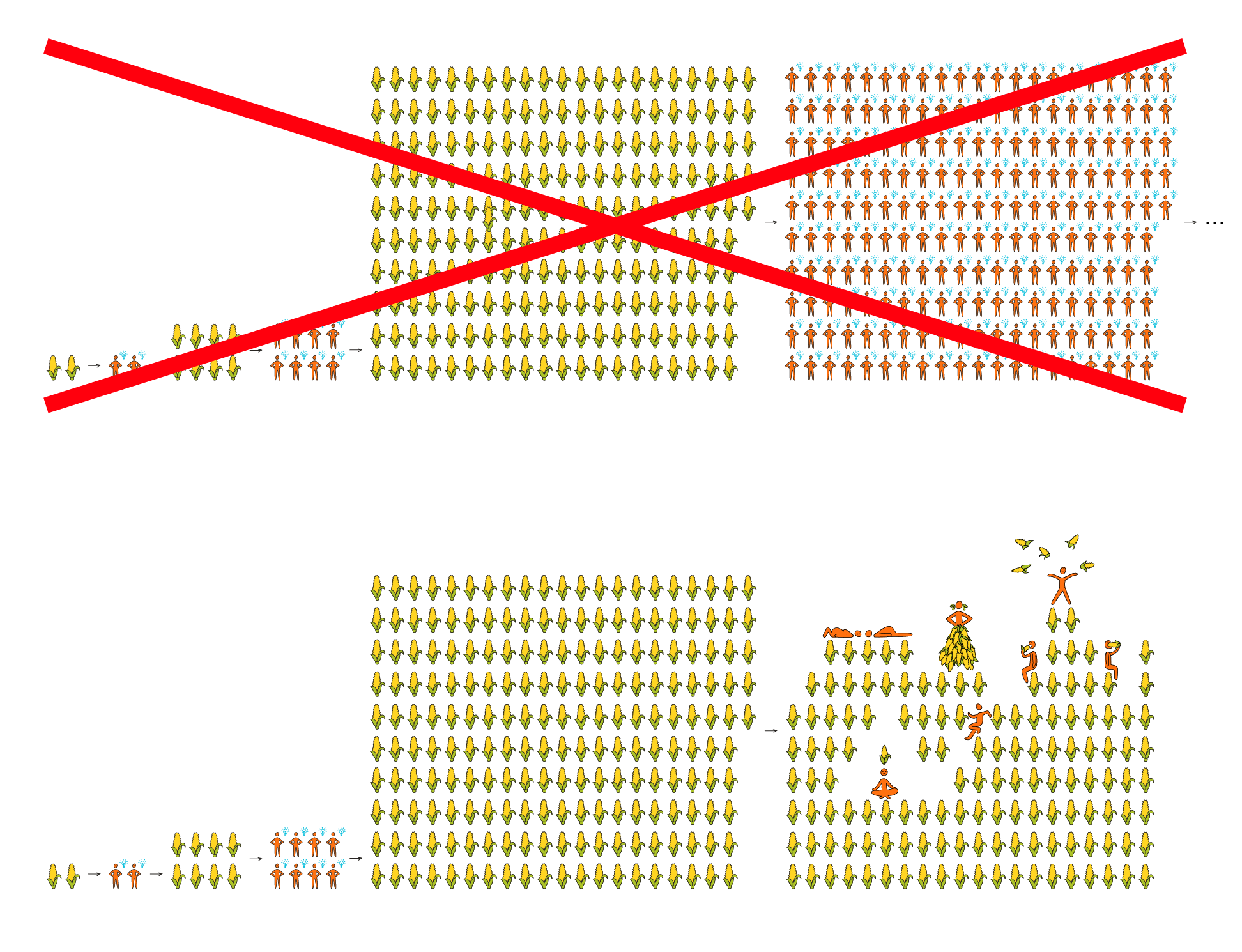

但在几百年前的“人口转变”中,该循环的“更多资源 -> 更多人”步骤停止了。人口增长趋于平稳,更多的资源导致了更富有的人,而不是更多的人:

当今经济:更多资源 ->

当今经济:更多资源 ->更多的更富有的人 -> 相同的想法 -> …

如果其他一些技术恢复了“更多资源 -> 更多想法”的动态,反馈循环可能会回来。一种这样的技术可能是正确的人工智能类型:我称之为 PASTA,或自动化科学和技术进步的过程。

可能的未来:更多资源 -> 更多 AI -> 更多想法 -> 更多资源 …

可能的未来:更多资源 -> 更多 AI -> 更多想法 -> 更多资源 …

这意味着在开发出 PASTA 之后(如果有的话),我们激进的长期未来可能会很快到来。

这也意味着,如果 PASTA 系统错位——追求它们自己与人类不兼容的目标——事情可能很快就会偏离正轨。

关键部分:

一种思考方式:也许(出于我之前争论过的原因)人工智能可以在几个月(或更快)的时间内实现相当于数百年的科学和技术进步。如果是这样,那么比其他人早几个月开发出强大的 AI 可能会导致拥有(实际上)领先于其他人数百年的技术。

正因为如此,很容易想象人工智能会导致巨大的权力失衡,因为任何在人工智能发展上“领先”的国家/国家/联盟都可能变得比其他国家强大得多(也许类似于一些欧洲小国采取行动时)在世界其他大部分地区)。

我们可能会尝试让未来变得更好的一种方式:也许不同的国家/联盟有可能提前达成协议。例如,两个势均力敌的一方可能会事先约定彼此共享资源、领土等,以避免出现赢者通吃的竞争。

这样的协议可能是什么样的?他们可能被强制执行吗?我真的不知道,而且我还没有看到对此进行太多探索。 1个

人们可能试图让未来变得更好的另一种方法是尝试帮助特定国家、联盟等先于其他国家开发强大的人工智能系统。我之前将其称为“竞争”框架。

我认为,事实上,谁在变革性人工智能方面引领潮流非常重要。与此同时,我担心人们可能会过度关注事物的这一方面而不是其他问题,原因有很多,包括:

- 我认为人们自然会更热衷于“帮助好人打败坏人”,而不是“帮助我们所有人避免得到普遍糟糕的结果,出于非个人原因,例如‘我们设计了草率的 AI 系统’或‘我们创造了一个动态的匆忙和侵略得到回报。’”

- 我预计人们会对他们认为哪些国家、组织或人是“好人”过于自信。

(更多在这里。)

最后,值得一提的是强大的 AI 过于广泛而不是过于集中可能带来的危险。在脆弱的世界假说中,尼克·博斯特罗姆 (Nick Bostrom) 考虑了潜在的未来动态,例如“DIY 生物黑客工具的进步可能使任何受过基础生物学培训的人都能轻松杀死数百万人。”除了避免人工智能能力最终集中在少数人手中的世界之外,在我们能够评估广泛获取技术的风险之前,避免人工智能能力扩散得太广、太快的世界也很重要远远超过今天。

人工智能的早期应用

也许先进的 AI 会先于其他任务对某些类型的任务有用。例如,也许——默认情况下——先进的人工智能系统很快就会成为强大的说服工具,并在它们引起科学技术的快速进步之前引起广泛的社会功能障碍。也许,通过努力,我们可以降低这种情况发生的可能性——早期人工智能系统更有可能用于教育和寻求真相,而不是操纵性说服和/或巩固我们已经相信的东西。

这种一般形式可能有很多可能性:在 AI 成为科学和技术的通用加速器之前,它可以通过特定方式以可预测的方式带来好处或破坏性。或许今天尝试将这些映射出来,并推动高级人工智能尽早用于特定目的,可能会对未来产生持久影响。

新的生命形式

先进的人工智能可能会带来新的智能生活形式,例如人工智能系统本身和/或数字人。

数字人:未来多么疯狂的一个例子

在之前的一篇文章中,我试图通过研究一种假设技术:“数字人”来了解先进技术的未来会有多疯狂。

要了解数字人的概念,请想象在虚拟环境中对特定人进行计算机模拟。例如,模拟您对所有“虚拟事件”做出反应——虚拟饥饿、虚拟天气、带有收件箱的虚拟计算机——就像您会做的那样。

我认为数字人可能会像我们一样有意识并应享有人权。我认为它们可能会产生重大影响,尤其是:

- 生产率。数字人可以被复制,就像我们今天可以轻松复制任何软件一样。它们也可以比人类跑得快得多。正因为如此,数字人可能会产生与复印机相当的效果,但更重要的是:前所未有的(在历史或科幻电影中)经济增长和生产力水平。

- 社会科学。今天,我们看到在理解科学规律和开发炫酷新技术方面取得了很大进步,但在理解人性和人类行为方面却没有那么多进步。数字人将从根本上改变这种动态:人们可以复制自己(包括加速的临时副本)以探索不同的选择、生活方式和环境如何影响他们。比较副本将以当前社会科学很少提供的方式提供信息。

- 环境控制。数字人将体验他们(或他们的虚拟环境的控制者)想要的任何世界。假设数字人有真正的意识体验( 常见问题解答中讨论的假设),这可能是好事(应该有可能消除数字人的疾病、物质贫困和非自愿暴力)或坏事(如果人权没有受到保护,数字人可能会受到可怕的控制)。

- 空间扩张。数字人的数量可能会变得惊人地庞大,而运行他们的计算机最终可能会分布在我们的银河系乃至更远的地方。数字人可以存在于任何可以运行计算机的地方——所以太空定居点对数字人来说比对生物人来说更直接。

- 锁定。在当今世界,我们已经习惯了未来不可预测和无法控制的想法。政治体制、意识形态和文化都来来去去(和演变)。但数字化人群组成的社区、城市或国家可能会稳定得多。

- 数字人不需要死亡或衰老。

- 无论谁建立一个包含数字人社区的“虚拟环境”,都可以对该社区的样子有相当长的控制权。例如,他们可能会构建软件以在特定情况发生变化时将社区(包括虚拟环境和其中的人)重置为较早的状态 – 例如谁掌权,或者哪种宗教占主导地位。

- 我认为这是一个令人不安的想法,因为它可以实现长期的威权主义,尽管它也可以实现对特定人权的永久保护。

我认为这些影响可能是好事也可能是坏事。数字人的早年经历如何,将不可逆转地决定是哪一个。

更多的:

我们习惯的许多框架,用于道德和法律,最终可能需要对新型实体进行相当多的重新思考。例如:

- 我们应该如何确定哪些人工智能系统或数字人被认为拥有“权利”并获得法律保护?

- 投票权呢?如果一个人工智能系统或数字人可以被快速复制数十亿次,每次复制都获得投票,那可能会带来麻烦——这是否意味着我们应该限制复制、限制投票或其他什么?

- 关于工程 AI 系统或数字人具有特定信仰、动机、经验等的规则应该是什么?简单的例子:

- 创建新的 AI 系统或数字人会遭受很多可预见的痛苦,这应该是非法的吗?多少苦难才算过分?

- 如何创建始终如一地、可预测地支持某些特定政党或观点的人工智能系统或数字人?

(有关这方面的更多信息,请参阅Nick Bostrom 和 Carl Shulman 撰写的这篇非常有趣的文章。)

对这类问题的早期决定可能会产生长期影响。例如,想象一下有人创造了数十亿个人工智能系统或数字人,这些系统或数字人具有与人类相当的能力和主观体验,并且被故意设计为“相信”(或至少帮助促进)某些特定的意识形态(共产主义、自由意志主义等)。如果这些系统能够自我复制,那可能会彻底改变未来。

因此,在新型数字实体开始繁殖之前,为如何处理新型数字实体的棘手问题制定良好的原则可能很重要。

一贯的政策和规范

可能有一些特定的政策、规范等可能会保持不变,即使技术在进步并且许多事情正在发生变化。

例如,人们对道德和规范的看法可能天生就比技术能力的变化慢。也许一个拥有强大的动物权利保护和普遍的亲动物态度的社会,会通过爆炸性的技术进步一直保持这些特性,成为一个善待动物的技术先进社会——而一个不尊重动物的社会将成为一个技术先进的社会,却虐待动物。类似的分析可以适用于宗教价值观、社会自由主义与保守主义等。

因此,也许我们应该确定特别重要的政策、规范等,即使通过快速的技术进步,这些政策、规范似乎也可能持久,并在开发出变革性人工智能之前尽可能地改进这些政策、规范。

我在这一类别中提出的一个担忧的具体例子是:如果 AI 将导致高、持续的技术失业,那么今天建立新的社会安全网计划(例如全民基本收入)可能很重要——如果这些计划能够今天比将来更容易建立。我不太相信这个——首先是因为我对技术性失业问题的严重性有一些怀疑,其次是因为我不清楚为什么今天的政策变化会比技术性失业的未来更容易一个现实。更广泛地说,我担心今天很难设计和(政治上)实施我们可以确信的政策,随着世界的根本变化,这些政策将使事情持久变得更好。

放慢速度?

我列举了一些奇怪的事情——比如权力不平衡,以及社会的某些部分比其他部分变化得更快——可能会随着科学和技术进步的加速而发生。也许让最重要的世纪顺利进行的一种方法就是通过避免过于剧烈的加速来简单地避免这些奇怪的事情。也许人类社会不太可能很好地适应科学技术快速、激进的进步,找到一种方法来限制进步的步伐会很好。

任何单个公司、政府等都有快速行动并试图领先于他人(或不要落后太多)的动机,但协调一致的协议和/或法规(按照此处讨论的“全球监控”可能性) ) 可以帮助每个人移动得更慢。

还有什么?

是否还有其他方法可以让变革性人工智能导致特定问题、风险等显得尤为突出,并且在今天值得特别关注?我猜我在这里只触及了表面。

我目前优先考虑的事情

如果这是最重要的世纪,那么有大量的事情需要考虑和准备,而且很难知道优先考虑什么。

我现在所在的位置:

今天似乎很难说在一个截然不同的未来什么是可取的。我希望更多的思考和关注进入人工智能的早期应用;围绕新生命形式的规范和法律;以及即使世界正在迅速而彻底地变化,我们今天是否可以对政策变化充满信心。但在我看来,很难对这些领域的任何特定目标充满信心。我们今天真的可以说什么类型的数字实体应该拥有权利,或者我们希望优先考虑哪些类型的 AI 应用程序,我们希望支持这些应用程序吗?

我对两个非常宽泛的想法最有信心:“如果 AI 系统打败人类来追求自己的目标,那是不好的”和“如果优秀的决策者最终做出关键决定,那就太好了。”这些映射到错位的 AI和权力失衡主题——或者我之前所说的谨慎和竞争。

也就是说,似乎也很难知道谁是“好的决策者”。我确实观察到了其中的一些动态:“A 人/公司说他们正试图通过在 B 人/公司之前建立变革性 AI 来帮助世界;个人/公司 B 说他们正在努力通过在个人/公司 A 之前建立变革性人工智能来帮助世界。”

很难对谁是“好的决策者”提出具体的测试。根据他们今天的行为,我们大多不知道拥有巨大权力的人 A 会做什么,或者 B 会做什么。一个可能的标准是,我们可以说应该更加信任表现出更多谨慎的人/公司——表现出愿意损害自己“处于领先地位”的机会以帮助每个人避免错位灾难的机会的人/公司人工智能。 2个

(与其关注哪些特定的人和/或公司在人工智能方面处于领先地位,不如关注哪些国家在引领人工智能,例如更喜欢非专制国家。可以说非专制国家比专制国家更好。但是,我也对此作为目标感到担忧,在脚注中进行了讨论。3 )

目前,我最关注的是错位人工智能的威胁。这样做的一些原因:

- 目前在我看来,错位的人工智能是一个重大风险。如果我们不专门做一些事情来防止它,那么默认情况下人工智能似乎很可能会错位,而且防止它似乎远非直截了当(请参阅之前关于对齐研究的难度以及为什么关键参与者很难保持谨慎的帖子)。

- 与此同时,我们似乎对如何避免这种风险抱有很大希望。正如这里和这里所争论的那样,我的感觉是人们对这种风险的了解越广泛,我们避免它的几率就越大。

- 我目前觉得这种威胁被低估了,相对于“我希望我喜欢的人比其他人开发出强大的人工智能系统”更容易理解的角度。

- 我认为“竞争”框架——专注于帮助一些国家/联盟/公司在其他国家/地区之前开发先进的人工智能——也很有道理。但是——正如上面直接指出的——我对最常见的以“竞争”为导向的行动持很大保留意见,例如试图帮助特定公司超越其他公司或试图让美国政策制定者更加关注人工智能。

- 对于后者,我担心这可能会在“谨慎”方面做出巨大牺牲,甚至会导致其他政府投资于自己的项目,从而适得其反。

- 对于前者,我担心判断“好”领导的能力,以及高估与自己相似的人的诱惑。

这远非绝对。我对各种各样的项目持开放态度,以帮助最重要的世纪顺利进行,无论它们是关于“谨慎”、“竞争”还是其他问题(包括我在这篇文章中列出的那些)。我目前的首要任务是降低人工智能错位的风险,但我认为大量的潜在风险没有得到全世界的足够重视。

附录:如果我们避免灾难性风险,未来会怎样?

在这里,我将就生活质量而言,从长远来看,未来是否会比今天更好或更糟,我将略微谈一谈。

我想这样做的部分原因是要说明为什么我对这样的未来感到谨慎和适度乐观——这样我对“我们应该努力防止任何太灾难性的事情发生,并且认为如果我们能够实现这一目标,我们得到的未来很有可能(尽管还远未确定!)是美好的。”

因此,我将通过一些快速的高级理由来表达希望(未来可能比现在更好)和担忧(可能更糟)。

在本节中,我将忽略 AI 可能扮演的特殊角色,而只是思考如果我们拥有一个快进的未来会发生什么。我将重点关注我认为未来世界最有可能发生变化的方式,如下所示:由于更多的想法、创新和技术能力,世界人口增加,权力更大。我的目的是要问:“如果我们解决上述问题既不是惊人的也不是灾难性的,并且最终拥有与没有 AI 时相同的未来(只是加速),那么事情看起来如何?”

希望的理由:赋权趋势。一个简单的理解是:“人类4的生活在过去几百年左右的时间里变得更好了,在这段时间里,我们见证了历史上大部分的经济增长和技术进步。”我们看到了更好的健康状况、更少的贫困和饥饿、更少的暴力、更多的反歧视措施,并且几乎没有任何迹象表明任何事情正在变得更糟。因此,如果人类不断获得越来越强大的力量,而没有发生任何灾难性事件,我们就应该计划让生活在各个方面继续改善。”

为什么会出现这种趋势,我们是否应该期待它会持续下去?有很多理论,我不会假装知道,但我会列出一些可能具有说明性并让人乐观的基本想法。

首先,仅仅通过继续减少饥饿和疾病等因素,就有很大的改进空间。 A wealthier, more technologically advanced society seems like a pretty good bet to have less hunger and disease for fairly straightforward reasons.

But we’ve seen improvement on other dimensions too. This could be partly explained by something like the following dynamic:

- Most people would – aspirationally – like to be nonviolent, compassionate, generous and fair, if they could do so without sacrificing other things.

- As empowerment rises, the need to make sacrifices falls (noisily and imperfectly) across the board.

- This dynamic may have led to some (noisy, imperfect) improvement to date, but there might be much more benefit in the future compared to the past. For example, if we see a lot of progress on social science , we might get to a world where people understand their own needs, desires and behavior better – and thus can get most or all of what they want (from material needs to self-respect and happiness) without having to outcompete or push down others. 5

Reason for hope: the “cheap utopia” possibility. This is sort of an extension of the previous point. If we imagine the upper limit of how “empowered” humanity could be (in terms of having lots of technological capabilities), it might be relatively easy to create a kind of utopia (such as the utopia I’ve described previously , or hopefully something much better). This doesn’t guarantee that such a thing will happen, but a future where it’s technologically easy to do things like meeting material needs and providing radical choice could be quite a bit better than the present.

An interesting (wonky) treatment of this idea is Carl Shulman’s blog post: Spreading happiness to the stars seems little harder than just spreading .

Reason for concern: authoritarianism. There are some huge countries that are essentially ruled by one person, with little to no democratic or other mechanisms for citizens to have a voice in how they’re treated. It seems like a live risk that the world could end up this way – essentially ruled by one person or relatively small coalition – in the long run. (It arguably would even continue a historical trend in which political units have gotten larger and larger.)

Maybe this would be fine if whoever’s in charge is able to let everyone have freedom, wealth, etc. at little cost to themselves (along the lines of the above point). But maybe whoever’s in charge is just a crazy or horrible person, in which case we might end up with a bad future even if it would be “cheap” to have a wonderful one.

Reason for concern: competitive dynamics. You might imagine that as empowerment advances, we get purer, more unrestrained competition .

One way of thinking about this:

- Today, no matter how ruthless CEOs are, they tend to accommodate some amount of leisure time for their employees. That’s because businesses have no choice but to hire people who insist on working a limited number of hours, having a life outside of work, etc.

- But if we had advanced enough technology, it might be possible to run a business whose employees have zero leisure time. (One example would be via digital people and the ability to make lots of copies of highly productive people just as they’re about to get to work . A more mundane example would be if eg advanced stimulants and other drugs were developed so people could be productive without breaks.)

- And that might be what the most productive businesses, organizations, etc. end up looking like – the most productive organizations might be the ones that most maniacally and uncompromisingly use all of their resources to acquire more resources. Those could be precisely the organizations that end up filling most of the galaxy.

- More at this Slate Star Codex post . Key quote: “I’m pretty sure that brutal … competition combined with ability to [copy and edit] minds necessarily results in paring away everything not directly maximally economically productive. And a lot of things we like – love, family, art, hobbies – are not directly maximally economic productive.”

That said:

- It’s not really clear how this ultimately shakes out. One possibility is something like this:

- Lots of people, or perhaps machines, compete ruthlessly to acquire resources. But this competition is (a) legal, subject to a property rights system; (b) ultimately for the benefit of the investors in the competing companies/organizations.

- Who are these investors? Well, today, many of the biggest companies are mostly owned by large numbers of individuals via mutual funds. The same could be true in the future – and those individuals could be normal people who use the proceeds for nice things.

- If the “cheap utopia” possibility (described above) comes to pass, it might only take a small amount of spare resources to support a lot of good lives.

Overall, my guess is that the long-run future is more likely to be better than the present than worse than the present (in the sense of average quality of life ). I’m very far from confident in this. I’m more confident that the long-run future is likely to be better than nothing , and that it would be good to prevent humans from going extinct, or a similar development such as a takeover by misaligned AI.

Footnotes

-

A couple of discussions of the prospects for enforcing agreements here and here . ↩

-

I’m reminded of the judgment of Solomon : “two mothers living in the same house, each the mother of an infant son, came to Solomon. One of the babies had been smothered, and each claimed the remaining boy as her own. Calling for a sword, Solomon declared his judgment: the baby would be cut in two, each woman to receive half. One mother did not contest the ruling, declaring that if she could not have the baby then neither of them could, but the other begged Solomon, ‘Give the baby to her, just don’t kill him!’ The king declared the second woman the true mother, as a mother would even give up her baby if that was necessary to save its life, and awarded her custody.”

The sword is misaligned AI and the baby is humanity or something.

(This story is actually extremely bizarre – seriously, Solomon was like “You each get half the baby”?! – and some similar stories from India/China seem at least a bit more plausible. But I think you get my point. Maybe.) ↩

-

For a tangible example, I’ll discuss the practice (which some folks are doing today) of trying to ensure that the US develops transformative AI before another country does, by arguing for the importance of AI to US policymakers.

This approach makes me quite nervous, because:

- I expect US policymakers by default to be very oriented toward “competition” to the exclusion of “caution.” (This could change if the importance of caution becomes more widely appreciated!)

- I worry about a nationalized AI project that (a) doesn’t exercise much caution at all, focusing entirely on racing ahead of others; (b) might backfire by causing other countries to go for nationalized projects of their own, inflaming an already tense situation and not even necessarily doing much to make it more likely that the US leads the way. In particular, other countries might have an easier time quickly mobilizing huge amounts of government funding than the US, such that the US might have better odds if it remains the case that most AI research is happening at private companies.

(There might be ways of helping particular countries without raising the risks of something like a low-caution nationalized AI project, and if so these could be important and good.) ↩

-

Not for animals , though see this comment for some reasons we might not consider this a knockdown objection to the “life has gotten better” claim. ↩

-

This is only a possibility. It’s also possible that humans deeply value being better-off than others , which could complicate it quite a bit. (Personally, I feel somewhat optimistic that a lot of people would aspirationally prefer to focus on their own welfare rather than comparing themselves to others – so if knowledge advanced to the point where people could choose to change in this way, I feel optimistic that at least many would do so.) ↩

原文: https://www.cold-takes.com/transformative-ai-issues-not-just-misalignment-an-overview/